Erhältlich über

E/A-Diagramm 1

E/A-Diagramm 2

E/A-Diagramm 3

Wählen Sie Modelle zum Vergleichen aus

Publikationen (1)

Überblick

ReaderLM-v2 ist ein 1,5-B-Parameter-Sprachmodell, das reines HTML in Markdown oder JSON konvertiert und bis zu 512.000 Tokens kombinierte Eingabe-/Ausgabelänge mit Unterstützung für 29 Sprachen verarbeitet. Anders als sein Vorgänger, der HTML-zu-Markdown als „selektives Kopieren“ behandelte, geht v2 es als Übersetzungsprozess an und ermöglicht so eine bessere Verarbeitung komplexer Elemente wie Codezäune, verschachtelte Listen, Tabellen und LaTeX-Gleichungen. Das Modell behält eine konsistente Leistung über verschiedene Kontextlängen hinweg bei und führt direkte HTML-zu-JSON-Generierungsfunktionen mit vordefinierten Schemata ein.

Methoden

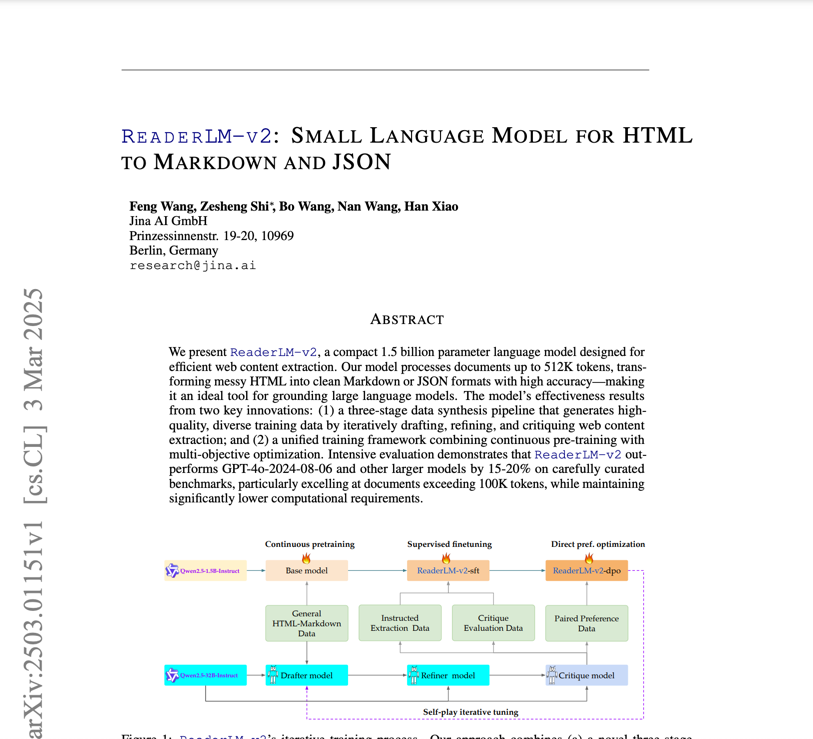

Das Training von ReaderLM-v2 basiert auf der Qwen2.5-1.5B-Anweisung und umfasste einen html-markdown-1m-Datensatz mit zehn Millionen HTML-Dokumenten und durchschnittlich jeweils 56.000 Token. Der Trainingsprozess umfasste: 1) Langkontext-Vortraining mit Ring-Zag-Attention und RoPE zur Erweiterung des Kontexts von 32.000 auf 256.000 Token, 2) überwachtes Feintuning mit verfeinerten Datensätzen, 3) direkte Präferenzoptimierung zur Ausgabeausrichtung und 4) Self-Play-Verstärkungstuning. Die Datenaufbereitung erfolgte in einem dreistufigen Prozess (Entwurf-Verfeinerung-Kritik) auf Basis der Qwen2.5-32B-Anweisung, wobei spezialisierte Modelle für spezifische Aufgaben trainiert und anschließend mittels linearer Parameterinterpolation zusammengeführt wurden.

Leistung

In umfassenden Benchmarks übertrifft ReaderLM-v2 größere Modelle wie Qwen2.5-32B-Instruct und Gemini2-flash-expr bei HTML-zu-Markdown-Aufgaben. Bei der Extraktion von Hauptinhalten erreicht es einen ROUGE-L von 0,84, einen Jaro-Winkler von 0,82 und eine deutlich niedrigere Levenshtein-Distanz (0,22) im Vergleich zu Mitbewerbern. Bei HTML-zu-JSON-Aufgaben hält es mit F1-Ergebnissen von 0,81 und einer Erfolgsquote von 98 % eine konkurrenzfähige Leistung aufrecht. Das Modell verarbeitet 67 Token/s Eingabe und 36 Token/s Ausgabe auf einer T4-GPU, wobei die Degenerationsprobleme durch kontrastives Verlusttraining deutlich reduziert werden.

Anleitung

Das Modell ist über ein Google Colab-Notebook zugänglich, das die Konvertierung von HTML in Markdown, die JSON-Extraktion und das Befolgen von Anweisungen demonstriert. Für HTML-zu-Markdown-Aufgaben können Benutzer reines HTML ohne Präfixanweisungen eingeben, während die JSON-Extraktion eine bestimmte Schemaformatierung erfordert. Die Hilfsfunktion create_prompt erleichtert die einfache Erstellung von Eingabeaufforderungen für beide Aufgaben. Obwohl das Modell auf der kostenlosen T4-GPU-Stufe von Colab funktioniert (erfordert vllm und triton), weist es ohne Unterstützung von bfloat16 oder Flash Attention 2 Einschränkungen auf. Für den Produktionseinsatz wird RTX 3090/4090 empfohlen. Das Modell wird auf AWS SageMaker, Azure und dem GCP-Marktplatz verfügbar sein und unter CC BY-NC 4.0 für die nichtkommerzielle Nutzung lizenziert sein.

Blogs, die dieses Modell erwähnen