Wählen Sie Modelle zum Vergleichen aus

Überblick

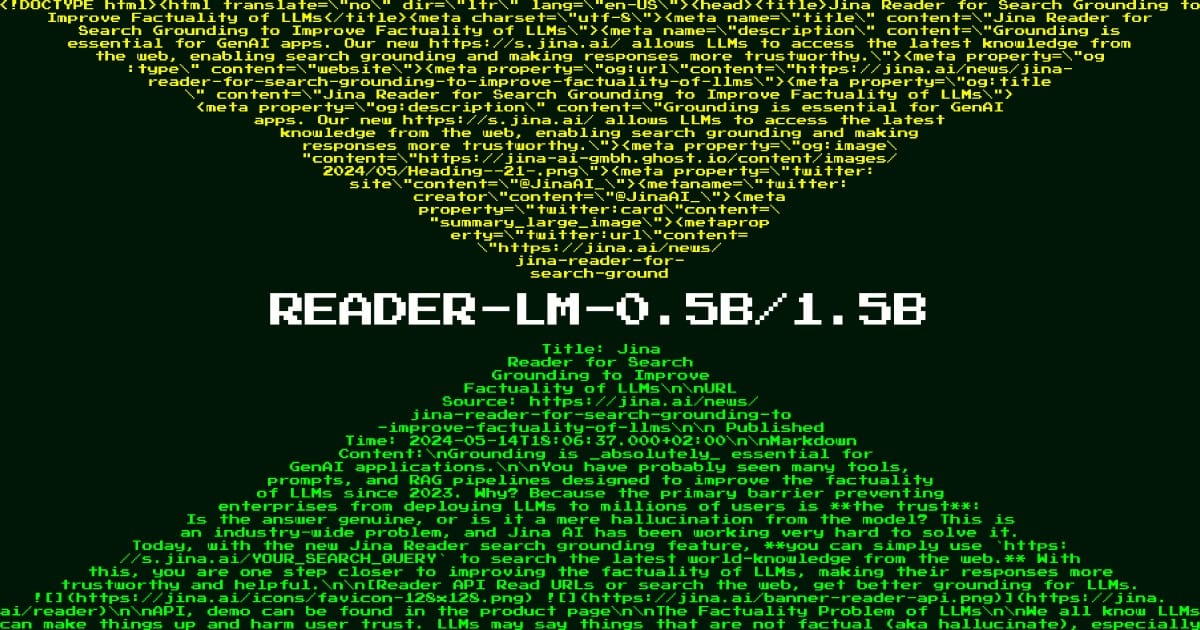

Reader LM 1.5B stellt einen Durchbruch in der effizienten Dokumentenverarbeitung dar und bewältigt die kritische Herausforderung, komplexe Webinhalte in saubere, strukturierte Formate umzuwandeln. Dieses spezialisierte Sprachmodell befasst sich mit einem grundlegenden Problem moderner KI-Pipelines: der Notwendigkeit, HTML-Inhalte für nachgelagerte Aufgaben effizient zu verarbeiten und zu bereinigen, ohne sich auf instabile regelbasierte Systeme oder ressourcenintensive große Sprachmodelle verlassen zu müssen. Was dieses Modell wirklich bemerkenswert macht, ist seine Fähigkeit, 50-mal so große Modelle zu übertreffen und dabei einen überraschend kompakten Parameter-Footprint von 1,54 B beizubehalten. Organisationen, die sich mit der Verarbeitung von Webinhalten im großen Maßstab, der Automatisierung von Dokumentationen oder Content-Management-Systemen befassen, werden dieses Modell besonders wertvoll finden, da es extrem lange Dokumente verarbeiten und gleichzeitig eine überragende Genauigkeit bei der Konvertierung von HTML in Markdown bieten kann.

Methoden

Das Modell verwendet eine innovative „flache, aber breite“ Architektur, die traditionelle Skalierungsansätze im Sprachmodelldesign in Frage stellt. Sein Kern sind 28 Transformer-Schichten, die mit 12 Abfrageköpfen und 2 Schlüssel-Wert-Köpfen konfiguriert sind, wodurch ein einzigartiges Gleichgewicht entsteht, das selektive Kopiervorgänge optimiert und gleichzeitig ein tiefes semantisches Verständnis aufrechterhält. Die Architektur verfügt über eine versteckte Größe von 1536 und eine Zwischengröße von 8960, die sorgfältig darauf abgestimmt ist, Sequenzen mit bis zu 256.000 Token zu verarbeiten. Der Trainingsprozess umfasste zwei unterschiedliche Phasen: Zuerst konzentrierte man sich auf kurzes und einfaches HTML mit 32.000 Tokensequenzen, dann ging es weiter zu langem und schwierigem HTML mit 128.000 Token, wobei Zickzack-Ring-Attention für eine effiziente Verarbeitung implementiert wurde. Dieser Ansatz, kombiniert mit kontrastiver Suche und speziellen Wiederholungserkennungsmechanismen, ermöglicht es dem Modell, häufige Probleme wie Degeneration und langweilige Schleifen zu vermeiden, die normalerweise kleinere Sprachmodelle plagen, die komplexe Dokumentverarbeitungsaufgaben bewältigen.

Leistung

In umfassenden Benchmark-Bewertungen zeigt Reader LM 1.5B außergewöhnliche Fähigkeiten, die Industriestandards herausfordern. Das Modell erreicht einen ROUGE-L-Score von 0,72 und eine Token-Fehlerrate von 0,19 und übertrifft damit größere Modelle wie GPT-4 (0,43 ROUGE-L, 0,50 TER) und Gemini-1.5-Pro (0,42 ROUGE-L, 0,48 TER) bei HTML-zu-Markdown-Konvertierungsaufgaben deutlich. Seine Leistung glänzt insbesondere bei qualitativen Bewertungen in vier Schlüsseldimensionen: Header-Extraktion, Hauptinhaltsextraktion, Erhaltung der Rich-Structure-Struktur und Verwendung der Markdown-Syntax. Das Modell behält bei verschiedenen Dokumenttypen, von Nachrichtenartikeln und Blogbeiträgen bis hin zu Landingpages und Forenbeiträgen, in mehreren Sprachen, darunter Englisch, Deutsch, Japanisch und Chinesisch, durchgängig eine hohe Genauigkeit bei. Diese Leistung wird bei der Verarbeitung von Dokumenten mit einer Länge von bis zu 256.000 Token erreicht, wodurch die Notwendigkeit teurer Chunking-Operationen entfällt, die normalerweise bei größeren Modellen erforderlich sind.

Anleitung

Um Reader LM 1.5B effektiv einzusetzen, sollten sich Organisationen auf Szenarien konzentrieren, die eine komplexe HTML-Dokumentenverarbeitung beinhalten, bei der Genauigkeit und Effizienz von größter Bedeutung sind. Das Modell erfordert eine CUDA-fähige GPU-Infrastruktur für optimale Leistung, obwohl es aufgrund seiner effizienten Architektur im Vergleich zu größeren Alternativen auch auf bescheidenerer Hardware effektiv ausgeführt werden kann. Für Produktionsbereitstellungen ist das Modell sowohl über AWS SageMaker als auch über Azure Marketplace verfügbar und bietet flexible Integrationsoptionen. Obwohl das Modell bei der Konvertierung von HTML in Markdown hervorragend ist, ist es wichtig zu beachten, dass es speziell für diese Aufgabe optimiert ist und möglicherweise nicht für die allgemeine Textgenerierung oder andere NLP-Aufgaben geeignet ist. Bei der Verarbeitung extrem langer Dokumente (annähernd 512.000 Token) sollten sich Benutzer darüber im Klaren sein, dass die Leistung nachlassen kann, da dies die Trainingsparameter des Modells überschreitet. Für optimale Ergebnisse implementieren Sie die bereitgestellten Wiederholungserkennungsmechanismen und erwägen Sie die Verwendung der kontrastiven Suche während der Inferenz, um die Ausgabequalität aufrechtzuerhalten.

Blogs, die dieses Modell erwähnen