jina-clip-v2 API ist unter dem Tab „Embeddings" verfügbar.

Multimodale Embeddings ermöglichen die Suche und das Verstehen von Daten über verschiedene Modalitäten hinweg durch eine kohärente Darstellung. Sie dienen als Rückgrat für Neural Information Retrieval und multimodale GenAI-Anwendungen. Heute freuen wir uns, jina-clip-v2 vorzustellen, neue universelle multilinguale multimodale Embeddings, die auf jina-clip-v1 und unserem kürzlich veröffentlichten jina-embeddings-3 aufbauen und mehrere wichtige Verbesserungen bieten:

- Verbesserte Leistung: v2 zeigt eine 3%ige Leistungsverbesserung gegenüber v1 sowohl bei Text-Bild- als auch bei Text-Text-Retrieval-Aufgaben. Ähnlich wie v1 kann der Textencoder von v2 als effektiver multilingualer Long-Context Dense Retriever dienen. Er arbeitet auf Augenhöhe mit unserem Spitzenmodell jina-embeddings-v3 (derzeit die besten multilingualen Embeddings unter 1B Parametern auf MTEB).

- Multilinguale Unterstützung: Mit jina-embeddings-v3 als Text-Tower unterstützt jina-clip-v2 89 Sprachen für multilinguale Bildsuche und zeigt bis zu 4% Verbesserung im Vergleich zu

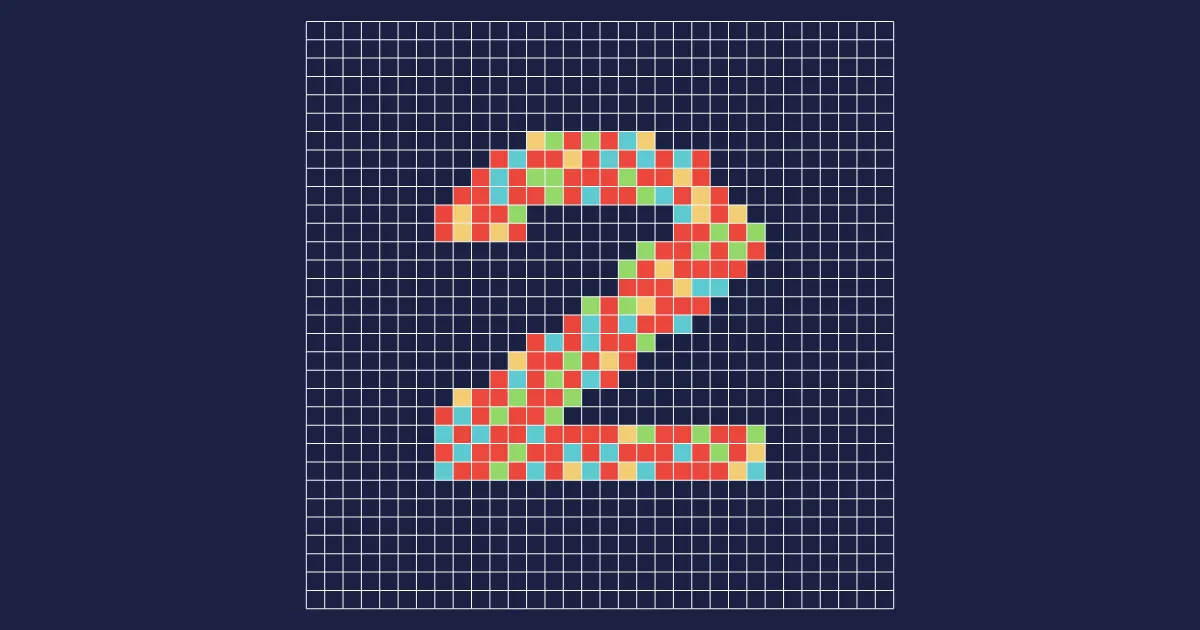

nllb-clip-large-siglipbei multilingualen Bildsuche-Aufgaben. - Höhere Bildauflösung: v2 unterstützt jetzt eine Eingabebildauflösung von 512x512, eine deutliche Steigerung gegenüber v1's 224x224. Diese höhere Auflösung ermöglicht eine bessere Verarbeitung detaillierter Bilder, verbesserte Merkmalsextraktion und genauere Erkennung feinkörniger visueller Elemente.

- Matryoshka-Darstellungen: v2 ermöglicht es Benutzern, die Ausgabedimensionen sowohl von Text- als auch von Bild-Embeddings von 1024 bis auf 64 zu reduzieren, wodurch Speicher- und Verarbeitungsaufwand reduziert werden, während die starke Leistung erhalten bleibt.

tagModellarchitektur

jina-clip-v2 ist ein 0,9B CLIP-Style-Modell, das zwei leistungsstarke Encoder kombiniert: den Text-Encoder Jina XLM-RoBERTa (das Rückgrat von jina-embeddings-v3) und den Vision-Encoder EVA02-L14 (ein effizienter Vision Transformer entwickelt von BAAI). Diese Encoder werden gemeinsam trainiert, um alignierte Darstellungen von Bildern und Text zu erstellen.

| Feature | Text Encoder | Image Encoder |

|---|---|---|

| Base Model | Jina XLM-RoBERTa | EVA02-L |

| Parameters | 561M | 304M |

| Input Specification | 8,192 tokens (max) | 512×512 pixels |

| Min Output Dimensions | 64 | 64 |

| Max Output Dimensions | 1,024 | 1,024 |

| Layers | 24 | 24 |

| Attention Mechanism | FlashAttention2 | xFormers |

| Pooling Strategy | Mean pooling | CLS pooling |

| Additional Features | 89 languages supported | Patch size 14x14 |

tagCross-Modal Retrieval Leistung

Jina CLIP v2 bietet multilinguale Unterstützung für 89 Sprachen und Spitzenleistung in wichtigen Sprachen wie Arabisch, Chinesisch, Englisch, Französisch, Deutsch, Japanisch, Russisch und Spanisch. In multilingualen Bildsuche-Benchmarks zeigt es eine Leistung, die NLLB-CLIP-SigLIP entspricht oder übertrifft, ein etwas größeres (1,3B, 44% größer als jina-clip-v2) State-of-the-Art CLIP-Style-Modell, das einen vortrainierten Text-Encoder aus NLLB-Modellen verwendet.

tagNur englische Texte und Bilder

Bei Standard-Cross-Modal-Retrieval-Benchmarks (Flickr30k und COCO) zeigt jina-clip-v2 durchweg starke Verbesserungen. Es erreicht State-of-the-Art-Leistung von 98,0% bei Flickr30k Bild-zu-Text-Retrieval und übertrifft damit sowohl seinen Vorgänger als auch NLLB-CLIP-SigLIP. Das Modell zeigt konsistente Verbesserungen in allen Retrieval-Szenarien, mit bemerkenswerten Steigerungen von bis zu 3,3% gegenüber v1 bei COCO Bild-zu-Text-Retrieval, während es über verschiedene Benchmarks und Modalitätsrichtungen hinweg eine wettbewerbsfähige Leistung mit NLLB-CLIP-SigLIP beibehält.

Flickr30k Recall@5 Leistung:

| Task | Model | Score | Relative to v1 | Relative to NLLB |

|---|---|---|---|---|

| Image-to-text | jina-clip-v2 | 98.0 | +1.7% | +0.9% |

| jina-clip-v1 | 96.4 | - | -0.7% | |

| nllb-siglip-large | 97.1 | - | - | |

| Text-to-image | jina-clip-v2 | 89.8 | +0.9% | -2.6% |

| jina-clip-v1 | 89.0 | - | -3.5% | |

| nllb-siglip-large | 92.2 | - | - |

COCO Recall@5 Leistung:

| Task | Model | Score | Relative to v1 | Relative to NLLB |

|---|---|---|---|---|

| Image-to-text | jina-clip-v2 | 81.5 | +3.3% | +2.9% |

| jina-clip-v1 | 78.9 | - | -0.4% | |

| nllb-siglip-large | 79.2 | - | - | |

| Text-to-image | jina-clip-v2 | 68.4 | +2.9% | -3.4% |

| jina-clip-v1 | 66.5 | - | -6.1% | |

| nllb-siglip-large | 70.8 | - | - |

tagMultilinguale Texte und Bilder

Bei multilingualen Cross-Modal-Benchmarks zeigt jina-clip-v2 robuste Leistung, insbesondere beim Bild-zu-Text-Retrieval, wo es NLLB-SigLIP über alle Datensätze hinweg übertrifft, mit bis zu +3,8% Verbesserung bei Crossmodal 3600. Während NLLB-SigLIP etwas stärkere Text-zu-Bild-Retrieval-Fähigkeiten zeigt, bleibt der Leistungsunterschied gering, typischerweise innerhalb von 3%.

Image2Text Recall@5 Performance:

| Benchmark | Model | Score | Relative to NLLB |

|---|---|---|---|

| Crossmodal 3600 | jina-clip-v2 | 83.23 | +3.8% |

| nllb-siglip-large | 80.16 | - | |

| Multilingual MS Coco | jina-clip-v2 | 86.03 | +0.8% |

| nllb-siglip-large | 85.37 | - | |

| XTD10 | jina-clip-v2 | 85.98 | +0.7% |

| nllb-siglip-large | 85.41 | - |

Text2Image Recall@5 Performance:

| Benchmark | Model | Score | Relative to NLLB |

|---|---|---|---|

| Crossmodal 3600 | jina-clip-v2 | 81.43 | -0.8% |

| nllb-siglip-large | 82.07 | - | |

| Multilingual MS Coco | jina-clip-v2 | 84.87 | -3.1% |

| nllb-siglip-large | 87.60 | - | |

| XTD10 | jina-clip-v2 | 85.03 | -3.0% |

| nllb-siglip-large | 87.63 | - |

tagLeistung des Text-Only Dense Retrievers

Ähnlich wie sein Vorgänger kann der Text-Encoder von jina-clip-v2 als effektiver mehrsprachiger Dense Retriever dienen. Bei den umfassenden Multilingual MTEB Benchmarks erzielt er starke Leistungen mit 69,86 % beim Retrieval und 67,77 % bei Aufgaben zur semantischen Ähnlichkeit. Diese Ergebnisse zeigen seine Vielseitigkeit und sind wettbewerbsfähig mit unserem spezialisierten Text-Embedding-Modell jina-embeddings-v3:

| Task | Model | Score | Relative to v3 |

|---|---|---|---|

| Retrieval | jina-clip-v2 | 69.86 | -3.8% |

| jina-embeddings-v3 | 72.59 | - | |

| Semantic Similarity | jina-clip-v2 | 67.77 | -2.9% |

| jina-embeddings-v3 | 69.81 | - |

Bei englischsprachigen Aufgaben zeigt jina-clip-v2 konstante Verbesserungen gegenüber sowohl seinem Vorgänger als auch NLLB-SigLIP, mit besonders starken Vorteilen bei der Retrieval-Leistung (fast das Doppelte des NLLB-SigLIP-Scores).

| Task | Model | Score | Relative to v1 |

|---|---|---|---|

| STS | jina-clip-v2 | 81.29 | +0.5% |

| jina-clip-v1 | 80.92 | - | |

| nllb-siglip-large | 74.65 | - | |

| Retrieval | jina-clip-v2 | 49.33 | +2.1% |

| jina-clip-v1 | 48.33 | - | |

| nllb-siglip-large | 24.92 | - |

tagLeistung der Matryoshka-Repräsentation

Sowohl Text- als auch Bild-Encoder unterstützen MRL, und ihre Ausgabedimensionen können auf 64 reduziert werden, während sie weiterhin starke Leistung zeigen. Unsere Evaluierung der Embedding-Kürzung zeigte bemerkenswerte Komprimierungspotenziale. Selbst eine aggressive Dimensionsreduktion um 75 % behielt über 99 % der Leistung bei Text-, Bild- und Cross-Modal-Aufgaben bei.

tagBildklassifizierung

Über 37 verschiedene Bildklassifizierungs-Benchmarks hinweg zeigt der Bild-Encoder eine starke Widerstandsfähigkeit gegenüber reduzierten Dimensionen. Eine Komprimierung von 1024 auf 64 Dimensionen (94 % Reduktion) führt nur zu einem Rückgang von 8 % bei der Top-5-Genauigkeit und 12,5 % bei Top-1, was sein Potenzial für einen effizienten Einsatz bei minimalem Leistungsverlust unterstreicht.

tagModalitätsübergreifendes Retrieval

Trotz einer drastischen Reduzierung um 94% auf nur 64 Dimensionen blieb das modalitätsübergreifende Retrieval unter Verwendung von gekürzten Bild- und Text-Embeddings bemerkenswert robust und bewahrte 93% der Bild-zu-Text- und 90% der Text-zu-Bild-Leistung.

tagReiner Text-Retrieval

Bei rein englischsprachigen MTEB-Benchmarks bewahrten 64-dimensionale Text-Embeddings (komprimiert von 1024) die semantische Ähnlichkeit bemerkenswert gut und zeigten nur einen Rückgang von 2,1%, während das Retrieval einen moderaten Rückgang von 17,5% verzeichnete.

tagErste Schritte

tagÜber die API

Der Code zeigt, wie man Embeddings mit Python's requests generiert. Übergeben Sie einen Text-String mit entweder einem base64-codierten Bild oder einer URL sowie Ihre gewünschte Dimensionsgröße (Standard 1024, hier 768 gezeigt).

import requests

import numpy as np

from numpy.linalg import norm

cos_sim = lambda a,b: (a @ b.T) / (norm(a)*norm(b))

url = 'https://api.jina.ai/v1/embeddings'

headers = {

'Content-Type': 'application/json',

'Authorization': 'Bearer <YOUR_JINA_AI_API_KEY>'

}

data = {

'input': [

{"text": "Bridge close-shot"},

{"url": "https://fastly.picsum.photos/id/84/1280/848.jpg?hmac=YFRYDI4UsfbeTzI8ZakNOR98wVU7a-9a2tGF542539s"}],

'model': 'jina-clip-v2',

'encoding_type': 'float',

'dimensions': '768'

}

response = requests.post(url, headers=headers, json=data)

sim = cos_sim(np.array(response.json()['data'][0]['embedding']), np.array(response.json()['data'][1]['embedding']))

print(f"Cosine text<->image: {sim}")Denken Sie daran, <YOUR_JINA_AI_API_KEY> durch einen aktivierten Jina API-Schlüssel zu ersetzen. Sie können hier einen kostenlosen API-Schlüssel mit einer Million kostenloser Token erhalten.

tagBild-Token-Preise

Unsere API zählt sowohl Text- als auch Bild-Token. Bei Bildern basiert der Token-Verbrauch auf der Anzahl der 512x512-Pixel-Kacheln, die benötigt werden, um die gesamte Bildfläche abzudecken. Jede Kachel kostet 4.000 Token für die Verarbeitung, einschließlich teilweise gefüllter Kacheln. Für optimale Kosteneffizienz empfehlen wir API-Nutzern, ihre Bilder vor dem Senden der Anfragen auf 512x512 zu skalieren.

| Bildauflösung | Benötigte Kacheln | Token-Kosten |

|---|---|---|

| 512x512 | 1 | 4.000 |

| 720x720 | 4 | 16.000 |

| 1080x1080 | 9 | 36.000 |

tagÜber CSP-Marktplätze

Jina CLIP v2 ist direkt auf AWS, Azure und GCP zu den dort aufgeführten Preisen verfügbar.

tagÜber VectorDB

tagFazit

Aufbauend auf unserer jina-clip-v1 Veröffentlichung im Juni, die das CLIP-Modell von OpenAI um Texteingaben von bis zu 8.192 Token erweiterte, und dem bahnbrechenden mehrsprachigen jina-embeddings-v3, bringt jina-clip-v2 drei wichtige Fortschritte: mehrsprachige Unterstützung für 89 Sprachen, erhöhte Bildauflösung von 512x512 und Matryoshka-Repräsentationslernen für genauere verkürzte Embeddings.

CLIP-ähnliche Modelle haben sich als Rückgrat für universelle multimodale Anwendungen etabliert. Mit jina-clip-v2 heben wir diese Fähigkeiten auf die nächste Stufe und bauen Sprachbarrieren ab, um ein genaueres modalitätsübergreifendes Verständnis und Abrufen zu ermöglichen. Wir glauben, dass diese Version ein Versprechen einlöst, multimodale Suche und Abruf sowohl leistungsfähiger als auch zugänglicher für Entwickler weltweit zu machen.