Disponible a través de

Gráfico de E/S 1

Gráfico de E/S 2

Gráfico de E/S 3

Elige modelos para comparar

Publicaciones (1)

Descripción general

ReaderLM-v2 es un modelo de lenguaje de parámetros 1.5B que convierte HTML sin formato en Markdown o JSON, manejando hasta 512K tokens de longitud de entrada/salida combinada con soporte para 29 idiomas. A diferencia de su predecesor que trataba la conversión de HTML a Markdown como una tarea de "copia selectiva", v2 lo aborda como un proceso de traducción, lo que permite un manejo superior de elementos complejos como cercas de código, listas anidadas, tablas y ecuaciones LaTeX. El modelo mantiene un rendimiento consistente en diferentes longitudes de contexto e introduce capacidades de generación directa de HTML a JSON con esquemas predefinidos.

Métodos

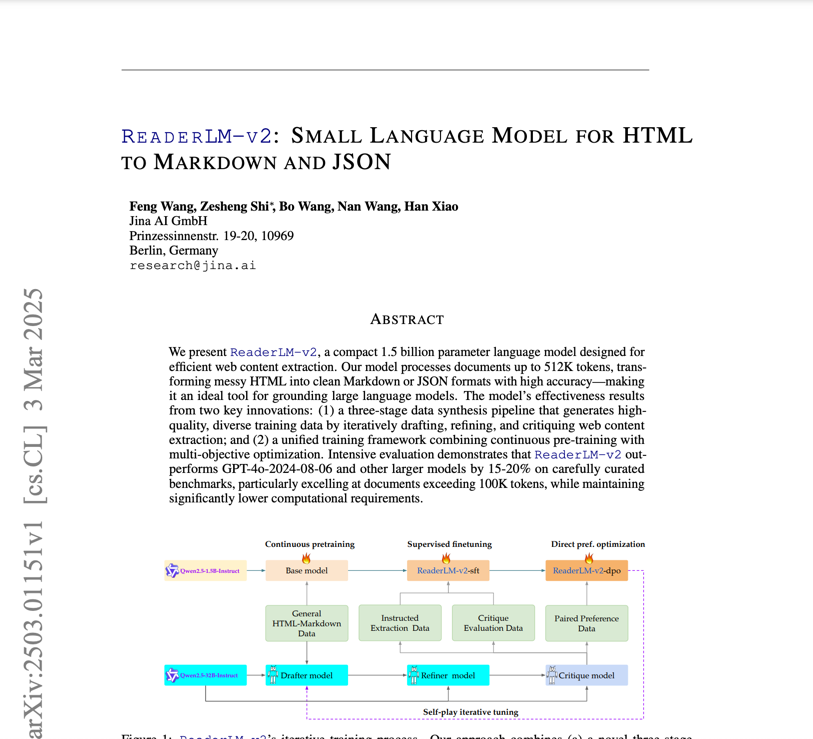

Desarrollado sobre la base de Qwen2.5-1.5B-Instruction, el entrenamiento de ReaderLM-v2 implicó un conjunto de datos html-markdown-1m de un millón de documentos HTML, con un promedio de 56.000 tokens cada uno. El proceso de entrenamiento incluyó: 1) preentrenamiento de contexto largo utilizando atención ring-zag y RoPE para expandir el contexto de 32 000 a 256 000 tokens, 2) ajuste fino supervisado con conjuntos de datos refinados, 3) optimización de preferencia directa para alineación de salida y 4) ajuste de refuerzo de reproducción automática. La preparación de los datos siguió un proceso de tres pasos (borrador, refinamiento y crítica) impulsado por Qwen2.5-32B-Instruction, con modelos especializados entrenados para tareas específicas antes de fusionarlos mediante interpolación de parámetros lineales.

Actuación

En pruebas comparativas exhaustivas, ReaderLM-v2 supera a modelos más grandes como Qwen2.5-32B-Instruct y Gemini2-flash-expr en tareas de conversión de HTML a Markdown. Para la extracción de contenido principal, logra un ROUGE-L de 0,84, un Jaro-Winkler de 0,82 y una distancia de Levenshtein significativamente menor (0,22) en comparación con los competidores. En tareas de conversión de HTML a JSON, mantiene un rendimiento competitivo con puntajes F1 de 0,81 y una tasa de aprobación del 98 %. El modelo procesa a 67 tokens/s de entrada y 36 tokens/s de salida en una GPU T4, con problemas de degeneración significativamente reducidos a través del entrenamiento de pérdida de contraste.

Guía

Se puede acceder al modelo a través de un notebook de Google Colab que muestra la conversión de HTML a Markdown, la extracción de JSON y el seguimiento de instrucciones. Para las tareas de HTML a Markdown, los usuarios pueden ingresar HTML sin instrucciones de prefijo, mientras que la extracción de JSON requiere un formato de esquema específico. La función auxiliar create_prompt facilita la creación de indicaciones para ambas tareas. Si bien el modelo funciona en el nivel de GPU T4 gratuito de Colab (que requiere vllm y triton), tiene limitaciones sin compatibilidad con bfloat16 o Flash Attention 2. Se recomienda RTX 3090/4090 para uso en producción. El modelo estará disponible en AWS SageMaker, Azure y GCP Marketplace, con licencia CC BY-NC 4.0 para uso no comercial.

Blogs que mencionan este modelo