Disponible a través de

Gráfico de E/S

Elige modelos para comparar

Publicaciones (3)

Descripción general

Jina Embeddings v3 es un innovador modelo de incrustación de texto multilingüe que transforma la forma en que las organizaciones manejan la comprensión y recuperación de texto en todos los idiomas. En esencia, resuelve el desafío crítico de mantener un alto rendimiento en varios idiomas y tareas, al mismo tiempo que mantiene los requisitos computacionales manejables. El modelo se destaca particularmente en entornos de producción donde la eficiencia es importante: logra un rendimiento de vanguardia con solo 570 millones de parámetros, lo que lo hace accesible para equipos que no pueden permitirse la sobrecarga computacional de modelos más grandes. Las organizaciones que necesitan crear sistemas de búsqueda escalables y multilingües o analizar contenido a través de barreras lingüísticas encontrarán este modelo especialmente valioso.

Métodos

La arquitectura del modelo representa una innovación significativa en la tecnología de incrustación, construida sobre una base de jina-XLM-RoBERTa con 24 capas y mejorada con adaptadores de adaptación de bajo rango (LoRA) específicos de la tarea. Los adaptadores LoRA son componentes de red neuronal especializados que optimizan el modelo para diferentes tareas como recuperación, clasificación o agrupamiento sin aumentar significativamente el recuento de parámetros: agregan menos del 3% a los parámetros totales. El modelo incorpora aprendizaje de representación Matryoshka (MRL), lo que permite reducir de manera flexible las incrustaciones de 1024 a tan solo 32 dimensiones, al tiempo que se preserva el rendimiento. El entrenamiento implicó un proceso de tres etapas: preentrenamiento inicial en texto multilingüe de 89 idiomas, ajuste fino en textos emparejados para la calidad de incrustación y entrenamiento especializado de adaptadores para la optimización de tareas. El modelo admite longitudes de contexto de hasta 8192 tokens a través de incrustaciones de posición rotatoria (RoPE), con una innovadora técnica de ajuste de frecuencia base que mejora el rendimiento tanto en textos cortos como largos.

Actuación

El modelo demuestra una relación eficiencia-rendimiento excepcional en pruebas del mundo real, superando tanto a las alternativas de código abierto como a las soluciones propietarias de OpenAI y Cohere en tareas en inglés, a la vez que se destaca en escenarios multilingües. Lo más sorprendente es que logra mejores resultados que e5-mistral-7b-instruct, que tiene 12 veces más parámetros, lo que resalta su notable eficiencia. En las evaluaciones de referencia de MTEB, logra una puntuación promedio de 65,52 en todas las tareas, con un desempeño particularmente sólido en Precisión de clasificación (82,58) y Similitud de oraciones (85,80). El modelo mantiene un rendimiento constante en todos los idiomas, con una puntuación de 64,44 en tareas multilingües. Al utilizar MRL para la reducción de dimensiones, mantiene un rendimiento sólido incluso en dimensiones más bajas; por ejemplo, mantiene el 92 % de su rendimiento de recuperación en 64 dimensiones en comparación con las 1024 dimensiones completas.

Guía

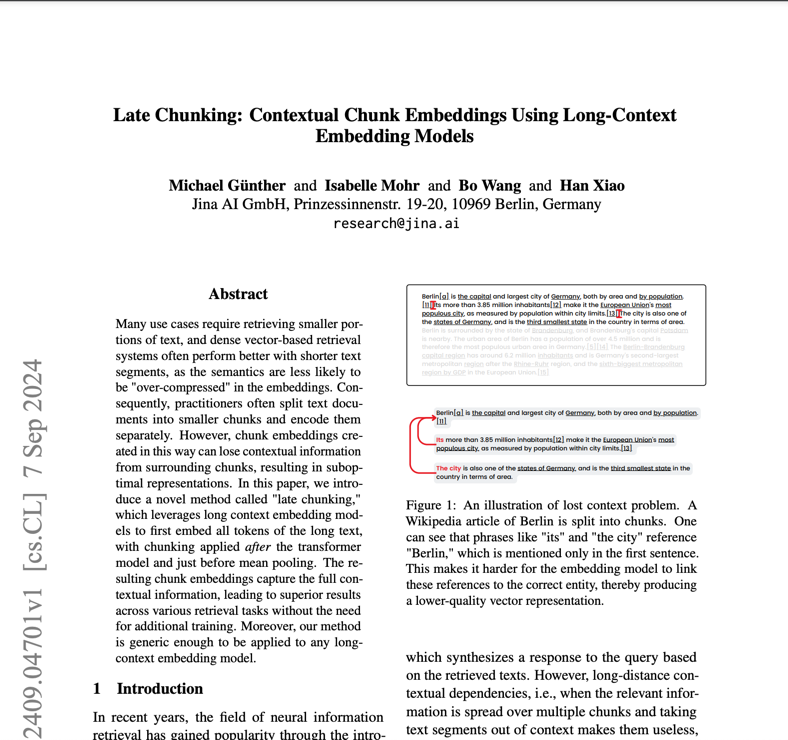

Para implementar Jina Embeddings v3 de manera eficaz, los equipos deben considerar su caso de uso específico para seleccionar el adaptador de tareas adecuado: retrieval.query y retrieval.passage para aplicaciones de búsqueda, separación para tareas de agrupamiento, clasificación para categorización y coincidencia de texto para similitud semántica. El modelo requiere hardware compatible con CUDA para un rendimiento óptimo, aunque su arquitectura eficiente significa que necesita significativamente menos memoria de GPU que las alternativas más grandes. Para la implementación de producción, la integración de AWS SageMaker proporciona una ruta optimizada hacia la escalabilidad. El modelo se destaca en aplicaciones multilingües, pero puede requerir una evaluación adicional para idiomas con bajos recursos. Si bien admite documentos largos de hasta 8192 tokens, se logra un rendimiento óptimo con la función de fragmentación tardía para textos muy largos. Los equipos deben evitar usar el modelo para tareas que requieran generación en tiempo real o razonamiento complejo: está diseñado para la incrustación y la recuperación, no para la generación de texto o la respuesta directa a preguntas.

Blogs que mencionan este modelo