Choisissez les modèles à comparer

Aperçu

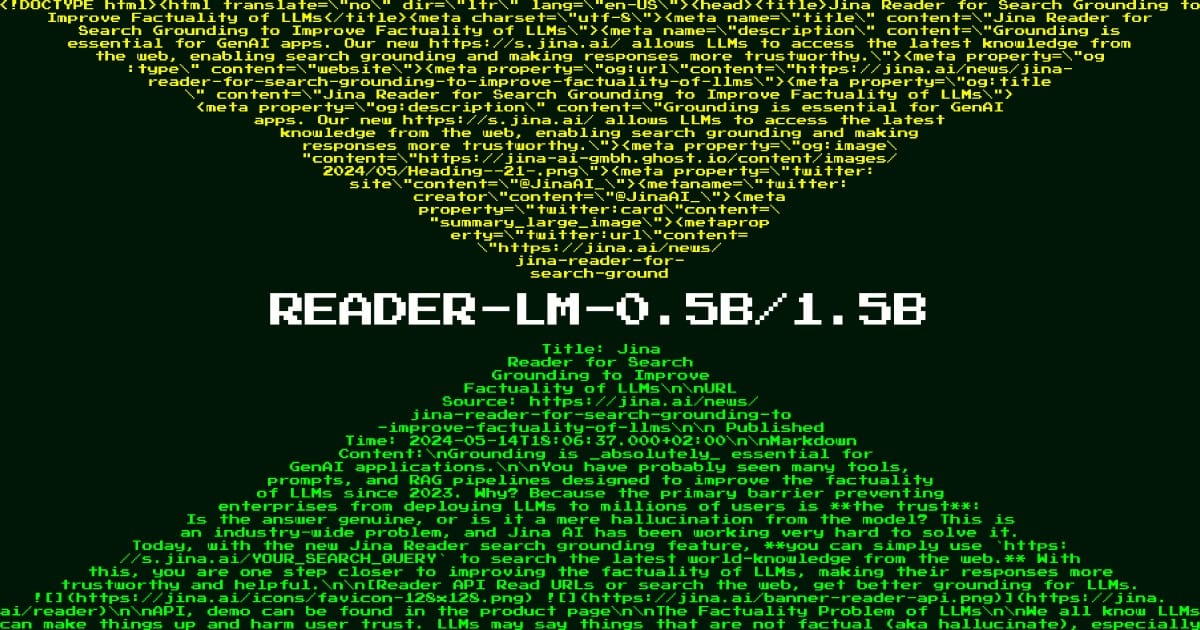

Reader LM 0.5B est un modèle de langage spécialisé conçu pour résoudre le défi complexe de la conversion de documents HTML en texte Markdown propre et structuré. Ce modèle répond à un besoin essentiel des pipelines de traitement de données modernes : transformer efficacement un contenu Web désordonné en un format idéal pour les LLM et les systèmes de documentation. Contrairement aux modèles de langage à usage général qui nécessitent des ressources de calcul massives, Reader LM 0.5B permet un traitement HTML de qualité professionnelle avec seulement 494 millions de paramètres, ce qui le rend accessible aux équipes disposant de ressources informatiques limitées. Les organisations qui traitent du contenu Web, de l'automatisation de la documentation ou de la création d'applications basées sur LLM trouveront ce modèle particulièrement utile pour rationaliser leurs flux de travail de préparation de contenu.

Méthodes

Le modèle utilise une architecture innovante « superficielle mais large » spécialement optimisée pour les opérations de copie sélective plutôt que pour la génération de texte créatif. Construit sur une base de décodeur uniquement avec 24 couches et 896 dimensions cachées, le modèle utilise des mécanismes d'attention spécialisés avec 14 têtes de requête et 2 têtes de valeur-clé pour traiter efficacement les séquences d'entrée. Le processus de formation comportait deux étapes distinctes : d'abord avec du HTML plus court et plus simple (32 000 jetons) pour apprendre les modèles de conversion de base, puis avec du HTML complexe et réel (128 000 jetons) pour gérer les cas difficiles. Le modèle intègre la recherche contrastive pendant la formation et implémente un mécanisme de détection de répétition pour éviter les problèmes de dégénérescence tels que les boucles de jetons. Un aspect unique de son architecture est le mécanisme d'attention en anneau en zigzag, qui permet au modèle de gérer des séquences extrêmement longues jusqu'à 256 000 jetons tout en maintenant des performances stables.

Performance

Lors de tests en conditions réelles, Reader LM 0.5B affiche des ratios efficacité/performance impressionnants sur plusieurs indicateurs. Le modèle atteint un score ROUGE-L de 0,56, indiquant une forte préservation du contenu, et maintient un faible taux d'erreur de jeton de 0,34, montrant une hallucination minimale. Dans les évaluations qualitatives sur 22 sources HTML diverses, notamment des articles de presse, des billets de blog et des pages de commerce électronique en plusieurs langues, il montre une force particulière dans la préservation de la structure et l'utilisation de la syntaxe Markdown. Le modèle excelle dans la gestion de pages Web modernes complexes où les scripts et les CSS en ligne peuvent s'étendre à des centaines de milliers de jetons - un scénario où les approches traditionnelles basées sur des règles échouent souvent. Cependant, il est important de noter que même si le modèle fonctionne exceptionnellement bien sur les tâches simples de conversion HTML en Markdown, il peut nécessiter un traitement supplémentaire pour les pages très dynamiques ou très chargées en JavaScript.

Conseils

Pour déployer efficacement Reader LM 0.5B, les organisations doivent s'assurer que leur infrastructure peut gérer les exigences CUDA du modèle, bien que son architecture efficace signifie qu'il peut s'exécuter sur des GPU grand public. Le modèle fonctionne mieux avec une entrée HTML brute et ne nécessite pas de préfixes ou d'instructions spéciaux. Pour des performances optimales, implémentez le mécanisme de détection de répétition fourni pour éviter les boucles de jetons potentielles dans la génération de sortie. Bien que le modèle prenne en charge plusieurs langues et diverses structures HTML, il est spécifiquement conçu pour l'extraction de contenu et la conversion de démarques. Il ne doit pas être utilisé pour des tâches telles que la génération de texte, la synthèse ou la réponse directe à des questions. Le modèle est disponible via AWS SageMaker pour le déploiement en production, et un bloc-notes Google Colab est fourni pour les tests et l'expérimentation. Les équipes doivent savoir que même si le modèle peut gérer des documents extrêmement longs jusqu'à 256 000 jetons, le traitement d'entrées aussi volumineuses peut nécessiter des stratégies de gestion de la mémoire supplémentaires.

Blogs qui mentionnent ce modèle