Disponibile tramite

Grafico I/O 1

Grafico I/O 2

Grafico I/O 3

Scegli i modelli da confrontare

Pubblicazioni (1)

Panoramica

ReaderLM-v2 è un modello di linguaggio con parametri da 1,5 miliardi che converte HTML grezzo in markdown o JSON, gestendo fino a 512K token di lunghezza input/output combinata con supporto per 29 lingue. A differenza del suo predecessore che trattava HTML-to-markdown come un'attività di "copia selettiva", v2 lo affronta come un processo di traduzione, consentendo una gestione superiore di elementi complessi come code fence, elenchi nidificati, tabelle ed equazioni LaTeX. Il modello mantiene prestazioni costanti su diverse lunghezze di contesto e introduce capacità di generazione diretta HTML-to-JSON con schemi predefiniti.

Metodi

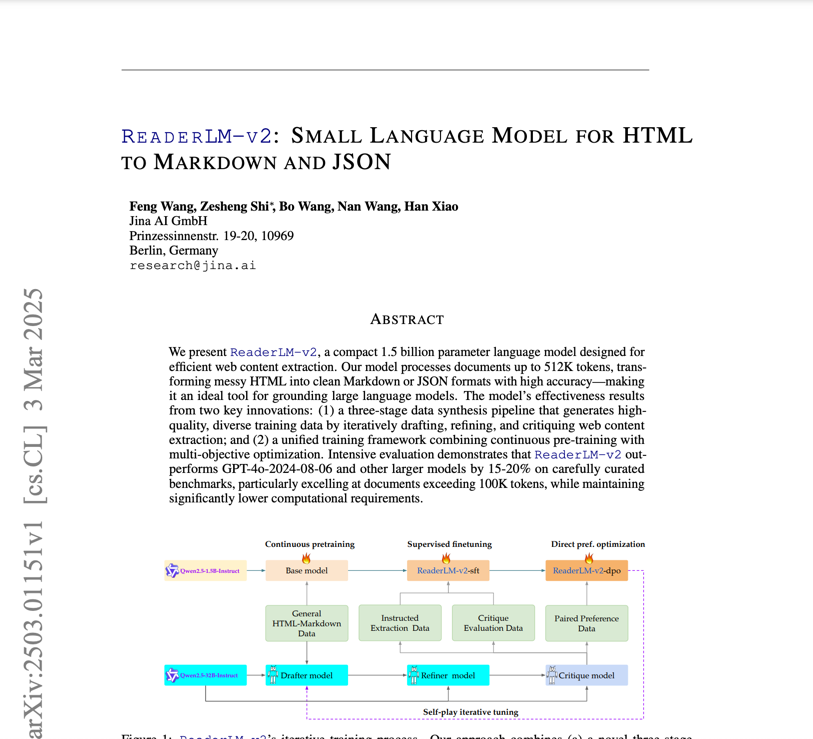

Basato su Qwen2.5-1.5B-Instruction, l'addestramento di ReaderLM-v2 ha coinvolto un dataset html-markdown-1m di dieci milioni di documenti HTML, con una media di 56.000 token ciascuno. Il processo di addestramento includeva: 1) pre-addestramento a lungo contesto utilizzando l'attenzione ring-zag e RoPE per espandere il contesto da 32.000 a 256.000 token, 2) ottimizzazione supervisionata con dataset raffinati, 3) ottimizzazione diretta delle preferenze per l'allineamento dell'output e 4) ottimizzazione del rinforzo auto-riproduzione. La preparazione dei dati ha seguito una pipeline in tre fasi (Bozza-Affinamento-Critica) basata su Qwen2.5-32B-Instruction, con modelli specializzati addestrati per attività specifiche prima della fusione tramite interpolazione lineare dei parametri.

Prestazione

Nei benchmark completi, ReaderLM-v2 supera modelli più grandi come Qwen2.5-32B-Instruct e Gemini2-flash-expr su attività HTML-to-Markdown. Per l'estrazione del contenuto principale, ottiene ROUGE-L di 0,84, Jaro-Winkler di 0,82 e una distanza di Levenshtein significativamente inferiore (0,22) rispetto ai concorrenti. Nelle attività HTML-to-JSON, mantiene prestazioni competitive con punteggi F1 di 0,81 e un tasso di superamento del 98%. Il modello elabora a 67 token/s in input e 36 token/s in output su una GPU T4, con problemi di degenerazione significativamente ridotti tramite training di perdita contrastiva.

Orientamento

Il modello è accessibile tramite un notebook Google Colab che dimostra la conversione da HTML a markdown, l'estrazione JSON e il rispetto delle istruzioni. Per le attività da HTML a Markdown, gli utenti possono immettere HTML grezzo senza istruzioni di prefisso, mentre l'estrazione JSON richiede una formattazione di schema specifica. La funzione helper create_prompt facilita la creazione di prompt per entrambe le attività. Mentre il modello funziona sul livello GPU T4 gratuito di Colab (che richiede vllm e triton), presenta delle limitazioni senza il supporto bfloat16 o flash attention 2. RTX 3090/4090 è consigliato per l'uso in produzione. Il modello sarà disponibile su AWS SageMaker, Azure e GCP marketplace, con licenza CC BY-NC 4.0 per uso non commerciale.

Blog che menzionano questo modello