Disponibile tramite

Grafico I/O

Scegli i modelli da confrontare

Pubblicazioni (3)

Panoramica

Jina Embeddings v3 è un modello di incorporamento di testo multilingue rivoluzionario che trasforma il modo in cui le organizzazioni gestiscono la comprensione e il recupero del testo tra le lingue. In sostanza, risolve la sfida critica di mantenere prestazioni elevate su più lingue e attività, mantenendo al contempo i requisiti computazionali gestibili. Il modello brilla in modo particolare negli ambienti di produzione in cui l'efficienza è importante: raggiunge prestazioni all'avanguardia con soli 570 milioni di parametri, rendendolo accessibile ai team che non possono permettersi il sovraccarico computazionale di modelli più grandi. Le organizzazioni che hanno bisogno di creare sistemi di ricerca multilingue scalabili o di analizzare contenuti oltre le barriere linguistiche troveranno questo modello particolarmente prezioso.

Metodi

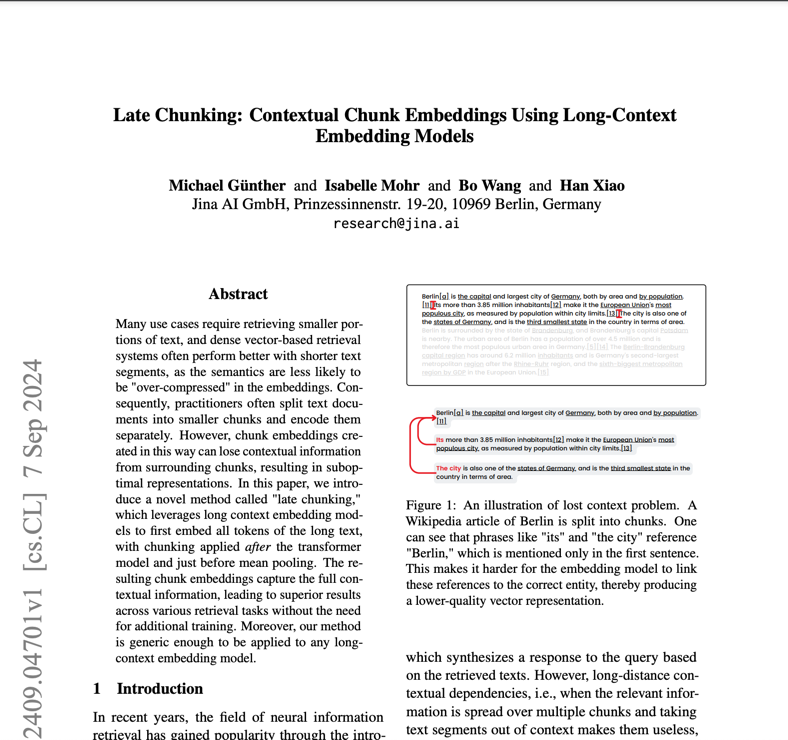

L'architettura del modello rappresenta un'innovazione significativa nella tecnologia di incorporamento, costruita su una base di jina-XLM-RoBERTa con 24 livelli e potenziata con adattatori Low-Rank Adaptation (LoRA) specifici per attività. Gli adattatori LoRA sono componenti di rete neurale specializzati che ottimizzano il modello per diverse attività come recupero, classificazione o clustering senza aumentare significativamente il conteggio dei parametri: aggiungono meno del 3% ai parametri totali. Il modello incorpora Matryoshka Representation Learning (MRL), consentendo di ridurre in modo flessibile gli incorporamenti da 1024 a un minimo di 32 dimensioni, preservando al contempo le prestazioni. L'addestramento ha coinvolto un processo in tre fasi: pre-addestramento iniziale su testo multilingue da 89 lingue, messa a punto su testi accoppiati per la qualità dell'incorporamento e addestramento dell'adattatore specializzato per l'ottimizzazione delle attività. Il modello supporta lunghezze di contesto fino a 8.192 token tramite Rotary Position Embeddings (RoPE), con un'innovativa tecnica di regolazione della frequenza di base che migliora le prestazioni su testi sia brevi che lunghi.

Prestazione

Il modello dimostra un eccezionale rapporto efficienza-prestazioni nei test del mondo reale, superando sia le alternative open source che le soluzioni proprietarie di OpenAI e Cohere nelle attività in inglese, eccellendo negli scenari multilingue. La cosa più sorprendente è che ottiene risultati migliori di e5-mistral-7b-instruct, che ha 12 volte più parametri, evidenziando la sua notevole efficienza. Nelle valutazioni di benchmark MTEB, ottiene un punteggio medio di 65,52 in tutte le attività, con prestazioni particolarmente elevate in Accuratezza della classificazione (82,58) e Somiglianza delle frasi (85,80). Il modello mantiene prestazioni costanti in tutte le lingue, ottenendo un punteggio di 64,44 nelle attività multilingue. Quando si utilizza MRL per la riduzione delle dimensioni, mantiene prestazioni elevate anche a dimensioni inferiori, ad esempio, mantenendo il 92% delle sue prestazioni di recupero a 64 dimensioni rispetto alle 1024 dimensioni complete.

Orientamento

Per distribuire in modo efficace Jina Embeddings v3, i team devono considerare il loro caso d'uso specifico per selezionare l'adattatore di attività appropriato: retrieval.query e retrieval.passage per le applicazioni di ricerca, separazione per le attività di clustering, classificazione per la categorizzazione e corrispondenza di testo per la similarità semantica. Il modello richiede hardware compatibile con CUDA per prestazioni ottimali, sebbene la sua architettura efficiente implichi che necessiti di una memoria GPU notevolmente inferiore rispetto ad alternative più grandi. Per la distribuzione in produzione, l'integrazione di AWS SageMaker fornisce un percorso semplificato verso la scalabilità. Il modello eccelle nelle applicazioni multilingue ma potrebbe richiedere una valutazione aggiuntiva per le lingue a basse risorse. Sebbene supporti documenti lunghi fino a 8.192 token, le prestazioni ottimali si ottengono con la funzionalità di chunking tardivo per testi molto lunghi. I team devono evitare di utilizzare il modello per attività che richiedono generazione in tempo reale o ragionamento complesso: è progettato per l'incorporamento e il recupero, non per la generazione di testo o la risposta diretta alle domande.

Blog che menzionano questo modello