I/O 図 1

I/O 図 2

I/O 図 3

比較するモデルを選択してください

出版物 (1)

概要

ReaderLM-v2 は、生の HTML をマークダウンまたは JSON に変換し、最大 512K のトークンの組み合わせの入出力長を処理し、29 の言語をサポートする 1.5B パラメーターの言語モデルです。 HTML からマークダウンまでを「選択コピー」タスクとして扱っていた前バージョンとは異なり、v2 はこれを翻訳プロセスとして扱い、コード フェンス、ネストされたリスト、テーブル、LaTeX 方程式などの複雑な要素の処理に優れています。このモデルは、さまざまなコンテキスト長にわたって一貫したパフォーマンスを維持し、事前定義されたスキーマを使用した HTML から JSON への直接生成を導入します。

方法

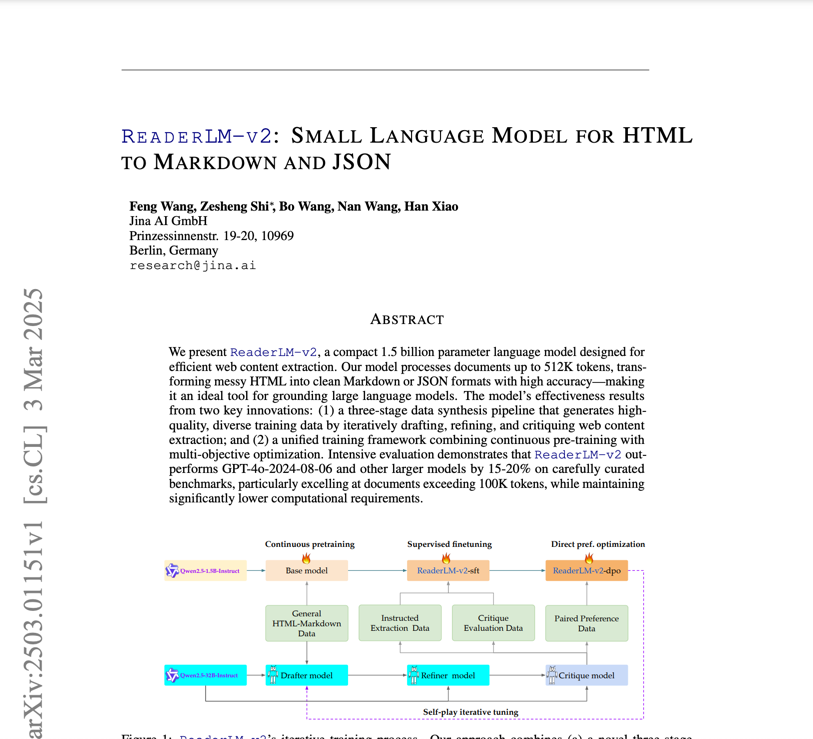

ReaderLM-v2 は Qwen2.5-1.5B-Instruction に基づいて構築され、平均 56,000 トークンを含む 1,000 万の HTML ドキュメントを含む html-markdown-1m データセットでトレーニングされています。トレーニング プロセスには、1) コンテキストを 32,000 トークンから 256,000 トークンに拡張するための、Ring-zag Attention と RoPE を使用した長期コンテキストの事前トレーニングが含まれます。 2) 洗練されたデータセットを使用した教師あり微調整3)出力アライメントのための直接的な設定最適化。 4)自己プレー強化調整。データ準備は、Qwen2.5-32B-Instruction によって実行される 3 段階のプロセス (ドラフト、リファイン、レビュー) に従います。このプロセスでは、特定のタスク用に特殊なモデルがトレーニングされ、線形パラメータ補間によってマージされます。

パフォーマンス

合成ベンチマークでは、ReaderLM-v2 は、HTML から Markdown へのタスクにおいて、Qwen2.5-32B-Instruct や Gemini2-flash-expr などの大規模モデルよりも優れたパフォーマンスを発揮します。一次コンテンツ抽出では、競合他社と比較して、ROUGE-L 0.84、Jaro-Winkler 0.82、および大幅に低いレーベンシュタイン距離 (0.22) を達成しています。 HTML から JSON へのタスクでは、F1 スコア 0.81、合格率 98% という競争力のあるパフォーマンスを維持しています。このモデルは、T4 GPU 上で 67 トークン/秒の入力と 36 トークン/秒の出力で処理し、コントラスト損失トレーニングを通じて劣化の問題を大幅に軽減します。

ガイド

このモデルには、HTML から Markdown への変換、JSON 抽出、および命令のフォローを示す Google Colab ノートブック経由でアクセスできます。 HTML からマークダウンへのタスクの場合、ユーザーはプレフィックス ディレクティブなしで生の HTML を入力できますが、JSON 抽出には特定のスキーマ形式が必要です。 create_prompt ヘルパー関数を使用すると、両方のタスクのプロンプトを簡単に作成できます。モデルは Colab の無料 T4 GPU 層 (vllm および triton が必要) で実行できますが、bfloat16 またはフラッシュ アテンション 2 がサポートされていないため制限があります。本番環境での使用には RTX 3090/4090 が推奨されます。このモデルは、AWS SageMaker、Azure、および GCP マーケットプレイスで入手可能になり、CC BY-NC 4.0 ライセンスに基づいて非営利使用がライセンスされます。

このモデルについて言及しているブログ