I/O 図

比較するモデルを選択してください

出版物 (3)

概要

Jina Embeddings v3 は、組織が言語を超えたテキストの理解と取得に取り組む方法を変える、画期的な多言語テキスト ベクトル モデルです。基本的に、計算要件を制御しながら、複数の言語およびタスクにわたって高いパフォーマンスを維持するという重要な課題を解決します。このモデルは、効率が重要な実稼働環境で特に優れています。わずか 5 億 7,000 万のパラメータで最先端のパフォーマンスを実現し、大規模なモデルの計算オーバーヘッドに余裕がないチームでも利用できるようになります。スケーラブルな多言語検索システムを構築したり、言語の壁を越えてコンテンツを分析したりする必要がある組織は、このモデルが特に価値があると考えられます。

方法

このモデルのアーキテクチャは、ベクトル テクノロジーにおける主要な革新を表しており、24 層の jina-XLM-RoBERTa に基づいて構築され、タスク固有の低ランク アダプティブ (LoRA) アダプターで強化されています。 LoRA アダプターは、パラメーターの数を大幅に増やすことなく、検索、分類、クラスタリングなどのさまざまなタスクに合わせてモデルを最適化する特殊なニューラル ネットワーク コンポーネントです。合計パラメーターの増加は 3% 未満です。このモデルには Matryoshka Representation Learning (MRL) が組み込まれており、パフォーマンスを維持しながらベクトルを 1024 次元から 32 次元に柔軟に削減できます。トレーニングには 3 つの段階が含まれます。89 言語の多言語テキストに関する最初の事前トレーニング、ベクトル品質を向上させるためのペアのテキストの微調整、タスクに合わせて最適化するための特殊なアダプター トレーニングです。このモデルは、回転位置ベクトル (RoPE) を介して最大 8,192 トークンのコンテキスト長をサポートし、革新的な基本周波数調整技術を使用して、短いテキストと長いテキストの両方のパフォーマンスを向上させます。

パフォーマンス

このモデルは、実世界のテストで優れた効率対パフォーマンス比を実証し、英語タスクではオープンソースの代替案や OpenAI や Cohere の独自ソリューションを上回っていると同時に、多言語シナリオでも良好なパフォーマンスを示しています。最も驚くべきことに、12 倍のパラメータを使用する e5-mistral-7b-instruct よりも優れた結果が得られ、その優れた効率性が強調されます。 MTEB ベンチマーク評価では、すべてのタスクで平均スコア 65.52 を達成し、特に分類精度 (82.58) と文の類似性 (85.80) で優れたパフォーマンスを示しました。このモデルは言語間で一貫したパフォーマンスを維持し、多言語タスクで 64.44 のスコアを獲得しました。次元削減に MRL を使用すると、より低い次元でも強力なパフォーマンスが維持されます。たとえば、64 次元では、完全な 1024 次元と比較して 92% の検索パフォーマンスが維持されます。

ガイド

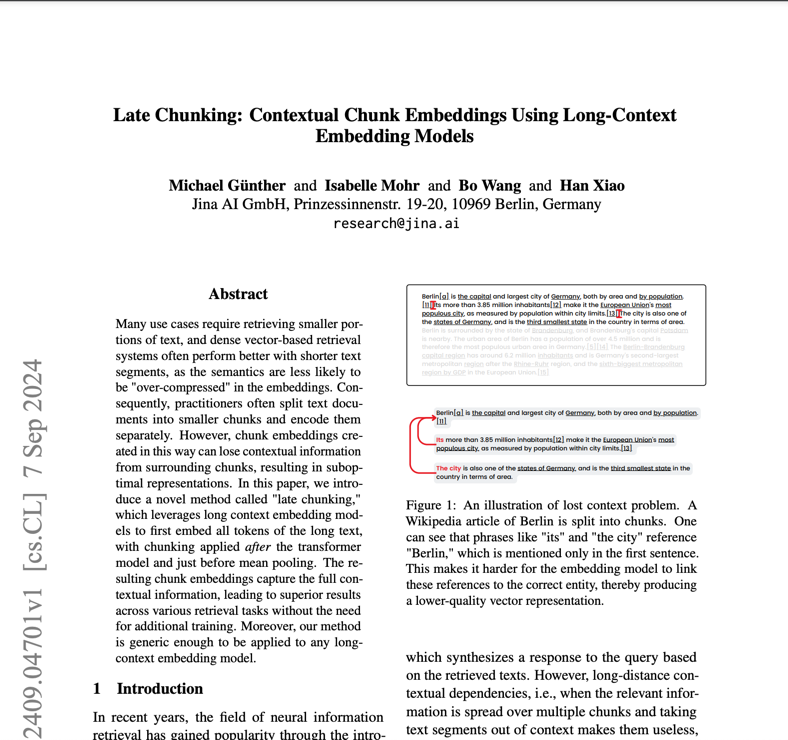

Jina Embeddings v3 を効果的に導入するには、チームは特定のユースケースを考慮して適切なタスクアダプタを選択する必要があります。検索アプリケーションでは retrieval.query と retrieval.passage を、クラスタリングタスクでは Separation を、分類では classification を、セマンティック類似性では textmatching を使用します。このモデルでは、最高のパフォーマンスを得るために CUDA 対応ハードウェアが必要ですが、効率的なアーキテクチャのため、大規模な代替手段に比べて GPU メモリの必要量が大幅に少なくて済みます。本番環境での導入では、AWS SageMaker との統合により、スケーラビリティへのシンプルなパスが提供されます。このモデルは多言語アプリケーションで良好なパフォーマンスを発揮しますが、リソースの少ない言語では追加の評価が必要になる場合があります。最大 8,192 トークンの長いドキュメントをサポートしていますが、非常に長いテキストには遅延セグメンテーション機能を使用すると最高のパフォーマンスが得られます。このモデルはベクトル化と検索用に設計されており、テキスト生成や直接的な質問への回答には使用しないでください。

このモデルについて言及しているブログ