以下の方法で入手できます

比較するモデルを選択してください

概要

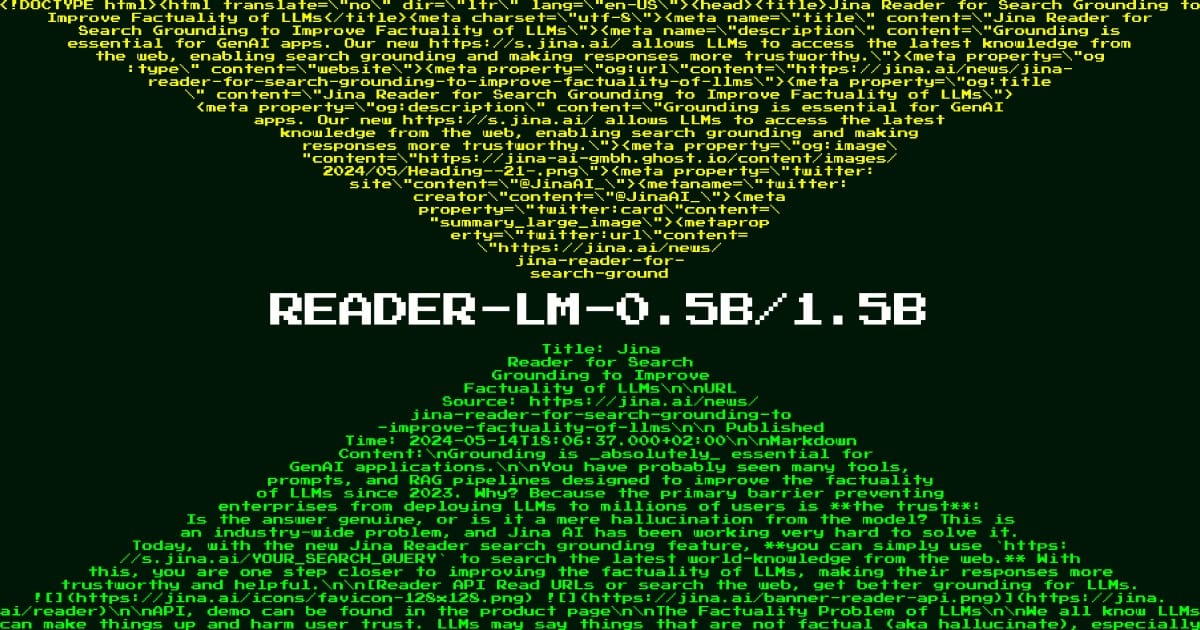

Reader LM 0.5B は、HTML ドキュメントをクリーンかつ構造化された Markdown テキストに変換するという複雑な課題に対処するために設計された特殊な言語モデルです。このモデルは、乱雑な Web コンテンツを大規模なモデルやドキュメント システムに適した形式に効率的に変換するという、最新のデータ処理パイプラインの主要なニーズを満たします。膨大なコンピューティング リソースを必要とする汎用言語モデルとは異なり、Reader LM 0.5B は、わずか 4 億 9,400 万個のパラメータを使用してプロフェッショナル レベルの HTML 処理を実現するため、コンピューティング リソースが限られているチームでも利用できます。 Web コンテンツの処理、ドキュメントの自動化、または大規模なモデルベースのアプリケーションの構築を扱う組織にとって、このモデルはコンテンツ準備ワークフローの合理化に特に役立ちます。

方法

このモデルは、クリエイティブなテキスト生成ではなく、選択的なコピー操作向けに特に最適化された革新的な「浅くて広い」アーキテクチャを使用しています。このモデルは、入力シーケンスを効率的に処理するために 14 のクエリ ヘッダーと 2 つのキー/値ヘッダーを備えた特殊なアテンション メカニズムを使用して、24 レイヤーと 896 の隠れ次元を備えたデコーダーのみのベースで構築されています。トレーニング プロセスには 2 つの異なる段階が含まれます。まず、短くて単純な HTML (32,000 トークン) を使用して基本的な変換パターンを学習し、次に複雑な現実世界の HTML (128,000 トークン) を使用して困難な状況に対処します。このモデルにはトレーニング中に対照的な検索が組み込まれており、トークン ループなどの機能低下の問題を防ぐために重複検出メカニズムが実装されています。そのアーキテクチャのユニークな点は、鋸歯状リング アテンション メカニズムであり、これによりモデルは安定したパフォーマンスを維持しながら、最大 256,000 トークンの非常に長いシーケンスを処理できます。

パフォーマンス

実際のテストでは、Reader LM 0.5B は複数の指標にわたって優れた効率対パフォーマンス比を実証しました。このモデルは、ROUGE-L スコア 0.56 を達成し、コンテンツが良好に保存されていることを示し、トークン エラー率 0.34 を維持し、最小限のアーティファクトを示しました。多言語のニュース記事、ブログ投稿、電子商取引ページを含む 22 の異なる HTML ソースの定性的評価において、構造の保持とマークダウン構文の使用に関して良好なパフォーマンスを示しました。このモデルは、インライン CSS とスクリプトが数十万のトークンに拡張できる、複雑な最新の Web ページの処理に優れています。従来のルールベースのアプローチでは失敗することがよくあります。ただし、このモデルは単純な HTML からマークダウンへの変換タスクでは非常にうまく機能しますが、非常に動的なページや JavaScript を多用するページでは追加の処理が必要になる場合があることに注意することが重要です。

ガイド

Reader LM 0.5B を効果的に展開するには、組織はインフラストラクチャがモデルの CUDA 要件を満たしていることを確認する必要がありますが、その効率的なアーキテクチャによりコンシューマ グレードの GPU で実行できます。このモデルは、生の HTML 入力で最もよく機能し、特別なプレフィックスやディレクティブを必要としません。最高のパフォーマンスを得るには、提供された重複検出メカニズムを実装して、出力生成における潜在的なトークン サイクルを防ぎます。このモデルは複数の言語とさまざまな HTML 構造をサポートしていますが、コンテンツの抽出とマークダウン変換用に設計されています。テキストの生成、要約、直接的な質疑応答などのタスクには使用しないでください。このモデルは、AWS SageMaker を使用して本番環境にデプロイする準備ができており、テストと実験用に Google Colab ノートブックが提供されています。チームは、このモデルは最大 256K トークンの非常に長いドキュメントを処理できますが、そのような大きな入力を処理するには追加のメモリ管理戦略が必要になる可能性があることに注意する必要があります。

このモデルについて言及しているブログ