다음과 같은 방법으로 얻을 수 있습니다

비교할 모델을 선택하세요

개요

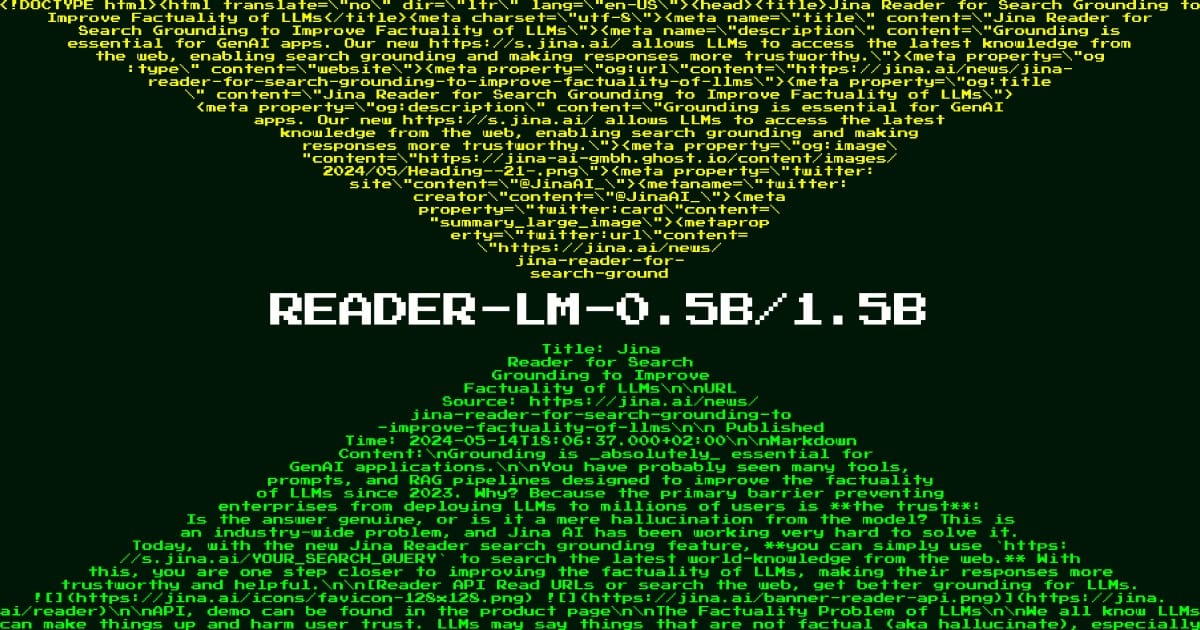

Reader LM 0.5B는 HTML 문서를 깔끔하고 구조화된 마크다운 텍스트로 변환하는 복잡한 과제를 해결하도록 설계된 특수 언어 모델입니다. 이 모델은 최신 데이터 처리 파이프라인의 핵심 요구 사항, 즉 복잡한 웹 콘텐츠를 대규모 모델과 문서화 시스템에 적합한 형식으로 효율적으로 변환하는 것을 충족합니다. 막대한 컴퓨팅 리소스를 필요로 하는 일반 언어 모델과 달리, Reader LM 0.5B는 4억 9,400만 개의 매개변수만 사용하여 전문가 수준의 HTML 처리를 달성하므로 컴퓨팅 리소스가 제한된 팀에서도 사용할 수 있습니다. 웹 콘텐츠 처리, 문서 자동화 또는 대규모 모델 기반 애플리케이션 구축을 다루는 조직에서는 이 모델이 콘텐츠 준비 워크플로를 간소화하는 데 특히 유용하다는 것을 알게 될 것입니다.

방법

이 모델은 창의적인 텍스트 생성보다는 선택적 복사 작업에 특별히 최적화된 혁신적인 "얕고 넓은" 아키텍처를 사용합니다. 이 모델은 입력 시퀀스를 효율적으로 처리하기 위해 14개의 쿼리 헤더와 2개의 키-값 헤더가 있는 특수 주의 메커니즘을 사용하여 24개의 레이어와 896개의 숨겨진 차원을 갖춘 디코더 전용 기반으로 구축되었습니다. 교육 프로세스에는 두 가지 별개의 단계가 포함됩니다. 먼저 더 짧고 간단한 HTML(32K 토큰)을 사용하여 기본 변환 패턴을 학습한 다음, 복잡한 실제 HTML(128K 토큰)을 사용하여 어려운 상황을 처리합니다. 이 모델은 훈련 중에 대조 검색을 통합하고 중복 감지 메커니즘을 구현하여 토큰 루프와 같은 성능 저하 문제를 방지합니다. 아키텍처의 독특한 측면은 톱니형 링 주의 메커니즘으로, 이를 통해 모델은 안정적인 성능을 유지하면서 최대 256K 토큰의 매우 긴 시퀀스를 처리할 수 있습니다.

성능

실제 테스트에서 Reader LM 0.5B는 여러 지표에 걸쳐 인상적인 효율성 대 성능 비율을 보여주었습니다. 모델은 콘텐츠 보존이 양호함을 나타내는 ROUGE-L 점수 0.56을 달성했으며, 아티팩트가 최소화된 0.34의 낮은 토큰 오류율을 유지했습니다. 뉴스 기사, 블로그 게시물, 다국어 전자상거래 페이지 등 22개 HTML 소스에 대한 정성적 평가에서 구조 보존 및 마크다운 구문 사용 측면에서 좋은 성능을 보였습니다. 이 모델은 인라인 CSS와 스크립트가 수십만 개의 토큰으로 확장될 수 있는 복잡한 최신 웹 페이지를 처리하는 데 탁월합니다. 여기서 기존 규칙 기반 접근 방식은 종종 실패합니다. 그러나 이 모델은 간단한 HTML에서 마크다운으로의 변환 작업에서는 매우 잘 수행되지만 매우 동적인 페이지나 JavaScript 집약적인 페이지에서는 추가 처리가 필요할 수 있다는 점에 유의하는 것이 중요합니다.

가이드

Reader LM 0.5B를 효과적으로 배포하려면 조직은 인프라가 모델의 CUDA 요구 사항을 충족할 수 있는지 확인해야 합니다. 하지만 효율적인 아키텍처는 소비자급 GPU에서 실행될 수 있음을 의미합니다. 이 모델은 원시 HTML 입력에서 가장 잘 작동하며 특별한 접두사나 지시문이 필요하지 않습니다. 최상의 성능을 위해서는 제공된 중복 감지 메커니즘을 구현하여 출력 생성 시 잠재적인 토큰 주기를 방지하세요. 모델은 여러 언어와 다양한 HTML 구조를 지원하지만 콘텐츠 추출 및 마크다운 변환을 위해 설계되었습니다. 텍스트 생성, 요약 또는 직접적인 질문과 답변과 같은 작업에 사용해서는 안 됩니다. 모델은 AWS SageMaker를 사용하여 프로덕션 배포할 준비가 되어 있으며 테스트 및 실험을 위해 Google Colab 노트북이 제공됩니다. 팀은 모델이 최대 256K 토큰의 매우 긴 문서를 처리할 수 있지만 이러한 대규모 입력을 처리하려면 추가 메모리 관리 전략이 필요할 수 있다는 점에 유의해야 합니다.

이 모델을 언급하는 블로그