Jina AI는 현재 AWS Sagemaker와 Hugging Face에서 사용 가능한 최신 reranker 모델 제품군의 새로운 모델을 발표합니다: jina-reranker-v1-turbo-en과 jina-reranker-v1-tiny-en입니다. 이 모델들은 표준 벤치마크에서 높은 성능을 유지하면서 속도와 크기를 최우선으로 하여, 응답 시간과 리소스 사용이 중요한 환경에서 더 빠르고 메모리 효율적인 reranking 프로세스를 제공합니다.

Reranker Turbo와 Tiny는 정보 검색 애플리케이션에서 매우 빠른 응답 시간을 위해 최적화되었습니다. 우리의 임베딩 모델처럼, 이들은 ALiBi의 대칭 양방향 변형으로 향상된 BERT 아키텍처의 변형인 JinaBERT 아키텍처를 사용합니다. 이 아키텍처는 최대 8,192 토큰까지 지원하여 긴 텍스트 시퀀스를 처리할 수 있으며, 더 큰 문서의 심층 분석과 상세한 언어 이해가 필요한 복잡한 쿼리에 이상적입니다.

Turbo와 Tiny 모델은 Jina Reranker v1에서 얻은 통찰력을 바탕으로 합니다. Reranking은 정보 검색 애플리케이션의 주요 병목 지점이 될 수 있습니다. 전통적인 검색 애플리케이션은 성능이 잘 이해된 매우 성숙한 기술입니다. Reranker는 텍스트 기반 검색에 많은 정밀도를 더하지만, AI 모델은 크고 실행이 느리며 비용이 많이 들 수 있습니다.

많은 사용자들은 정확도가 다소 떨어지더라도 더 작고, 빠르며, 저렴한 모델을 선호합니다. 검색 결과 reranking이라는 단일 목표를 가짐으로써 모델을 간소화하고 더 컴팩트한 모델로도 경쟁력 있는 성능을 제공할 수 있습니다. 은닉층을 줄임으로써 처리 속도를 높이고 모델 크기를 줄입니다. 이러한 모델들은 운영 비용이 적게 들고, 더 빠른 속도로 지연을 크게 허용할 수 없는 애플리케이션에 더 유용하며, 더 큰 모델의 성능을 거의 그대로 유지합니다.

이 글에서는 Reranker Turbo와 Reranker Tiny의 아키텍처를 보여주고, 그 성능을 측정하며, 이들을 시작하는 방법을 알려드리겠습니다.

tag간소화된 아키텍처

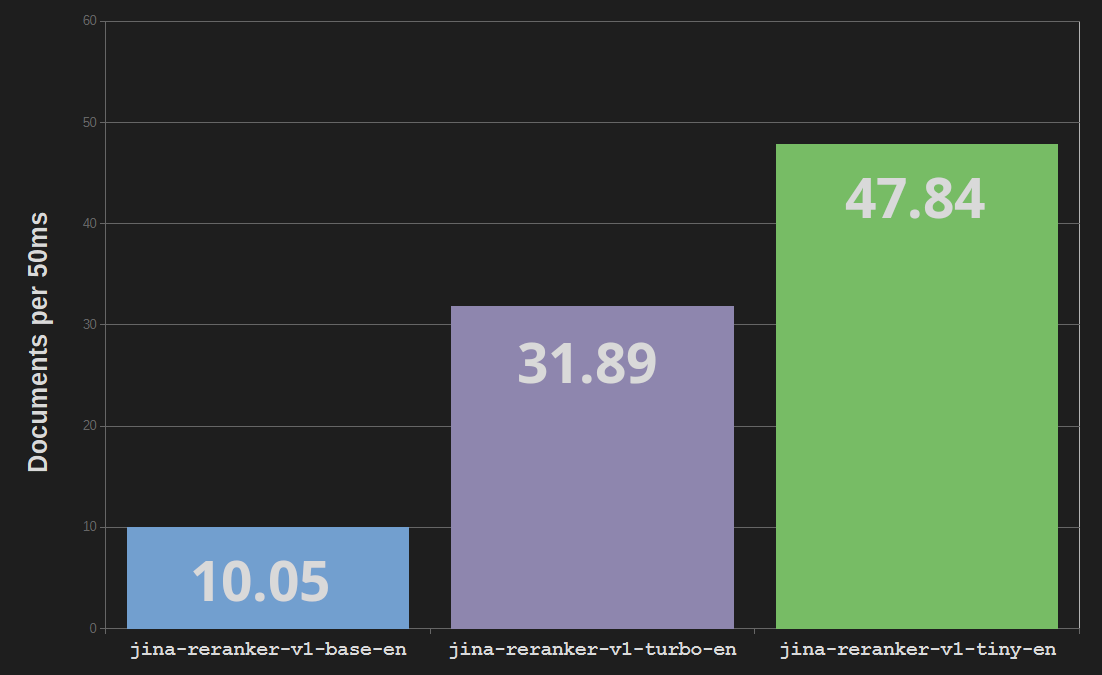

Jina Reranker Turbo (jina-reranker-v1-turbo-en)는 총 3,780만 개의 파라미터를 가진 6층 구조를 사용하는데, 이는 기본 reranker 모델 jina-reranker-v1-base-en의 1억 3,700만 파라미터와 12층 구조와 대비됩니다. 이는 모델 크기를 4분의 3만큼 줄이고 처리 속도를 최대 3배까지 높인 것입니다.

Reranker Tiny (jina-reranker-v1-tiny-en)는 3,300만 개의 파라미터를 가진 4층 구조를 사용하여 더 높은 병렬 처리와 더 빠른 속도를 제공하며 - 기본 Reranker 모델보다 거의 5배 빠름 - Turbo 모델에 비해 13%의 메모리 비용을 절약합니다.

tag지식 증류

우리는 지식 증류를 사용하여 Reranker Turbo와 Tiny를 훈련시켰습니다. 이는 기존 AI 모델을 사용하여 다른 모델이 그 동작을 따라하도록 훈련시키는 기술입니다. 외부 데이터 소스를 사용하는 대신, 우리는 기존 모델을 사용하여 훈련 데이터를 생성합니다. Jina Reranker 기본 모델을 사용하여 문서 컬렉션을 랭킹하고 그 결과를 Turbo와 Tiny 모두를 훈련시키는 데 사용했습니다. 이렇게 함으로써 실제 데이터의 제한을 받지 않고 훈련 프로세스에 더 많은 데이터를 가져올 수 있습니다.

이는 학생이 선생님으로부터 배우는 것과 비슷합니다: 이미 훈련된 고성능 모델 - Jina Reranker Base 모델 - 이 새로운 훈련 데이터를 생성하여 훈련되지 않은 Jina Turbo와 Jina Tiny 모델을 "가르칩니다". 이 기술은 큰 모델에서 작은 모델을 만드는 데 널리 사용됩니다. 가장 좋은 경우, "선생님" 모델과 "학생" 모델 간의 태스크 성능 차이는 매우 작을 수 있습니다.

tagBEIR에서의 평가

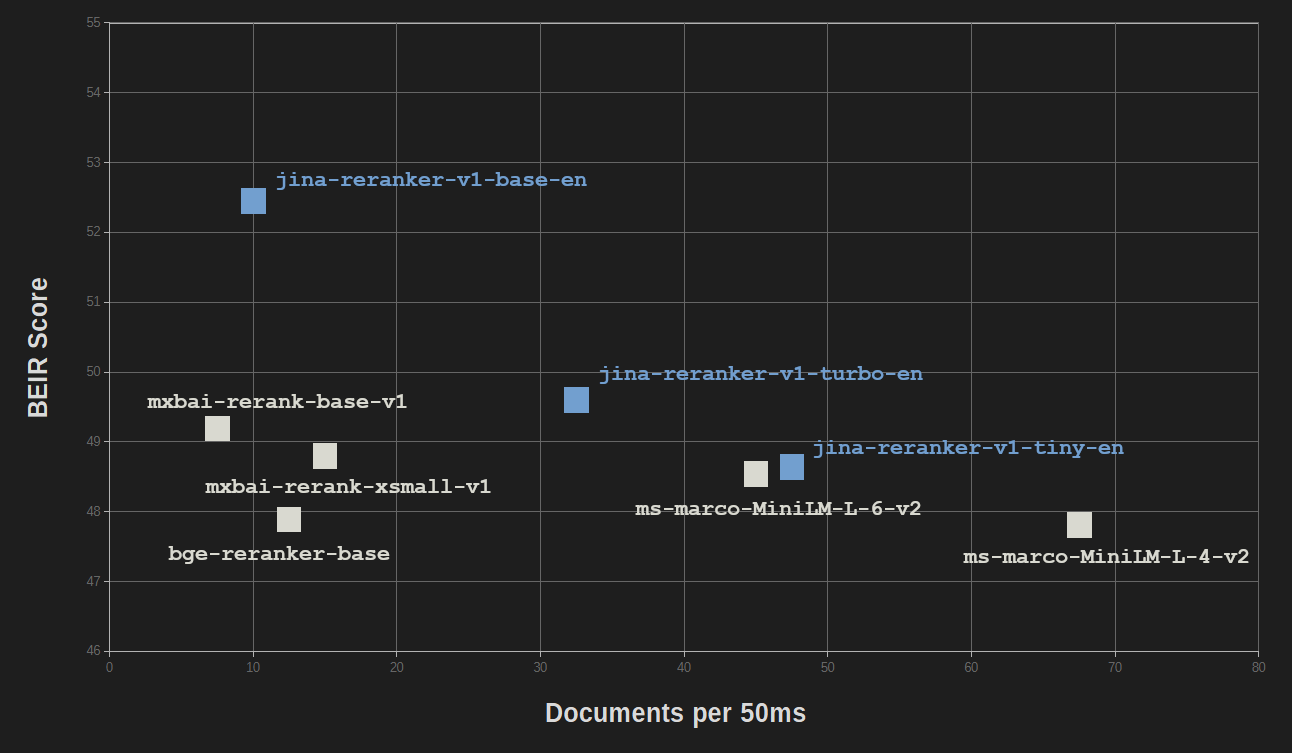

간소화와 지식 증류의 이점은 성능 품질에 상대적으로 적은 비용으로 얻어집니다. 정보 검색을 위한 BEIR 벤치마크에서 jina-reranker-v1-turbo-en은 jina-reranker-v1-base-en의 정확도의 95% 정도를 기록했으며, jina-reranker-v1-tiny-en은 기본 모델 점수의 92.5%를 기록했습니다.

모든 Jina Reranker 모델은 대부분 훨씬 더 큰 크기를 가진 다른 인기 있는 reranker 모델들과 경쟁력이 있습니다.

| Model | BEIR Score (NDCC@10) | Parameters |

|---|---|---|

| Jina Reranker models | ||

| jina-reranker-v1-base-en | 52.45 | 137M |

| jina-reranker-v1-turbo-en | 49.60 | 38M |

| jina-reranker-v1-tiny-en | 48.54 | 33M |

| Other reranking models | ||

mxbai-rerank-base-v1 |

49.19 | 184M |

mxbai-rerank-xsmall-v1 |

48.80 | 71M |

ms-marco-MiniLM-L-6-v2 |

48.64 | 23M |

bge-reranker-base |

47.89 | 278M |

ms-marco-MiniLM-L-4-v2 |

47.81 | 19M |

NDCC@10: 상위 10개 결과에 대한 정규화된 할인 누적 이득을 사용하여 계산된 점수입니다.

오직 MiniLM-L6 (ms-marco-MiniLM-L-6-v2)와 MiniLM-L4 (ms-marco-MiniLM-L-4-v2)만이 비슷한 크기와 속도를 가지고 있으며, jina-reranker-v1-turbo-en과 jina-reranker-v1-tiny-en은 이와 비슷하거나 훨씬 더 좋은 성능을 보여줍니다.

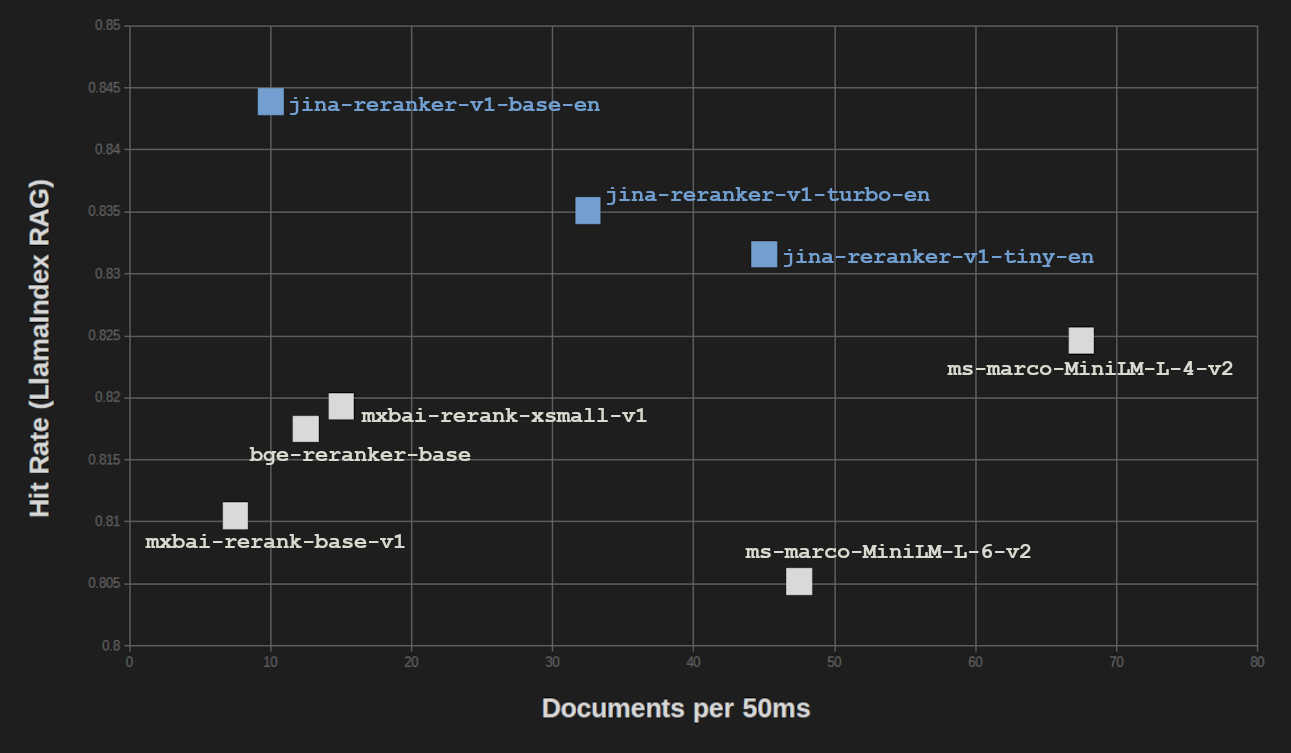

LlamaIndex RAG 벤치마크에서도 비슷한 결과를 얻었습니다. 벡터 검색을 위한 세 가지 임베딩 모델(jina-embeddings-v2-base-en, bge-base-en-v1.5, Cohere-embed-english-v3.0)을 사용하여 RAG 설정에서 세 가지 Jina Reranker를 모두 테스트하고 점수를 평균냈습니다.

| Reranker Model | Avg. Hit Rate | Avg. MRR |

|---|---|---|

| Jina Reranker models | ||

| jina-reranker-v1-base-en | 0.8439 | 0.7006 |

| jina-reranker-v1-turbo-en | 0.8351 | 0.6498 |

| jina-reranker-v1-tiny-en | 0.8316 | 0.6761 |

| Other reranking models | ||

mxbai-rerank-base-v1 |

0.8105 | 0.6583 |

mxbai-rerank-xsmall-v1 |

0.8193 | 0.6673 |

ms-marco-MiniLM-L-6-v2 |

0.8052 | 0.6121 |

bge-reranker-base |

0.8175 | 0.6480 |

ms-marco-MiniLM-L-4-v2 |

0.8246 | 0.6354 |

MRR: 평균 역순위

검색 증강 생성(RAG) 작업의 경우, BEIR 순수 정보 검색 벤치마크보다 결과 품질의 손실이 더 적습니다. RAG 성능을 처리 속도와 비교할 때, ms-marco-MiniLM-L-4-v2만이 상당히 높은 처리량을 제공하지만, 이는 결과 품질의 상당한 손실을 감수해야 합니다.

tagAWS에서의 비용 절감

Reranker Turbo와 Reranker Tiny를 사용하면 메모리 사용량과 CPU 시간에 대해 비용을 지불하는 AWS와 Azure 사용자들에게 큰 비용 절감 효과가 있습니다. 사용 사례에 따라 절감 정도는 다르지만, 메모리 사용량이 약 75% 감소한다는 것은 메모리 비용을 청구하는 클라우드 시스템에서 직접적으로 75%의 비용 절감으로 이어집니다.

또한, 더 빠른 처리량 덕분에 더 저렴한 AWS 인스턴스에서 더 많은 쿼리를 실행할 수 있습니다.

tag시작하기

Jina Reranker 모델은 사용하기 쉽고 애플리케이션과 워크플로우에 쉽게 통합할 수 있습니다. 시작하려면 Reranker API 페이지를 방문하여 서비스 사용 방법을 확인하고 직접 시도해볼 수 있는 100만 개의 무료 토큰을 받으세요.

우리의 모델은 또한 AWS SageMaker에서도 사용 가능합니다. 자세한 정보는 AWS에서 검색 증강 생성 시스템을 설정하는 방법에 대한 튜토리얼을 참조하세요.

Jina Reranker 모델은 Apache 2.0 라이선스하에 Hugging Face에서 다운로드할 수 있습니다: