Доступно через

График ввода-вывода

Выберите модели для сравнения

Публикации (3)

Обзор

Jina Embeddings v3 — это новаторская многоязычная модель встраивания текста, которая преобразует то, как организации справляются с пониманием и поиском текста на разных языках. По своей сути, она решает критическую задачу поддержания высокой производительности на разных языках и задачах, сохраняя при этом управляемость вычислительных требований. Модель особенно блестит в производственных средах, где важна эффективность — она достигает самой современной производительности всего с 570 млн параметров, что делает ее доступной для команд, которые не могут позволить себе вычислительные издержки более крупных моделей. Организации, которым необходимо создавать масштабируемые многоязычные поисковые системы или анализировать контент, несмотря на языковые барьеры, найдут эту модель особенно ценной.

Методы

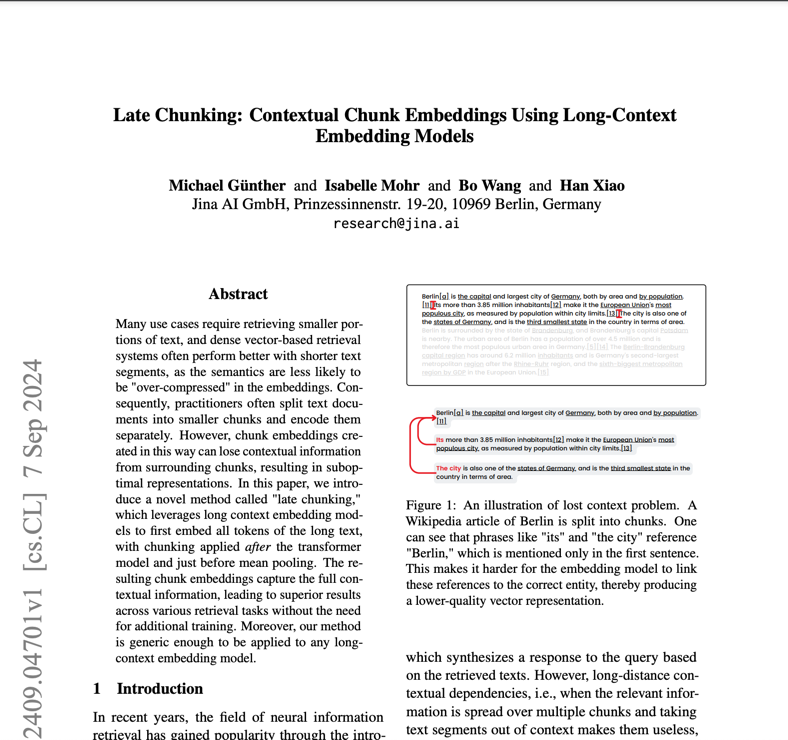

Архитектура модели представляет собой значительное новшество в технологии встраивания, построенное на основе jina-XLM-RoBERTa с 24 слоями и улучшенное с помощью адаптеров Low-Rank Adaptation (LoRA) для конкретных задач. Адаптеры LoRA — это специализированные компоненты нейронной сети, которые оптимизируют модель для различных задач, таких как поиск, классификация или кластеризация, без значительного увеличения количества параметров — они добавляют менее 3% к общему количеству параметров. Модель включает в себя Matryoshka Representation Learning (MRL), что позволяет гибко сокращать встраивания с 1024 до 32 измерений, сохраняя производительность. Обучение включало трехэтапный процесс: начальное предварительное обучение на многоязычном тексте из 89 языков, тонкую настройку на парных текстах для качества встраивания и специализированное обучение адаптера для оптимизации задач. Модель поддерживает длину контекста до 8192 токенов с помощью Rotary Position Embeddings (RoPE) с инновационной методикой регулировки базовой частоты, которая повышает производительность как для коротких, так и для длинных текстов.

Производительность

Модель демонстрирует исключительное соотношение эффективности и производительности в реальных тестах, превосходя как альтернативы с открытым исходным кодом, так и фирменные решения от OpenAI и Cohere в задачах на английском языке, при этом превосходя в многоязычных сценариях. Самое удивительное, что она достигает лучших результатов, чем e5-mistral-7b-instruct, которая имеет в 12 раз больше параметров, что подчеркивает ее замечательную эффективность. В оценках MTEB она достигает среднего балла 65,52 по всем задачам, с особенно высокими показателями точности классификации (82,58) и сходства предложений (85,80). Модель сохраняет стабильную производительность на разных языках, набрав 64,44 балла на многоязычных задачах. При использовании MRL для сокращения размерности она сохраняет высокую производительность даже в более низких размерностях - например, сохраняя 92% своей производительности поиска при 64 измерениях по сравнению с полными 1024 измерениями.

Руководство

Для эффективного развертывания Jina Embeddings v3 команды должны рассмотреть свой конкретный вариант использования, чтобы выбрать подходящий адаптер задач: retrieval.query и retrieval.passage для поисковых приложений, разделение для задач кластеризации, классификация для категоризации и сопоставление текста для семантического сходства. Для оптимальной производительности модели требуется оборудование с поддержкой CUDA, хотя ее эффективная архитектура означает, что ей требуется значительно меньше памяти GPU, чем более крупным альтернативам. Для производственного развертывания интеграция AWS SageMaker обеспечивает оптимизированный путь к масштабируемости. Модель отлично работает в многоязычных приложениях, но может потребовать дополнительной оценки для языков с низкими ресурсами. Хотя она поддерживает длинные документы до 8192 токенов, оптимальная производительность достигается с помощью функции позднего фрагментирования для очень длинных текстов. Командам следует избегать использования модели для задач, требующих генерации в реальном времени или сложных рассуждений — она предназначена для встраивания и извлечения, а не для генерации текста или прямых ответов на вопросы.

Блоги, в которых упоминается эта модель