Выберите модели для сравнения

Обзор

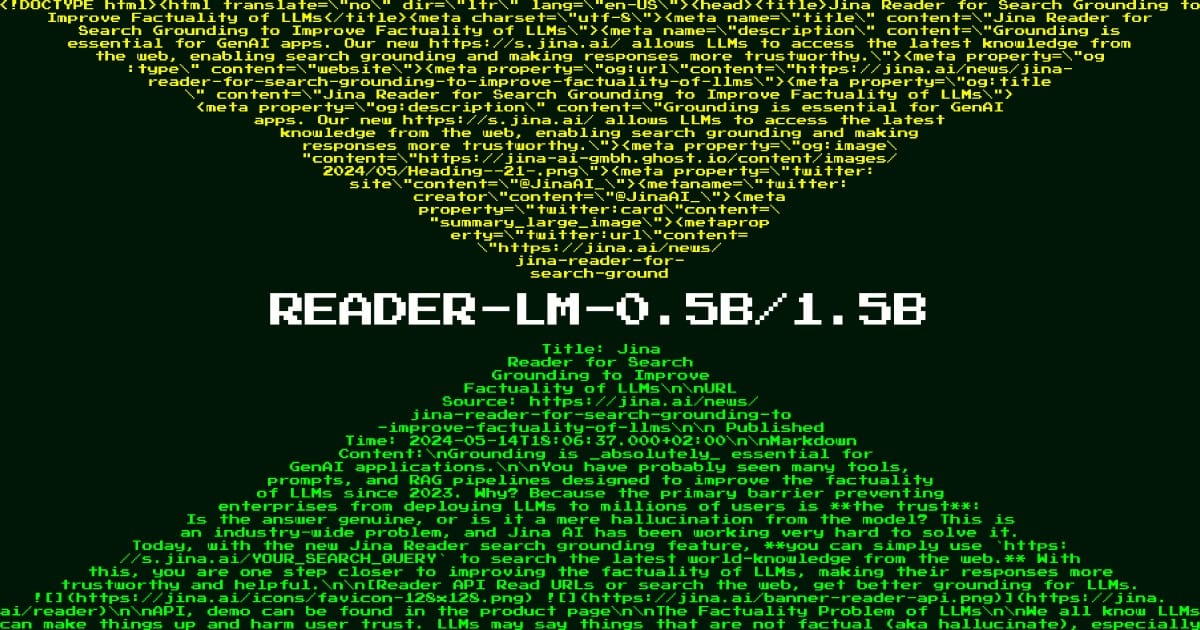

Reader LM 1.5B представляет собой прорыв в эффективной обработке документов, решая критическую задачу преобразования сложного веб-контента в чистые, структурированные форматы. Эта специализированная языковая модель решает фундаментальную проблему современных конвейеров ИИ: необходимость эффективной обработки и очистки HTML-контента для последующих задач без использования хрупких систем на основе правил или ресурсоемких больших языковых моделей. Что делает эту модель по-настоящему замечательной, так это ее способность превосходить модели в 50 раз по размеру, сохраняя при этом удивительно компактный размер параметров в 1,54 млрд. Организации, занимающиеся крупномасштабной обработкой веб-контента, автоматизацией документации или системами управления контентом, найдут эту модель особенно ценной из-за ее способности обрабатывать чрезвычайно длинные документы, обеспечивая при этом превосходную точность преобразования HTML в разметку.

Методы

Модель использует инновационную архитектуру «неглубокая, но широкая», которая бросает вызов традиционным подходам к масштабированию в разработке языковой модели. В ее основе лежат 28 слоев преобразователя, настроенных с 12 головками запросов и 2 головками ключ-значение, что создает уникальный баланс, который оптимизирует операции выборочного копирования, сохраняя при этом глубокое семантическое понимание. Архитектура имеет скрытый размер 1536 и промежуточный размер 8960, тщательно настроенные для обработки последовательностей до 256 тыс. токенов. Процесс обучения включал два отдельных этапа: сначала фокусировка на коротком и простом HTML с последовательностями из 32 тыс. токенов, затем переход к длинному и сложному HTML с 128 тыс. токенов, реализация зигзагообразного кольца-внимания для эффективной обработки. Этот подход в сочетании с контрастным поиском и специализированными механизмами обнаружения повторений позволяет модели избегать распространенных проблем, таких как вырождение и скучные циклы, которые обычно мешают небольшим языковым моделям обрабатывать сложные задачи обработки документов.

Производительность

В комплексных бенчмарк-оценках Reader LM 1.5B демонстрирует исключительные возможности, бросающие вызов отраслевым стандартам. Модель достигает оценки ROUGE-L 0,72 и коэффициента ошибок токенов 0,19, значительно превосходя более крупные модели, такие как GPT-4 (0,43 ROUGE-L, 0,50 TER) и Gemini-1.5-Pro (0,42 ROUGE-L, 0,48 TER) в задачах преобразования HTML в разметку. Ее производительность особенно блестит в качественных оценках по четырем ключевым измерениям: извлечение заголовка, извлечение основного контента, сохранение расширенной структуры и использование синтаксиса разметки. Модель постоянно поддерживает высокую точность для различных типов документов, от новостных статей и сообщений в блогах до целевых страниц и сообщений на форумах, на нескольких языках, включая английский, немецкий, японский и китайский. Такая производительность достигается при обработке документов длиной до 256 тыс. токенов, что устраняет необходимость в дорогостоящих операциях по фрагментации, которые обычно требуются для более крупных моделей.

Руководство

Для эффективного развертывания Reader LM 1.5B организации должны сосредоточиться на сценариях, включающих сложную обработку HTML-документов, где точность и эффективность имеют первостепенное значение. Для оптимальной производительности модели требуется инфраструктура графического процессора с поддержкой CUDA, хотя ее эффективная архитектура означает, что она может эффективно работать на более скромном оборудовании по сравнению с более крупными альтернативами. Для производственных развертываний модель доступна как через AWS SageMaker, так и через Azure Marketplace, предлагая гибкие возможности интеграции. Хотя модель отлично справляется с преобразованием HTML в markdown, важно отметить, что она специально оптимизирована для этой задачи и может не подходить для генерации текста общего назначения или других задач обработки естественного языка. При обработке очень длинных документов (приближающихся к 512 тыс. токенов) пользователи должны знать, что производительность может ухудшиться, поскольку это превышает параметры обучения модели. Для достижения оптимальных результатов реализуйте предоставленные механизмы обнаружения повторений и рассмотрите возможность использования сопоставительного поиска во время вывода для поддержания качества вывода.

Блоги, в которых упоминается эта модель