I/O 图 1

I/O 图 2

I/O 图 3

选择要比较的模型

出版物 (1)

概述

ReaderLM-v2 是一个 1.5B 参数语言模型,可将原始 HTML 转换为 markdown 或 JSON,处理最多 512K 个词元组合输入/输出长度,支持 29 种语言。与将 HTML 到 markdown 视为“选择性复制”任务的前身不同,v2 将其视为翻译过程,从而能够出色地处理代码围栏、嵌套列表、表格和 LaTeX 方程式等复杂元素。该模型在不同的上下文长度下保持一致的性能,并引入了具有预定义架构的直接 HTML 到 JSON 生成功能。

方法

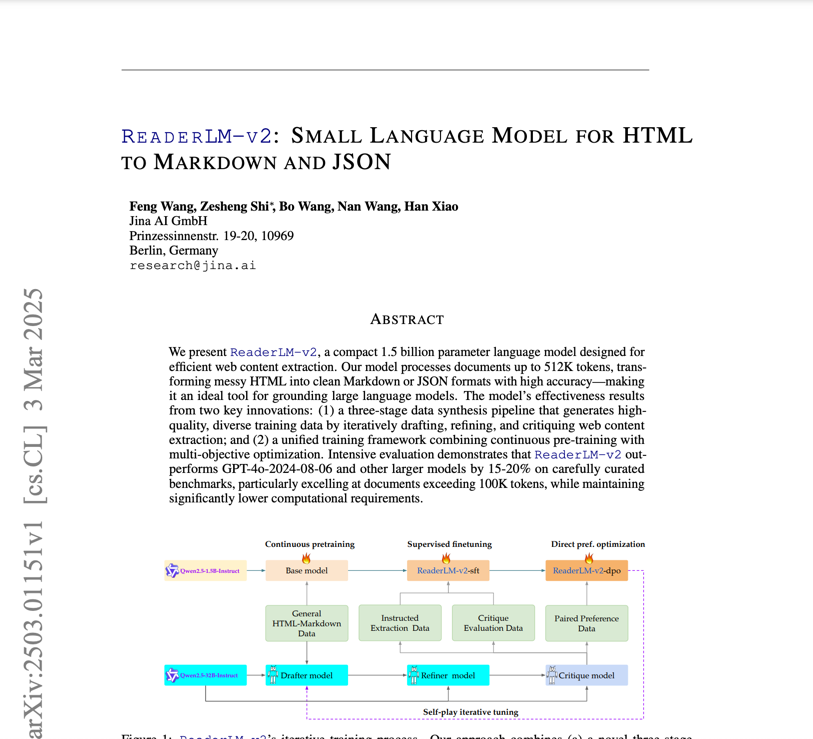

ReaderLM-v2 基于 Qwen2.5-1.5B-Instruction 构建,其训练基于一个包含一千万个 HTML 文档的 html-markdown-1m 数据集,每个文档平均包含 56,000 个 token。训练过程包括:1) 使用 Ring-zag Attention 和 RoPE 进行长上下文预训练,将上下文从 32,000 个 token 扩展到 256,000 个 token;2) 使用精炼数据集进行监督微调;3) 直接偏好优化以实现输出对齐;以及 4) 自我对弈强化调整。数据准备遵循由 Qwen2.5-32B-Instruction 驱动的三步流程(起草-精炼-评审),其中针对特定任务训练了专门的模型,然后通过线性参数插值进行合并。

性能

在综合基准测试中,ReaderLM-v2 在 HTML 到 Markdown 任务上的表现优于 Qwen2.5-32B-Instruct 和 Gemini2-flash-expr 等大型模型。对于主要内容提取,它实现了 0.84 的 ROUGE-L、0.82 的 Jaro-Winkler,并且与竞争对手相比,Levenshtein 距离 (0.22) 明显更低。在 HTML 到 JSON 任务中,它保持了具有竞争力的性能,F1 得分为 0.81,通过率为 98%。该模型在 T4 GPU 上以 67 个 token/s 的输入和 36 个 token/s 的输出进行处理,通过对比损失训练显著减少了退化问题。

最佳实践

该模型可通过 Google Colab 笔记本访问,该笔记本演示了 HTML 到 Markdown 的转换、JSON 提取和指令遵循。对于 HTML 到 Markdown 任务,用户可以输入没有前缀指令的原始 HTML,而 JSON 提取则需要特定的架构格式。create_prompt 辅助函数有助于轻松为这两个任务创建提示。虽然该模型可以在 Colab 的免费 T4 GPU 层上运行(需要 vllm 和 triton),但如果不支持 bfloat16 或 flash Attention 2,则存在局限性。建议将 RTX 3090/4090 用于生产用途。该模型将在 AWS SageMaker、Azure 和 GCP 市场上提供,根据 CC BY-NC 4.0 许可用于非商业用途。

提及此模型的博客