I/O 圖

選擇要比較的模型

出版物 (3)

概述

Jina Embeddings v3 是一種突破性的多語言文本向量模型,它改變了組織處理跨語言文本理解和檢索的方式。從本質上講,它解決了在多種語言和任務中保持高性能,同時保持計算要求可控的關鍵挑戰。該模型在效率至關重要的生產環境中尤其出色 - 它僅用 5.7 億個參數就實現了最先進的性能,這使得無法承擔較大模型計算開銷的團隊也可以使用它。需要構建可擴展的多語言搜索系統或跨語言障礙分析內容的組織會發現這個模型特別有價值。

方法

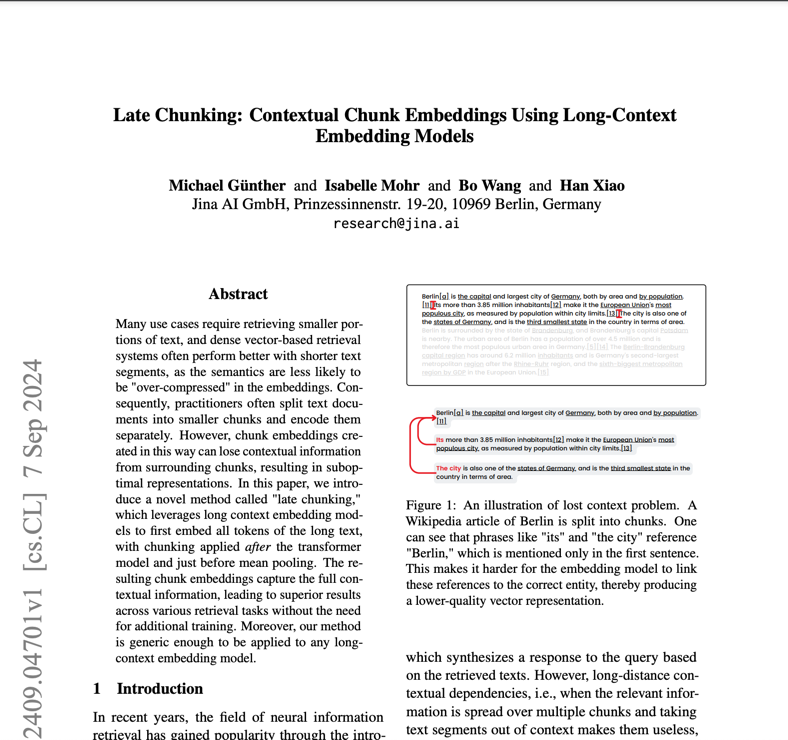

該模型的架構代表了向量技術的重大創新,它建立在具有 24 層的 jina-XLM-RoBERTa 基礎上,並通過特定於任務的低秩自適應 (LoRA) 適配器進行了增強。LoRA 適配器是專門的神經網絡組件,可針對不同的任務(如檢索、分類或聚類)優化模型,而不會顯着增加參數數量 - 它們使總參數增加不到 3%。該模型結合了 Matryoshka 表示學習 (MRL),允許將向量從 1024 維靈活地減少到 32 維,同時保持性能。訓練涉及三個階段:對來自 89 種語言的多語言文本進行初始預訓練,對成對文本進行微調以提高向量質量,以及專門的適配器訓練以優化任務。該模型通過旋轉位置向量 (RoPE) 支持高達 8,192 個詞元的上下文長度,並採用創新的基頻調整技術來提高短文本和長文本的性能。

性能

該模型在實際測試中展現出卓越的效率性能比,在英語任務上的表現優於開源替代方案以及來自 OpenAI 和 Cohere 的專有解決方案,同時在多語言場景中也表現出色。最令人驚訝的是,它取得了比參數多 12 倍的 e5-mistral-7b-instruct 更好的結果,凸顯了其卓越的效率。在 MTEB 基準評估中,它在所有任務中獲得了 65.52 的平均分數,在分類準確率(82.58)和句子相似度(85.80)方面表現尤為出色。該模型在不同語言中保持一致的性能,在多語言任務上的得分為 64.44。當使用 MRL 進行降維時,即使在較低維度下也能保持強勁性能 - 例如,與完整的 1024 維相比,64 維可以保持 92% 的檢索性能。

最佳實踐

為了有效部署 Jina Embeddings v3,團隊應考慮其特定用例以選擇適當的任務適配器:搜索應用程序使用 retrieval.query 和 retrieval.passage,聚類任務使用分離,分類使用分類,語義相似性使用文本匹配。該模型需要具有 CUDA 功能的硬件才能獲得最佳性能,但其高效的架構意味着它所需的 GPU 內存比更大的替代方案少得多。對於生產部署,AWS SageMaker 集成提供了一條簡化的可擴展性路徑。該模型在多語言應用程序中表現出色,但對於資源匱乏的語言可能需要額外的評估。雖然它支持多達 8,192 個詞元的長文檔,但對於非常長的文本,使用後期分塊功能可實現最佳性能。團隊應避免將該模型用於需要實時生成或複雜推理的任務 - 它是為向量和檢索而設計的,而不是文本生成或直接問答。

提及此模型的博客