Erhältlich über

Wählen Sie Modelle zum Vergleichen aus

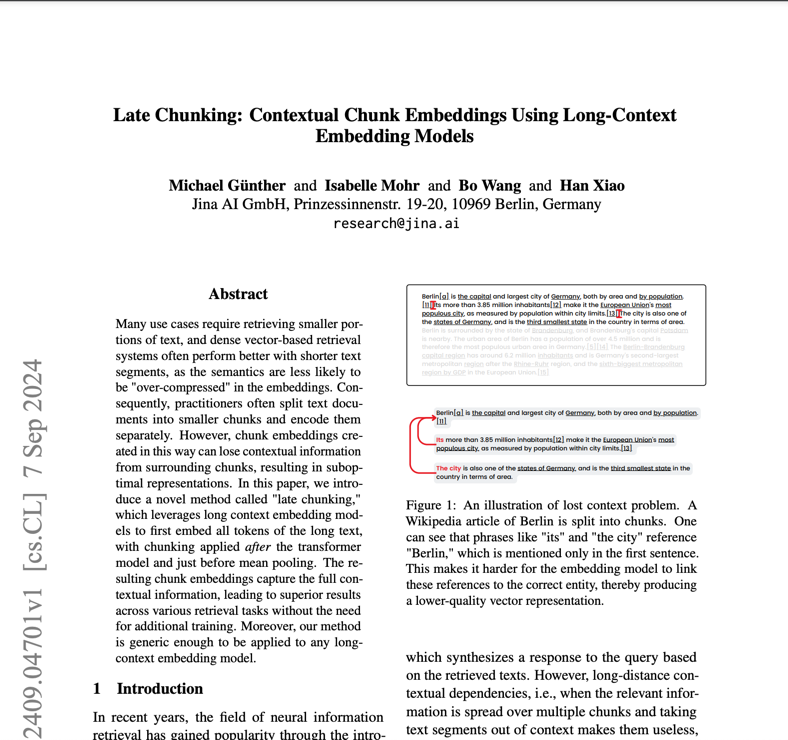

Publikationen (3)

Überblick

Jina Embeddings v2 Base English ist ein bahnbrechendes Open-Source-Text-Embedding-Modell, das die kritische Herausforderung der Verarbeitung langer Dokumente bei gleichzeitig hoher Genauigkeit löst. Organisationen, die mit der Analyse umfangreicher juristischer Dokumente, Forschungsarbeiten oder Finanzberichte zu kämpfen haben, werden dieses Modell besonders wertvoll finden. Es zeichnet sich dadurch aus, dass es Dokumente mit einer Länge von bis zu 8.192 Token verarbeiten kann – 16-mal länger als herkömmliche Modelle – und dabei die gleiche Leistung wie die proprietären Lösungen von OpenAI bietet. Mit einer kompakten Größe von 0,27 GB und effizienter Ressourcennutzung bietet es eine zugängliche Lösung für Teams, die erweiterte Dokumentanalysen ohne übermäßigen Rechenaufwand implementieren möchten.

Methoden

Die Architektur des Modells kombiniert ein BERT Small-Backbone mit einem innovativen symmetrischen bidirektionalen ALiBi-Mechanismus (Attention with Linear Biases), wodurch die Notwendigkeit herkömmlicher Positionseinbettungen entfällt. Diese architektonische Wahl ermöglicht es dem Modell, weit über seine Trainingslänge von 512 Token hinaus zu extrapolieren und Sequenzen von bis zu 8.192 Token ohne Leistungseinbußen zu verarbeiten. Der Trainingsprozess umfasste zwei Schlüsselphasen: anfängliches Vortraining auf dem C4-Datensatz, gefolgt von einer Verfeinerung auf der kuratierten Sammlung von über 40 spezialisierten Datensätzen von Jina AI. Diese vielfältigen Trainingsdaten, darunter anspruchsvolle Negativbeispiele und abwechslungsreiche Satzpaare, gewährleisten eine robuste Leistung in verschiedenen Bereichen und Anwendungsfällen. Das Modell erzeugt 768-dimensionale dichte Vektoren, die nuancierte semantische Beziehungen erfassen, was mit relativ bescheidenen 137 Millionen Parametern erreicht wird.

Leistung

In Tests unter realen Bedingungen zeigt Jina Embeddings v2 Base English außergewöhnliche Fähigkeiten in mehreren Benchmarks. Es übertrifft OpenAIs text-embedding-ada-002 in mehreren wichtigen Metriken: Klassifizierung (73,45 % vs. 70,93 %), Neubewertung (85,38 % vs. 84,89 %), Abruf (56,98 % vs. 56,32 %) und Zusammenfassung (31,6 % vs. 30,8 %). Diese Zahlen bedeuten praktische Vorteile bei Aufgaben wie der Dokumentklassifizierung, bei der das Modell eine überlegene Fähigkeit zur Kategorisierung komplexer Texte zeigt, und bei Suchanwendungen, bei denen es Benutzeranfragen besser versteht und relevante Dokumente findet. Benutzer sollten jedoch beachten, dass die Leistung bei der Verarbeitung hochspezialisierter domänenspezifischer Inhalte, die nicht in den Trainingsdaten enthalten sind, variieren kann.

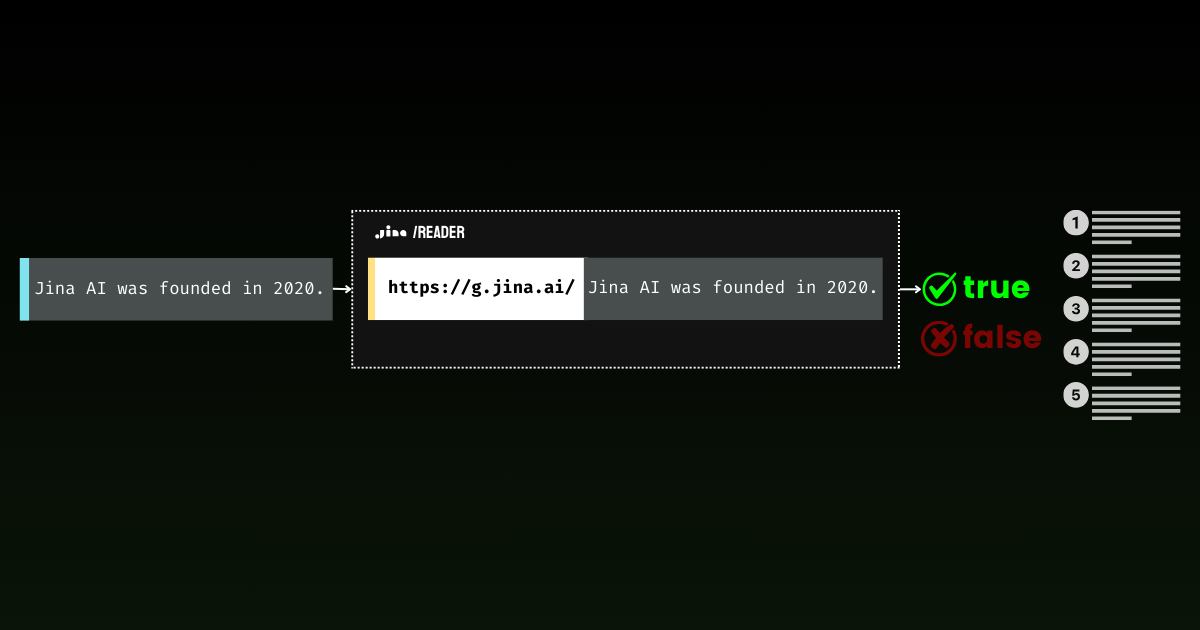

Anleitung

Um Jina Embeddings v2 Base English effektiv einzusetzen, sollten Teams verschiedene praktische Aspekte berücksichtigen. Das Modell benötigt CUDA-fähige Hardware für optimale Leistung, ist dank seiner effizienten Architektur jedoch auch auf handelsüblichen GPUs lauffähig. Es ist über verschiedene Kanäle verfügbar: Direkter Download von Hugging Face, Bereitstellung im AWS Marketplace oder die Jina AI API mit 10 Millionen kostenlosen Token. Für Produktionsbereitstellungen bietet AWS SageMaker in der Region us-east-1 die skalierbarste Lösung. Das Modell eignet sich hervorragend für allgemeine Textanalysen, ist aber ohne Feinabstimmung möglicherweise nicht die beste Wahl für hochspezialisierte wissenschaftliche Terminologie oder fachspezifischen Jargon. Bei der Verarbeitung langer Dokumente sollten Sie diese in sinnvolle semantische Abschnitte zerlegen, anstatt sie willkürlich aufzuteilen, um die Kontextintegrität zu wahren. Für optimale Ergebnisse implementieren Sie eine geeignete Textvorverarbeitung und stellen Sie saubere, gut formatierte Eingabedaten sicher.

Blogs, die dieses Modell erwähnen