Erhältlich über

E/A-Diagramm

Wählen Sie Modelle zum Vergleichen aus

Publikationen (3)

Überblick

Jina Embeddings v3 ist ein bahnbrechendes mehrsprachiges Text-Embedding-Modell, das die Art und Weise verändert, wie Organisationen Textverständnis und -abruf über verschiedene Sprachen hinweg handhaben. Im Kern löst es die kritische Herausforderung, eine hohe Leistung über mehrere Sprachen und Aufgaben hinweg aufrechtzuerhalten und gleichzeitig die Rechenleistungsanforderungen überschaubar zu halten. Das Modell glänzt insbesondere in Produktionsumgebungen, in denen es auf Effizienz ankommt – es erreicht modernste Leistung mit nur 570 Millionen Parametern und ist damit für Teams zugänglich, die sich den Rechenaufwand größerer Modelle nicht leisten können. Organisationen, die skalierbare, mehrsprachige Suchsysteme erstellen oder Inhalte über Sprachbarrieren hinweg analysieren müssen, werden dieses Modell besonders wertvoll finden.

Methoden

Die Architektur des Modells stellt eine bedeutende Innovation in der Einbettungstechnologie dar. Sie basiert auf jina-XLM-RoBERTa mit 24 Schichten und wurde mit aufgabenspezifischen Low-Rank Adaptation (LoRA)-Adaptern erweitert. LoRA-Adapter sind spezialisierte neuronale Netzwerkkomponenten, die das Modell für verschiedene Aufgaben wie Abruf, Klassifizierung oder Clustering optimieren, ohne die Parameteranzahl wesentlich zu erhöhen – sie erhöhen die Gesamtparameter um weniger als 3 %. Das Modell enthält Matryoshka Representation Learning (MRL), wodurch Einbettungen flexibel von 1024 auf bis zu 32 Dimensionen reduziert werden können, während die Leistung erhalten bleibt. Das Training umfasste einen dreistufigen Prozess: anfängliches Vortraining mit mehrsprachigem Text aus 89 Sprachen, Feinabstimmung gepaarter Texte für die Einbettungsqualität und spezialisiertes Adaptertraining zur Aufgabenoptimierung. Das Modell unterstützt Kontextlängen von bis zu 8.192 Token durch Rotary Position Embeddings (RoPE) mit einer innovativen Basisfrequenzanpassungstechnik, die die Leistung sowohl bei kurzen als auch bei langen Texten verbessert.

Leistung

Das Modell weist in Tests unter realen Bedingungen ein außergewöhnliches Verhältnis von Effizienz zu Leistung auf und übertrifft sowohl Open-Source-Alternativen als auch proprietäre Lösungen von OpenAI und Cohere bei englischen Aufgaben, während es in mehrsprachigen Szenarien brilliert. Am überraschendsten ist, dass es bessere Ergebnisse erzielt als e5-mistral-7b-instruct, das 12-mal mehr Parameter hat, was seine bemerkenswerte Effizienz unterstreicht. In MTEB-Benchmark-Bewertungen erreicht es über alle Aufgaben hinweg einen Durchschnittswert von 65,52, mit besonders starken Leistungen bei Klassifizierungsgenauigkeit (82,58) und Satzähnlichkeit (85,80). Das Modell behält eine konsistente Leistung über alle Sprachen hinweg bei und erreicht bei mehrsprachigen Aufgaben einen Wert von 64,44. Bei Verwendung von MRL zur Dimensionsreduzierung behält es auch bei niedrigeren Dimensionen eine starke Leistung bei – beispielsweise behält es bei 64 Dimensionen 92 % seiner Abrufleistung im Vergleich zu den vollen 1024 Dimensionen bei.

Anleitung

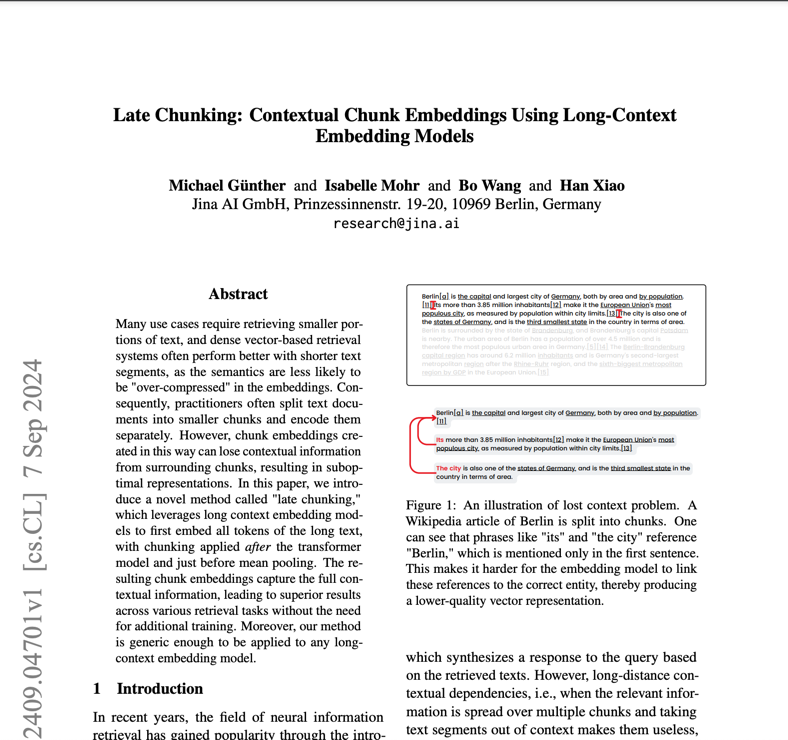

Um Jina Embeddings v3 effektiv einzusetzen, sollten Teams ihren spezifischen Anwendungsfall berücksichtigen, um den geeigneten Task-Adapter auszuwählen: retrieval.query und retrieval.passage für Suchanwendungen, Trennung für Clustering-Aufgaben, Klassifizierung für Kategorisierung und Text-Matching für semantische Ähnlichkeit. Das Modell erfordert CUDA-fähige Hardware für optimale Leistung, obwohl es aufgrund seiner effizienten Architektur deutlich weniger GPU-Speicher benötigt als größere Alternativen. Für die Produktionsbereitstellung bietet die AWS SageMaker-Integration einen optimierten Weg zur Skalierbarkeit. Das Modell eignet sich hervorragend für mehrsprachige Anwendungen, erfordert jedoch möglicherweise eine zusätzliche Evaluierung für ressourcenarme Sprachen. Obwohl es lange Dokumente mit bis zu 8.192 Token unterstützt, wird optimale Leistung mit der Late-Chunking-Funktion für sehr lange Texte erreicht. Teams sollten das Modell nicht für Aufgaben verwenden, die Echtzeitgenerierung oder komplexe Schlussfolgerungen erfordern – es ist für Einbettung und Abruf konzipiert, nicht für Textgenerierung oder direkte Beantwortung von Fragen.

Blogs, die dieses Modell erwähnen