Disponible a través de

Elige modelos para comparar

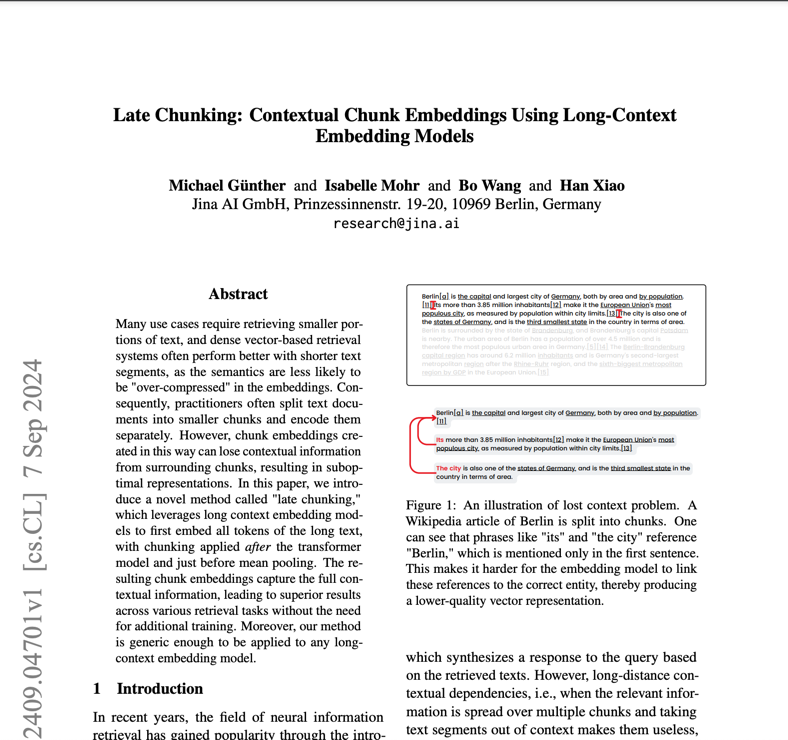

Publicaciones (3)

Descripción general

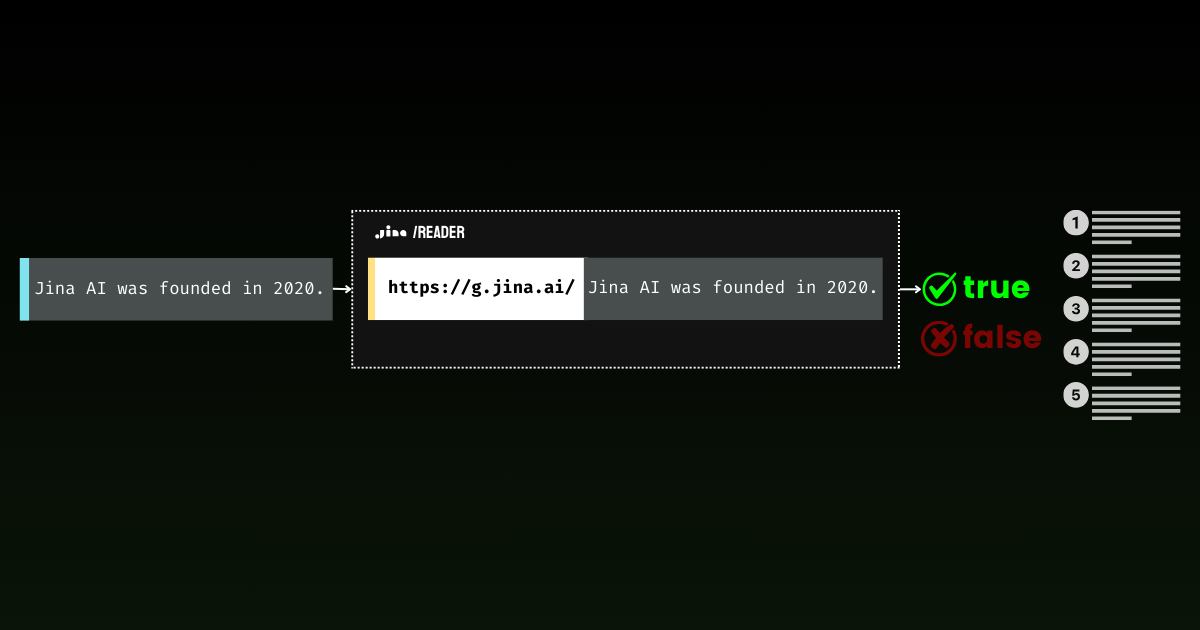

Jina Embeddings v2 Base English es un innovador modelo de incrustación de texto de código abierto que resuelve el desafío crítico de procesar documentos extensos manteniendo una alta precisión. Las organizaciones que tienen dificultades para analizar documentos legales extensos, artículos de investigación o informes financieros encontrarán este modelo particularmente valioso. Se destaca por manejar documentos de hasta 8192 tokens de longitud (16 veces más largos que los modelos tradicionales) y al mismo tiempo igualar el rendimiento de las soluciones patentadas de OpenAI. Con un tamaño compacto de 0,27 GB y un uso eficiente de los recursos, ofrece una solución accesible para los equipos que buscan implementar un análisis avanzado de documentos sin una sobrecarga computacional excesiva.

Métodos

La arquitectura del modelo combina una estructura básica BERT Small con un innovador mecanismo ALiBi (Atención con sesgos lineales) bidireccional simétrico, lo que elimina la necesidad de incrustaciones posicionales tradicionales. Esta elección arquitectónica permite al modelo extrapolar mucho más allá de su longitud de entrenamiento de 512 tokens, manejando secuencias de hasta 8192 tokens sin degradación del rendimiento. El proceso de entrenamiento implicó dos fases clave: preentrenamiento inicial en el conjunto de datos C4, seguido de refinamiento en la colección curada de más de 40 conjuntos de datos especializados de Jina AI. Estos diversos datos de entrenamiento, que incluyen ejemplos negativos desafiantes y pares de oraciones variados, garantizan un rendimiento sólido en diferentes dominios y casos de uso. El modelo produce vectores densos de 768 dimensiones que capturan relaciones semánticas matizadas, logradas con unos parámetros relativamente modestos de 137 millones.

Actuación

En pruebas reales, Jina Embeddings v2 Base English demuestra capacidades excepcionales en múltiples puntos de referencia. Supera a text-embedding-ada-002 de OpenAI en varias métricas clave: clasificación (73,45 % frente a 70,93 %), reclasificación (85,38 % frente a 84,89 %), recuperación (56,98 % frente a 56,32 %) y resumen (31,6 % frente a 30,8 %). Estas cifras se traducen en ventajas prácticas en tareas como la clasificación de documentos, donde el modelo muestra una capacidad superior para categorizar textos complejos, y en aplicaciones de búsqueda, donde comprende mejor las consultas de los usuarios y encuentra documentos relevantes. Sin embargo, los usuarios deben tener en cuenta que el rendimiento puede variar cuando se trabaja con contenido altamente especializado y específico del dominio que no está representado en los datos de entrenamiento.

Guía

Para implementar eficazmente Jina Embeddings v2 Base English, los equipos deben considerar varios aspectos prácticos. El modelo requiere hardware compatible con CUDA para un rendimiento óptimo, aunque su eficiente arquitectura permite su ejecución en GPU de consumo. Está disponible a través de múltiples canales: descarga directa desde Hugging Face, implementación en AWS Marketplace o la API de Jina AI con 10 millones de tokens gratuitos. Para implementaciones de producción, AWS SageMaker en la región us-east-1 ofrece la solución más escalable. El modelo destaca en el análisis de texto de propósito general, pero puede no ser la mejor opción para terminología científica altamente especializada o jerga específica de un dominio sin un ajuste preciso. Al procesar documentos extensos, considere dividirlos en fragmentos semánticos significativos en lugar de divisiones arbitrarias para mantener la integridad del contexto. Para obtener resultados óptimos, implemente un preprocesamiento de texto adecuado y asegúrese de que los datos de entrada estén limpios y bien formateados.

Blogs que mencionan este modelo