El anclaje es absolutamente esencial para las aplicaciones de GenAI.

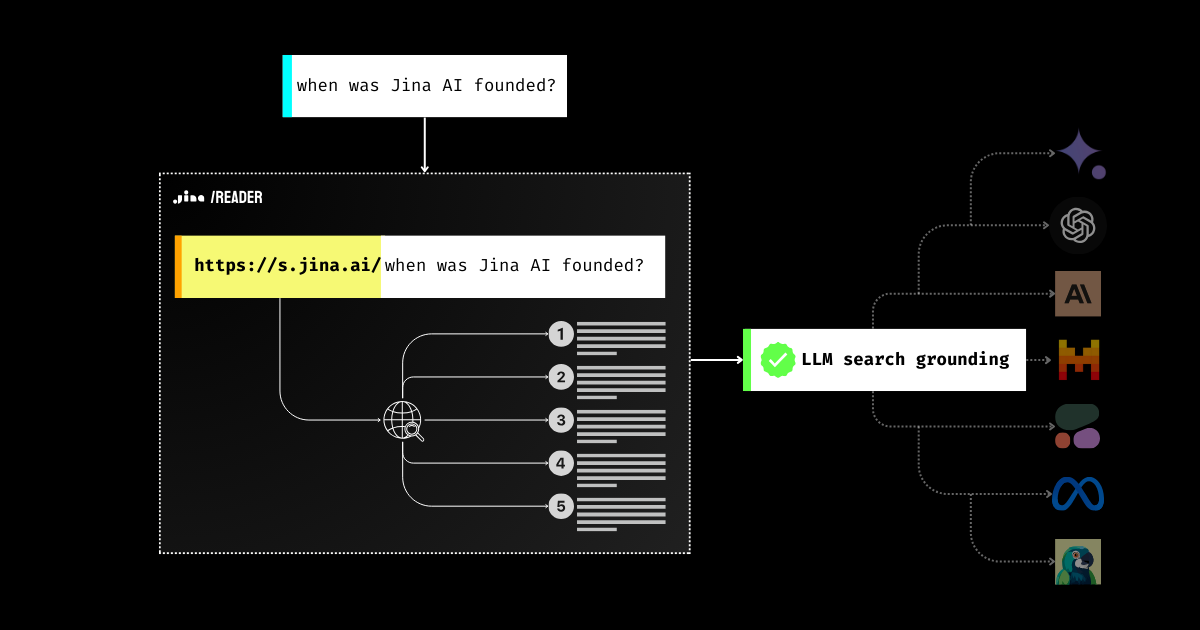

Probablemente has visto muchas herramientas, prompts y pipelines RAG diseñados para mejorar la factualidad de los LLMs desde 2023. ¿Por qué? Porque la principal barrera que impide que las empresas implementen LLMs para millones de usuarios es la confianza: ¿Es la respuesta genuina o es una mera alucinación del modelo? Este es un problema de toda la industria, y Jina AI ha estado trabajando muy duro para resolverlo. Hoy, con la nueva función de anclaje de búsqueda de Jina Reader, puedes simplemente usar https://s.jina.ai/YOUR_SEARCH_QUERY para buscar el conocimiento más reciente del mundo desde la web. Con esto, estás un paso más cerca de mejorar la factualidad de los LLMs, haciendo sus respuestas más confiables y útiles.

API, demo disponible en la página del producto

tagEl Problema de Factualidad de los LLMs

Todos sabemos que los LLMs pueden inventar cosas y dañar la confianza del usuario. Los LLMs pueden decir cosas que no son fácticas (es decir, alucinar), especialmente en temas sobre los que no aprendieron durante el entrenamiento. Esto podría ser información nueva creada desde el entrenamiento o conocimiento específico que ha sido "marginalizado" durante el entrenamiento.

Como resultado, cuando se trata de preguntas como "¿Qué tiempo hace hoy?" o "¿Quién ganó el Oscar a la Mejor Actriz este año?", el modelo responderá "No lo sé" o te dará información desactualizada.

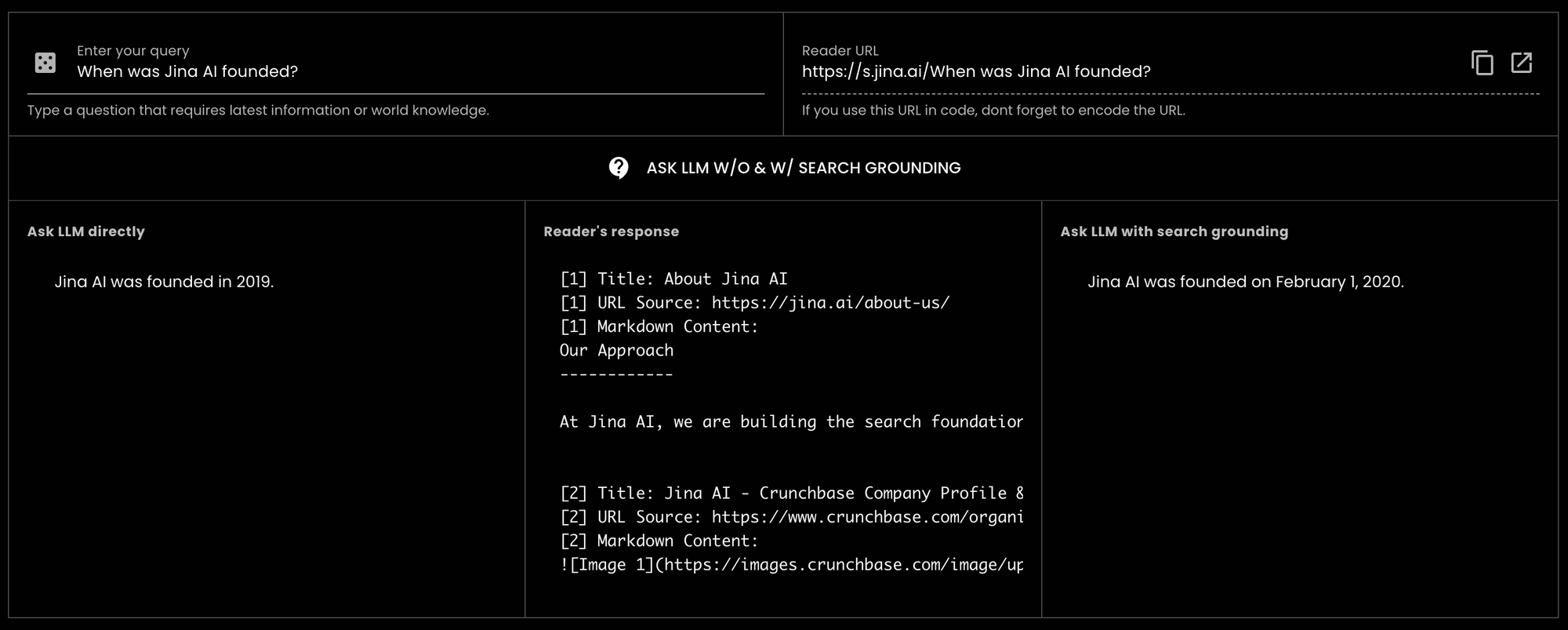

GPT-3.5-turbo "¿Cuándo se fundó Jina AI?" y recibimos una respuesta incorrecta. Sin embargo, al usar Reader para el anclaje de búsqueda, el mismo LLM pudo proporcionar la respuesta correcta. De hecho, fue preciso hasta la fecha exacta.

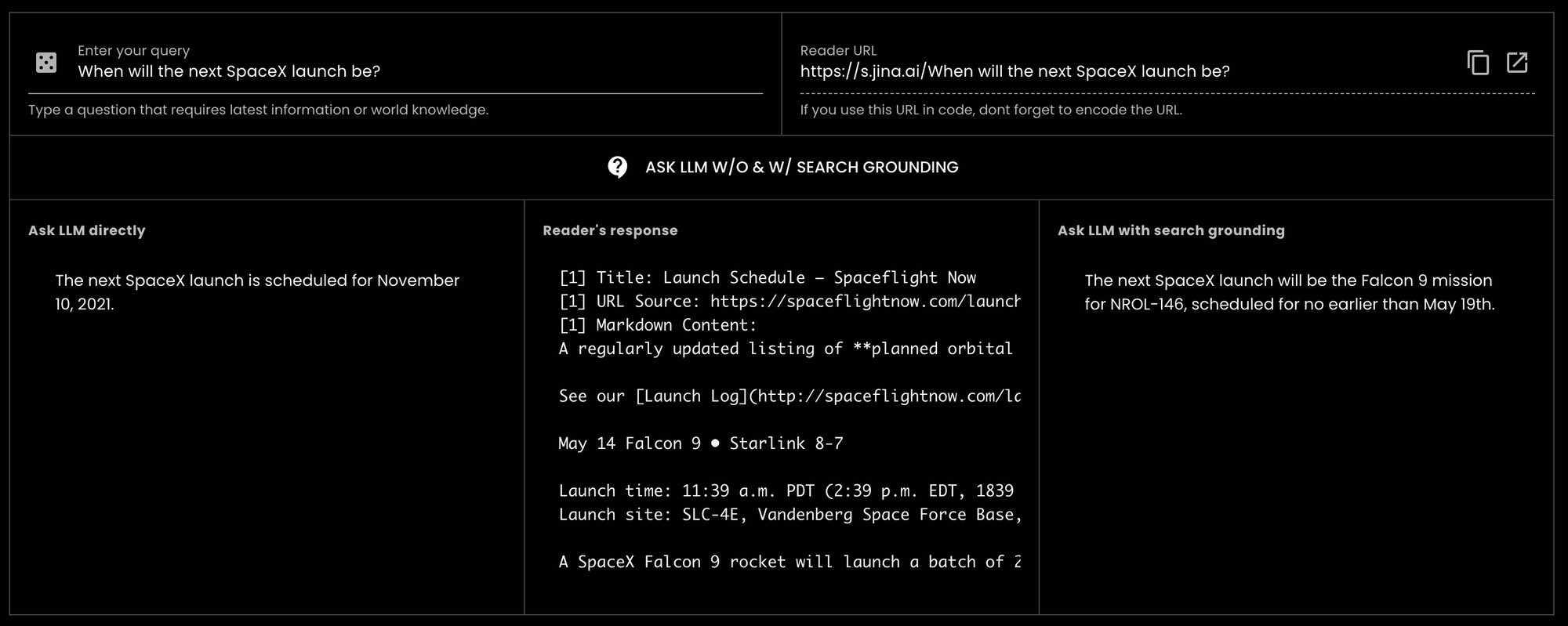

GPT-3.5-turbo "¿Cuándo será el próximo lanzamiento de SpaceX?" (hoy es 14 de mayo de 2024) y el modelo respondió con información antigua de 2021.tagCómo Jina Reader Ayuda a Mejorar el Anclaje

Anteriormente, los usuarios podían fácilmente anteponer https://r.jina.ai para leer contenido de texto e imagen de una URL particular en un formato compatible con LLM y usarlo para verificación de anclaje y verificación de hechos. Desde su primer lanzamiento el 15 de abril, hemos atendido más de 18 millones de solicitudes de todo el mundo, lo que sugiere su popularidad.

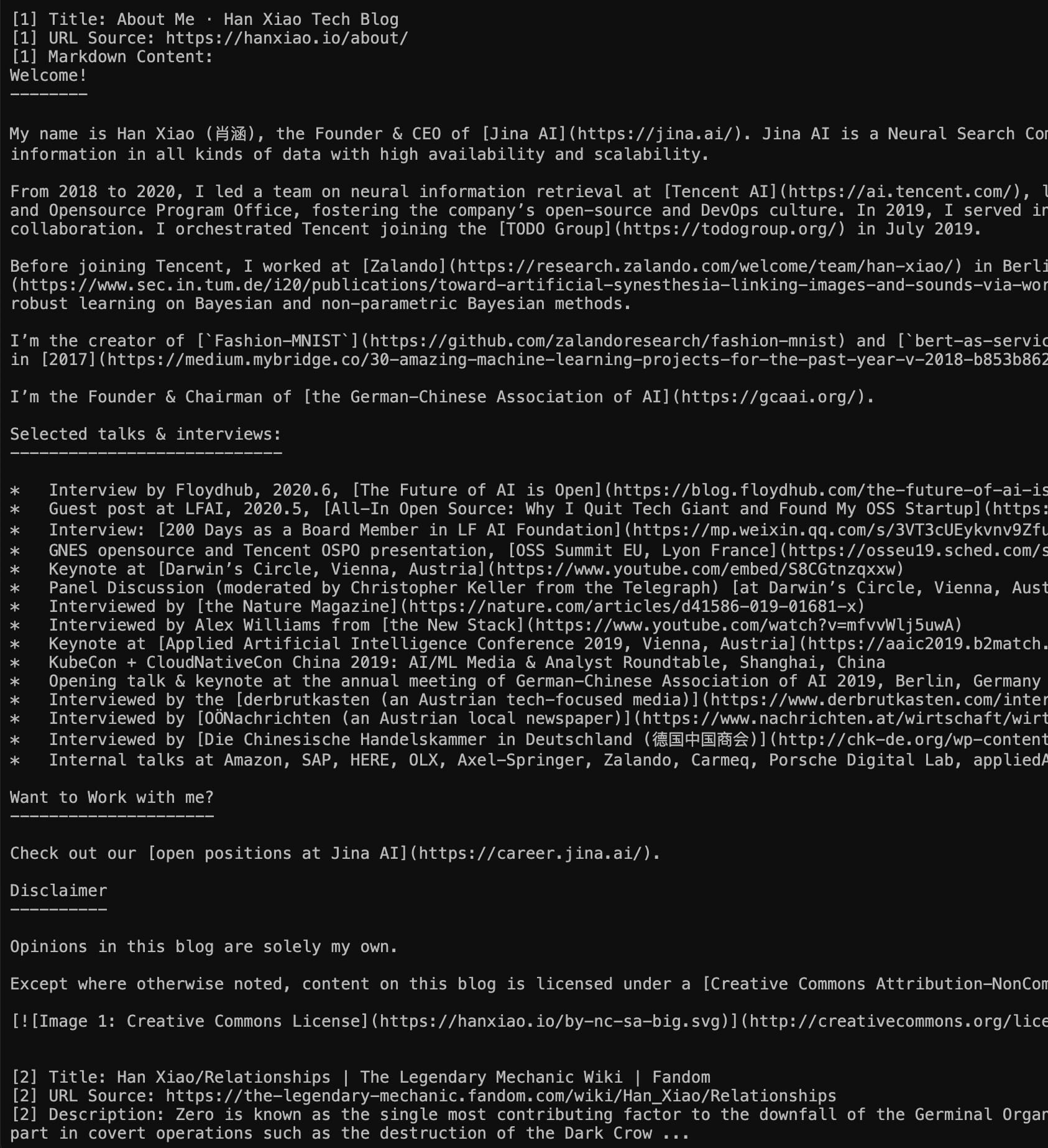

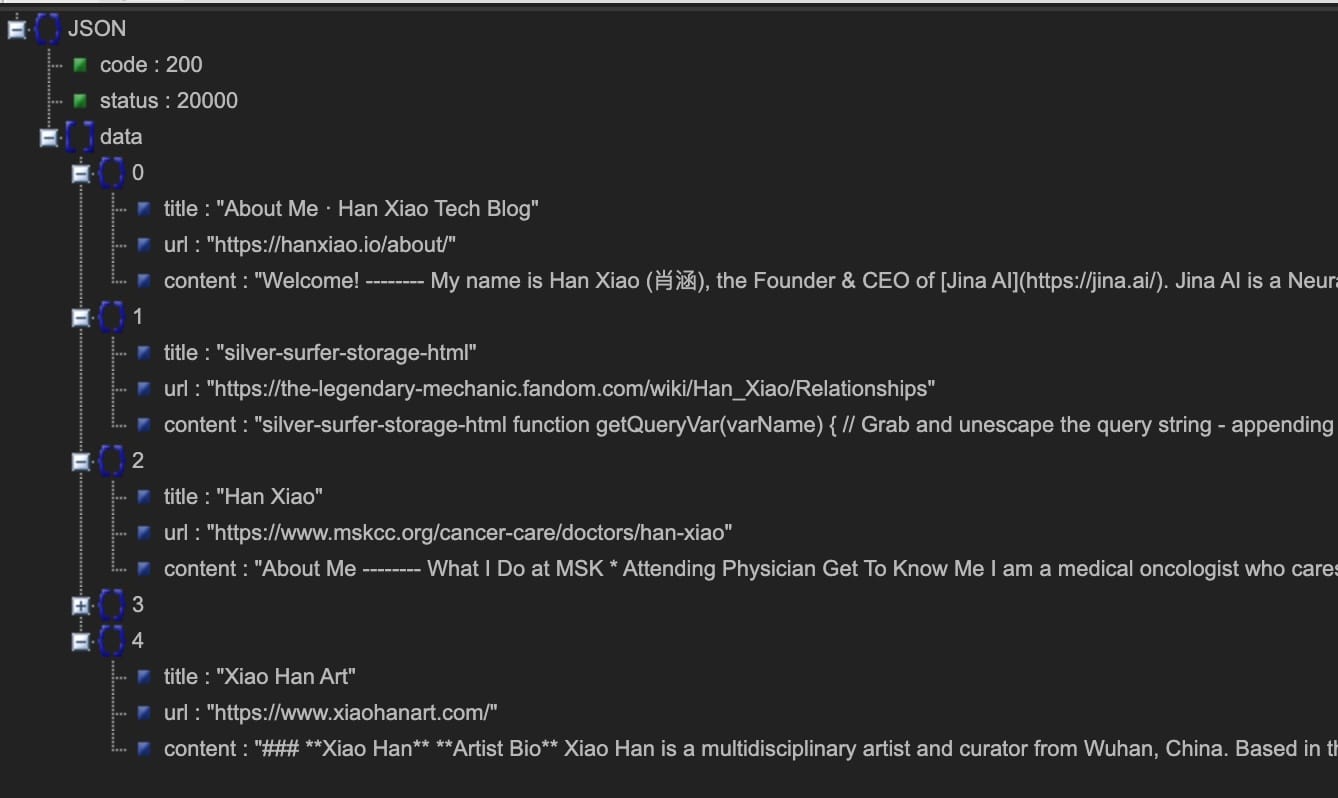

Hoy nos complace avanzar aún más presentando la API de anclaje de búsqueda https://s.jina.ai. Simplemente anteponiendo esto a tu consulta, Reader buscará en la web y recuperará los 5 mejores resultados. Cada resultado incluye un título, markdown compatible con LLM (¡contenido completo! no resumen), y una URL que permite atribuir la fuente. Aquí hay un ejemplo a continuación, también te animamos a probar nuestra demo en vivo aquí.

Izquierda: Modo Markdown (visita directamente https://s.jina.ai/who+is+han+xiao); Derecha modo JSON (usando curl https://s.jina.ai/who+is+han+xiao -H 'accept: application/json'). Por cierto, una pregunta del ego como esta siempre sirve como un buen caso de prueba.

Hay tres principios cuando diseñamos el anclaje de búsqueda en Reader:

- Mejorar la factualidad;

- Acceder a información actualizada, es decir, conocimiento del mundo;

- Conectar una respuesta con su fuente.

Además de ser extremadamente fácil de usar, s.jina.ai también es altamente escalable y personalizable ya que aprovecha la infraestructura flexible y escalable existente de r.jina.ai. Puedes establecer parámetros para controlar el pie de foto de las imágenes, la granularidad del filtro, etc., a través de los encabezados de la solicitud.

tagJina Reader como una Solución Integral de Anclaje

Si combinamos el anclaje de búsqueda (s.jina.ai) y el anclaje de verificación (r.jina.ai), podemos construir una solución de anclaje muy completa para LLMs, agentes y sistemas RAG. En un flujo de trabajo RAG confiable típico, Jina Reader funciona de la siguiente manera:

- El usuario introduce una pregunta;

- Recupera la información más reciente de la web usando

s.jina.ai; - Genera una respuesta inicial con una cita al resultado de búsqueda del último paso;

- Usa

r.jina.aipara fundamentar la respuesta con su propia URL; o leer las URLs incluidas de la fuente devuelta desde el paso 3 para obtener una fundamentación más profunda; - Generación de la respuesta final y resaltado de afirmaciones potencialmente sin fundamento para el usuario.

tagLímites de Tasa Más Altos con API Keys

Los usuarios pueden disfrutar del nuevo endpoint de búsqueda fundamentada de forma gratuita sin autorización. Además, al proporcionar una API key de Jina AI en el encabezado de la solicitud (la misma clave puede usarse en la API de Embedding/Reranking), puedes disfrutar inmediatamente de 200 solicitudes por minuto por IP para r.jina.ai y 40 solicitudes por minuto por IP para s.jina.ai. Los detalles se pueden encontrar en la tabla a continuación:

| Endpoint | Descripción | Límite de tasa sin API key | Límite de tasa con API key | Esquema de conteo de tokens | Latencia promedio |

|---|---|---|---|---|---|

r.jina.ai | Lee una URL y devuelve su contenido, útil para verificar fundamentación | 20 RPM | 200 RPM | Basado en los tokens de salida | 3 segundos |

s.jina.ai | Búsqueda en la web devuelve los 5 mejores resultados, útil para fundamentación de búsqueda | 5 RPM | 40 RPM | Basado en los tokens de salida para los 5 resultados de búsqueda | 30 segundos |

tagConclusión

Creemos que la fundamentación es esencial para las aplicaciones GenAI, y construir soluciones fundamentadas debería ser fácil para todos. Por eso introdujimos el nuevo endpoint de búsqueda fundamentada, s.jina.ai, que permite a los desarrolladores incorporar fácilmente el conocimiento del mundo en sus aplicaciones GenAI. Queremos que los desarrolladores establezcan la confianza del usuario, proporcionen respuestas explicables e inspiren curiosidad en millones de usuarios.