Choisissez les modèles à comparer

Publications (3)

Aperçu

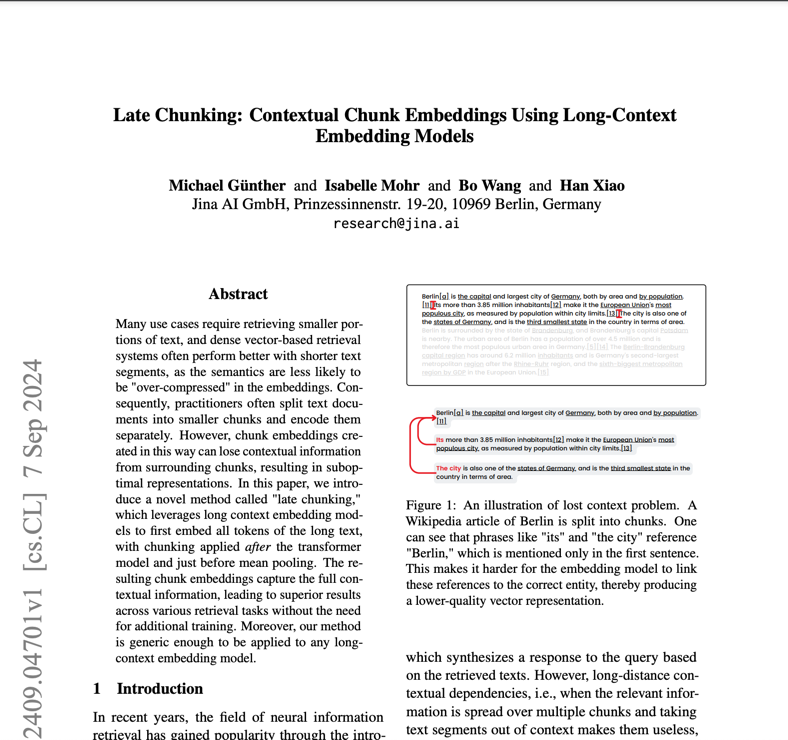

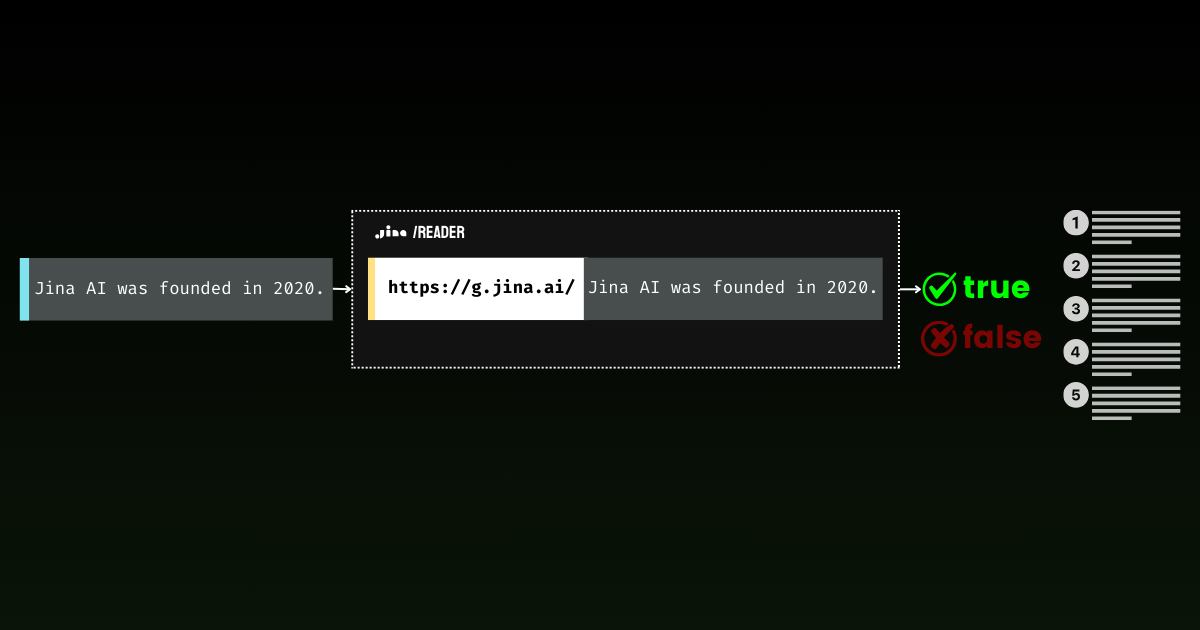

Jina Embeddings v2 Base English est un modèle d'intégration de texte open source révolutionnaire qui résout le défi crucial du traitement de longs documents tout en maintenant une grande précision. Les organisations qui ont du mal à analyser des documents juridiques, des articles de recherche ou des rapports financiers volumineux trouveront ce modèle particulièrement utile. Il se distingue par la gestion de documents d'une longueur maximale de 8 192 jetons, soit 16 fois plus que les modèles traditionnels, tout en égalant les performances des solutions propriétaires d'OpenAI. Avec une taille compacte de 0,27 Go et une utilisation efficace des ressources, il offre une solution accessible aux équipes cherchant à mettre en œuvre une analyse avancée des documents sans surcharge de calcul excessive.

Méthodes

L'architecture du modèle combine une dorsale BERT Small avec un mécanisme innovant bidirectionnel symétrique ALiBi (Attention with Linear Biases), éliminant ainsi le besoin d'intégrations positionnelles traditionnelles. Ce choix architectural permet au modèle d'extrapoler bien au-delà de sa longueur d'entraînement de 512 jetons, en gérant des séquences allant jusqu'à 8 192 jetons sans dégradation des performances. Le processus de formation comportait deux phases clés : une pré-formation initiale sur l'ensemble de données C4, suivie d'un affinement sur la collection organisée par Jina AI de plus de 40 ensembles de données spécialisés. Ces données de formation diverses, comprenant des exemples négatifs difficiles et des paires de phrases variées, garantissent des performances robustes dans différents domaines et cas d'utilisation. Le modèle produit des vecteurs denses de 768 dimensions qui capturent des relations sémantiques nuancées, obtenues avec un nombre relativement modeste de 137 millions de paramètres.

Performance

Lors de tests en conditions réelles, Jina Embeddings v2 Base English démontre des capacités exceptionnelles dans plusieurs tests de performance. Il surpasse le text-embedding-ada-002 d'OpenAI dans plusieurs indicateurs clés : classification (73,45 % contre 70,93 %), reclassement (85,38 % contre 84,89 %), récupération (56,98 % contre 56,32 %) et résumé (31,6 % contre 30,8 %). Ces chiffres se traduisent par des avantages pratiques dans des tâches telles que la classification de documents, où le modèle montre une capacité supérieure à catégoriser des textes complexes, et dans les applications de recherche, où il comprend mieux les requêtes des utilisateurs et trouve des documents pertinents. Cependant, les utilisateurs doivent noter que les performances peuvent varier lorsqu'il s'agit de contenu hautement spécialisé dans un domaine spécifique non représenté dans les données de formation.

Conseils

Pour déployer efficacement Jina Embeddings v2 Base English, les équipes doivent prendre en compte plusieurs aspects pratiques. Le modèle nécessite du matériel compatible CUDA pour des performances optimales, mais son architecture performante lui permet de fonctionner sur des GPU grand public. Il est disponible via plusieurs canaux : téléchargement direct depuis Hugging Face, déploiement sur AWS Marketplace ou via l'API Jina AI avec 10 millions de jetons gratuits. Pour les déploiements en production, AWS SageMaker dans la région US-East-1 offre la solution la plus évolutive. Ce modèle excelle dans l'analyse de texte à usage général, mais peut ne pas être le meilleur choix pour une terminologie scientifique hautement spécialisée ou un jargon spécifique à un domaine sans ajustement précis. Lors du traitement de documents longs, pensez à les décomposer en blocs sémantiques pertinents plutôt que de les diviser arbitrairement afin de préserver l'intégrité du contexte. Pour des résultats optimaux, mettez en œuvre un prétraitement de texte approprié et assurez-vous que les données d'entrée sont propres et bien formatées.

Blogs qui mentionnent ce modèle