Disponible via

Graphique d'E/S

Choisissez les modèles à comparer

Publications (3)

Aperçu

Jina Embeddings v3 est un modèle d'intégration de texte multilingue révolutionnaire qui transforme la façon dont les organisations gèrent la compréhension et la récupération de texte dans plusieurs langues. Fondamentalement, il résout le défi crucial de maintenir des performances élevées dans plusieurs langues et tâches tout en gardant les exigences de calcul gérables. Le modèle excelle particulièrement dans les environnements de production où l'efficacité est importante : il atteint des performances de pointe avec seulement 570 millions de paramètres, ce qui le rend accessible aux équipes qui ne peuvent pas se permettre la surcharge de calcul de modèles plus volumineux. Les organisations qui ont besoin de créer des systèmes de recherche multilingues évolutifs ou d'analyser du contenu au-delà des barrières linguistiques trouveront ce modèle particulièrement utile.

Méthodes

L'architecture du modèle représente une innovation significative dans la technologie d'intégration, construite sur une base jina-XLM-RoBERTa avec 24 couches et améliorée avec des adaptateurs d'adaptation de faible rang (LoRA) spécifiques aux tâches. Les adaptateurs LoRA sont des composants de réseau neuronal spécialisés qui optimisent le modèle pour différentes tâches telles que la récupération, la classification ou le clustering sans augmenter de manière significative le nombre de paramètres - ils ajoutent moins de 3 % au total des paramètres. Le modèle intègre Matryoshka Representation Learning (MRL), permettant de réduire de manière flexible les intégrations de 1024 à 32 dimensions tout en préservant les performances. La formation impliquait un processus en trois étapes : pré-formation initiale sur du texte multilingue de 89 langues, réglage fin sur des textes appariés pour la qualité de l'intégration et formation d'adaptateur spécialisé pour l'optimisation des tâches. Le modèle prend en charge des longueurs de contexte jusqu'à 8 192 jetons via Rotary Position Embeddings (RoPE), avec une technique innovante d'ajustement de fréquence de base qui améliore les performances sur les textes courts et longs.

Performance

Le modèle démontre un rapport efficacité/performance exceptionnel dans les tests en conditions réelles, surpassant à la fois les alternatives open source et les solutions propriétaires d'OpenAI et de Cohere sur les tâches en anglais tout en excellant dans les scénarios multilingues. Plus surprenant encore, il obtient de meilleurs résultats que e5-mistral-7b-instruct, qui possède 12 fois plus de paramètres, ce qui met en évidence son efficacité remarquable. Dans les évaluations de référence MTEB, il obtient un score moyen de 65,52 sur toutes les tâches, avec des performances particulièrement élevées en matière de précision de classification (82,58) et de similarité de phrases (85,80). Le modèle maintient des performances constantes dans toutes les langues, obtenant un score de 64,44 sur les tâches multilingues. Lorsqu'il utilise MRL pour la réduction des dimensions, il conserve de bonnes performances même à des dimensions inférieures - par exemple, en maintenant 92 % de ses performances de récupération à 64 dimensions par rapport aux 1024 dimensions complètes.

Conseils

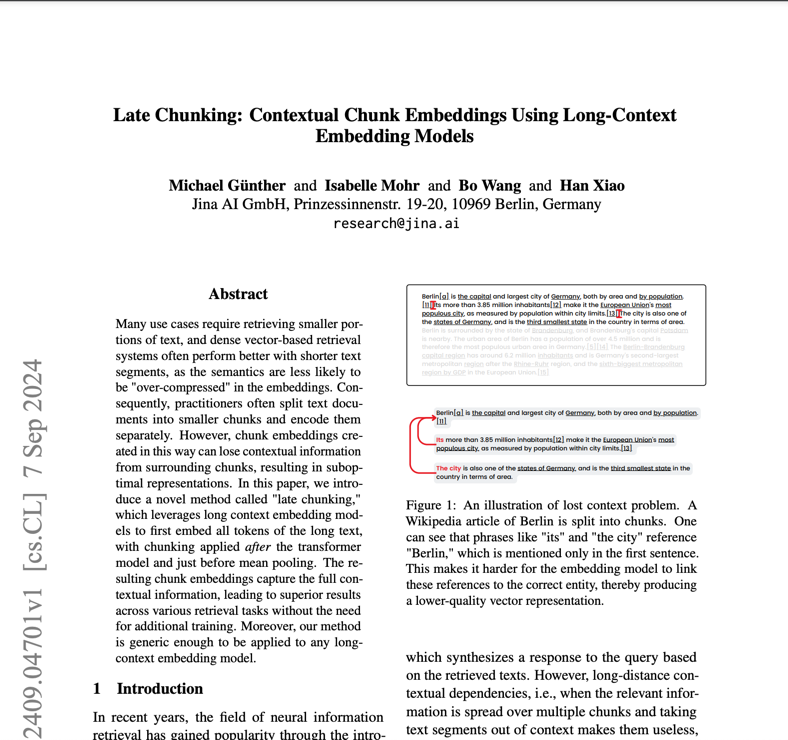

Pour déployer efficacement Jina Embeddings v3, les équipes doivent tenir compte de leur cas d'utilisation spécifique pour sélectionner l'adaptateur de tâches approprié : retrieval.query et retrieval.passage pour les applications de recherche, séparation pour les tâches de clustering, classification pour la catégorisation et correspondance de texte pour la similarité sémantique. Le modèle nécessite un matériel compatible CUDA pour des performances optimales, bien que son architecture efficace signifie qu'il nécessite beaucoup moins de mémoire GPU que des alternatives plus importantes. Pour le déploiement en production, l'intégration AWS SageMaker offre un chemin simplifié vers l'évolutivité. Le modèle excelle dans les applications multilingues, mais peut nécessiter une évaluation supplémentaire pour les langues à faibles ressources. Bien qu'il prenne en charge les documents longs jusqu'à 8 192 jetons, des performances optimales sont obtenues avec la fonction de segmentation tardive pour les textes très longs. Les équipes doivent éviter d'utiliser le modèle pour des tâches nécessitant une génération en temps réel ou un raisonnement complexe : il est conçu pour l'intégration et la récupération, et non pour la génération de texte ou la réponse directe aux questions.

Blogs qui mentionnent ce modèle