Привязка к источникам абсолютно необходима для приложений GenAI.

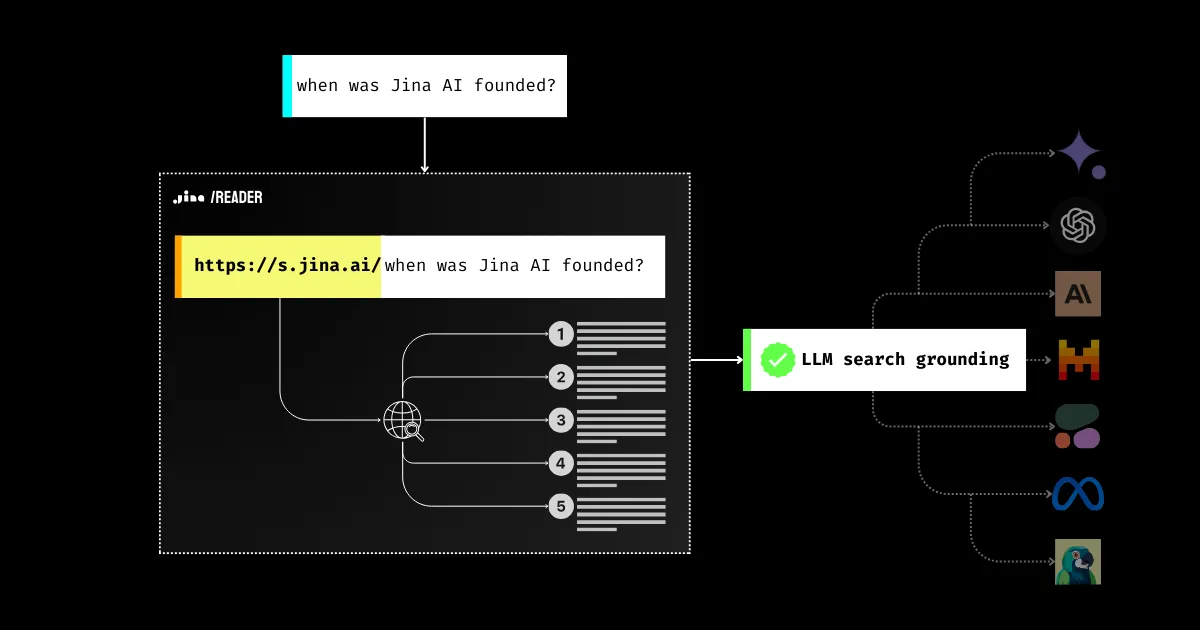

Вы, вероятно, видели множество инструментов, промптов и RAG-конвейеров, разработанных для повышения фактической точности LLM с 2023 года. Почему? Потому что основным барьером, мешающим предприятиям развертывать LLM для миллионов пользователей, является доверие: является ли ответ подлинным или это просто галлюцинация модели? Это проблема всей отрасли, и Jina AI усердно работает над её решением. Сегодня, с новой функцией поисковой привязки Jina Reader, вы можете просто использовать https://s.jina.ai/YOUR_SEARCH_QUERY для поиска актуальных знаний о мире в интернете. С этим вы на шаг ближе к повышению фактической точности LLM, делая их ответы более надежными и полезными.

API, демо можно найти на странице продукта

tagПроблема фактической точности LLM

Мы все знаем, что LLM могут выдумывать вещи и подрывать доверие пользователей. LLM могут говорить вещи, которые не соответствуют действительности (так называемые галлюцинации), особенно в отношении тем, о которых они не узнали во время обучения. Это может быть либо новая информация, появившаяся после обучения, либо узкоспециализированные знания, которые были "маргинализированы" во время обучения.

В результате, когда речь идет о таких вопросах, как "Какая сегодня погода?" или "Кто получил Оскар за лучшую женскую роль в этом году?", модель либо ответит "Я не знаю", либо даст устаревшую информацию.

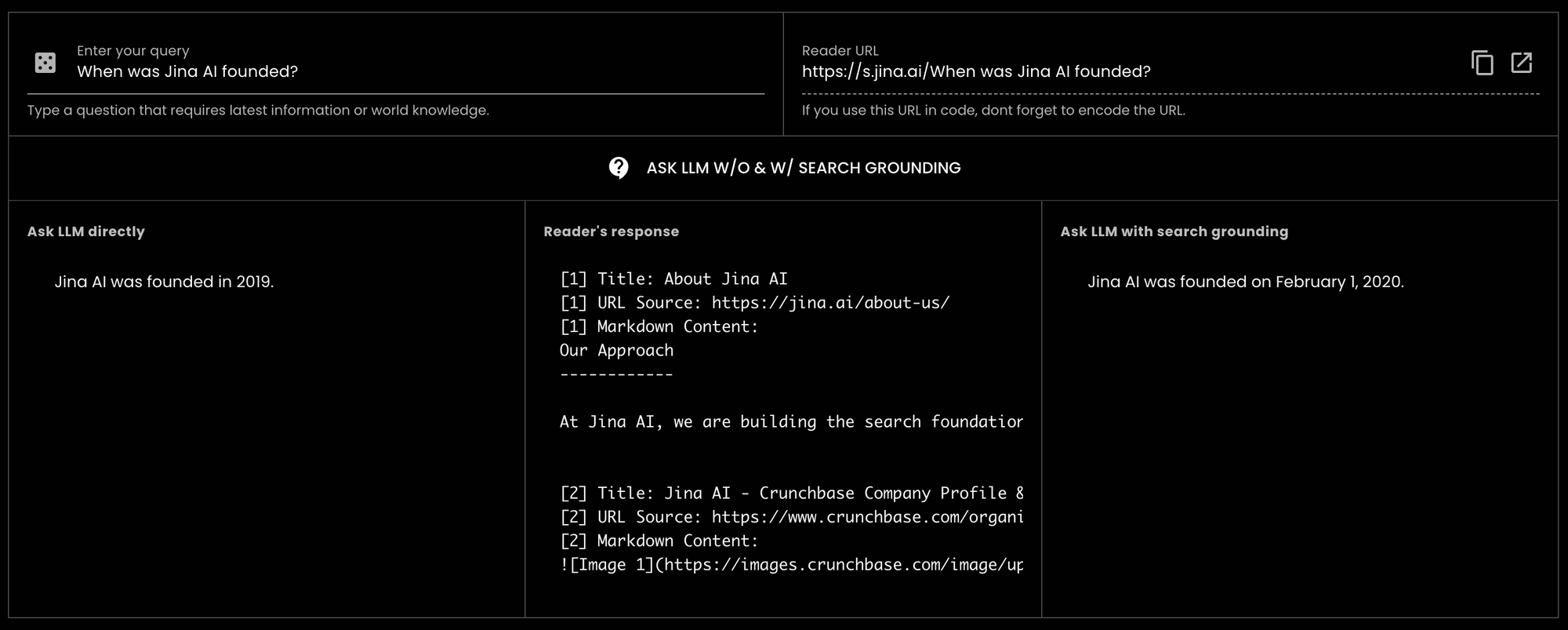

GPT-3.5-turbo "Когда была основана Jina AI?" и получили неверный ответ. Однако при использовании Reader для поисковой привязки та же LLM смогла дать правильный ответ. Фактически, она указала точную дату.

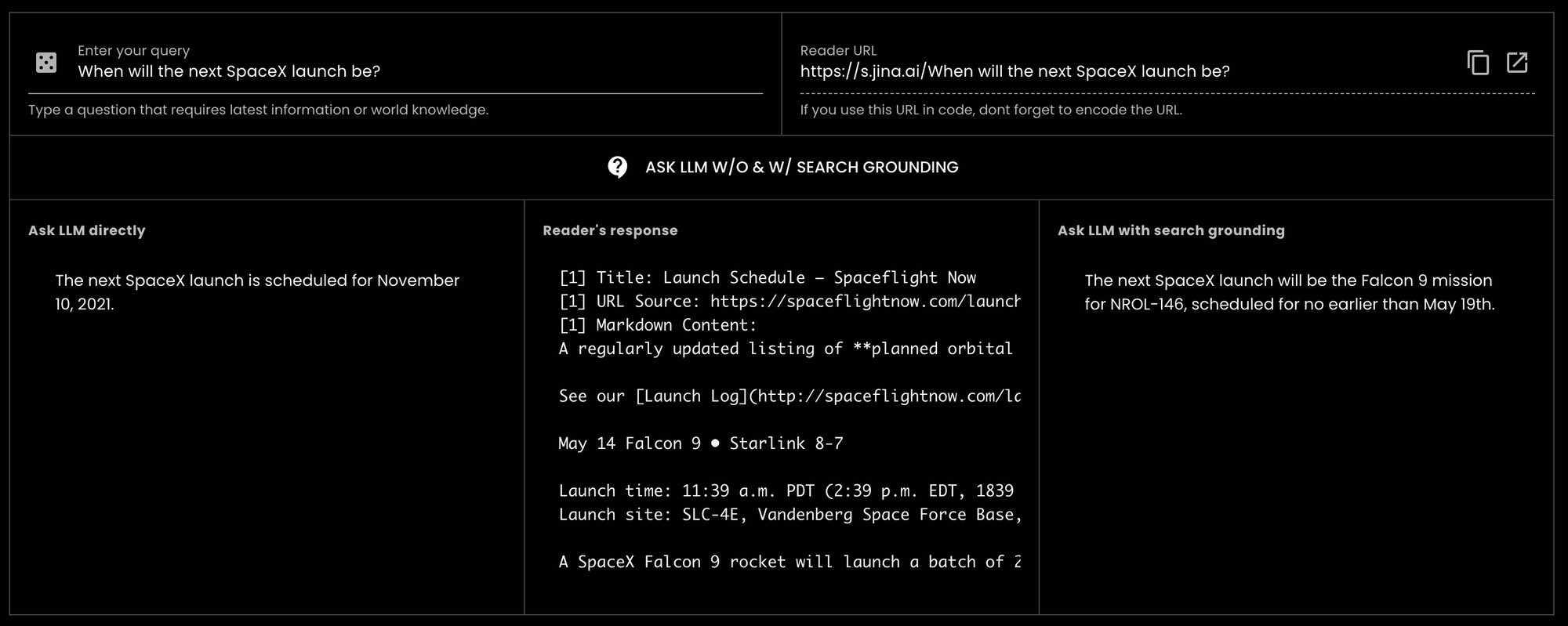

GPT-3.5-turbo "Когда будет следующий запуск SpaceX?" (сегодня 14 мая 2024 года), и модель ответила устаревшей информацией 2021 года.tagКак Jina Reader помогает улучшить привязку к источникам

Ранее пользователи могли легко добавлять префикс https://r.jina.ai, чтобы считывать текстовое и графическое содержимое с определенного URL в LLM-совместимый формат и использовать его для проверки и верификации фактов. С момента первого релиза 15 апреля мы обработали более 18 миллионов запросов со всего мира, что говорит о его популярности.

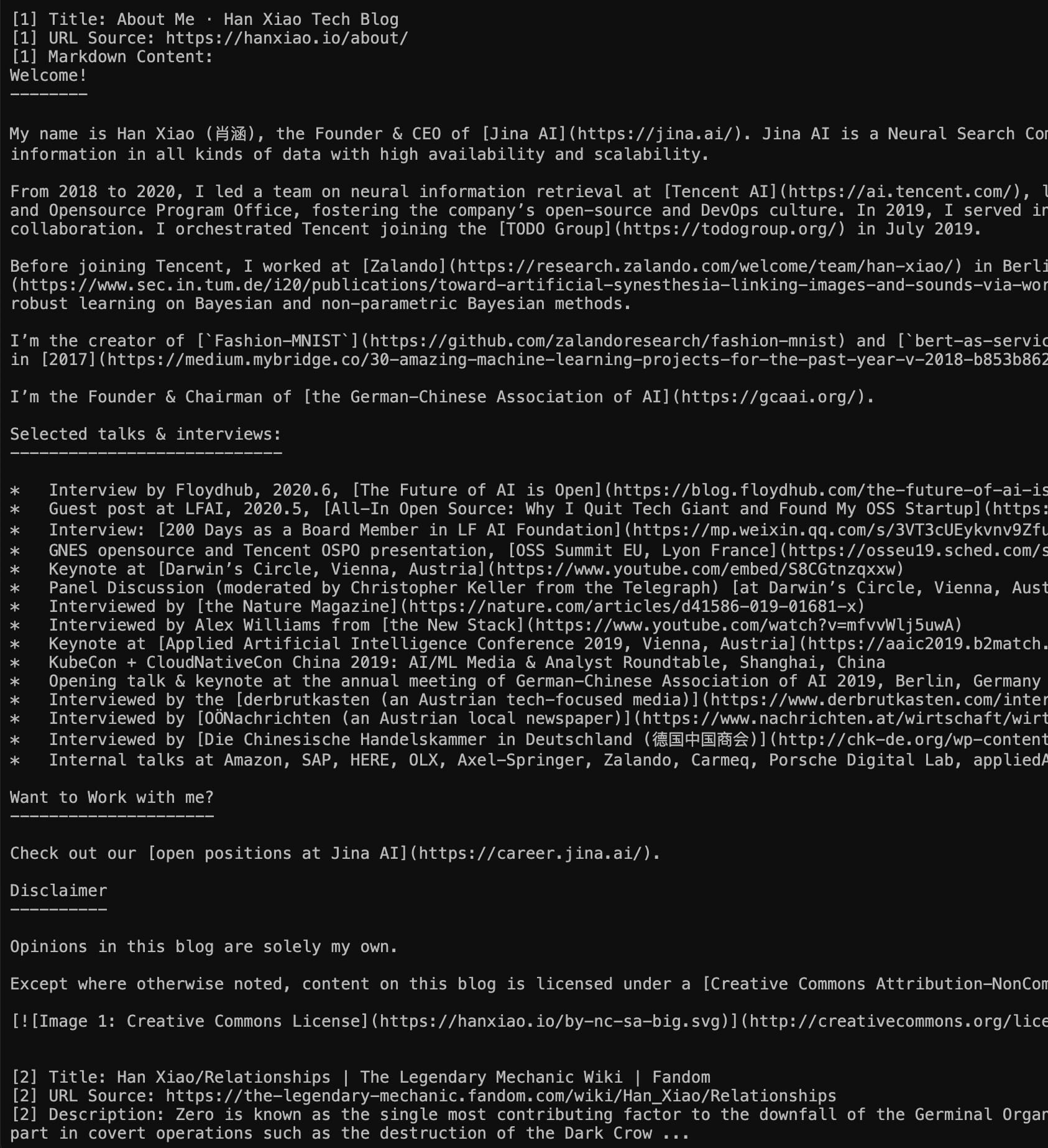

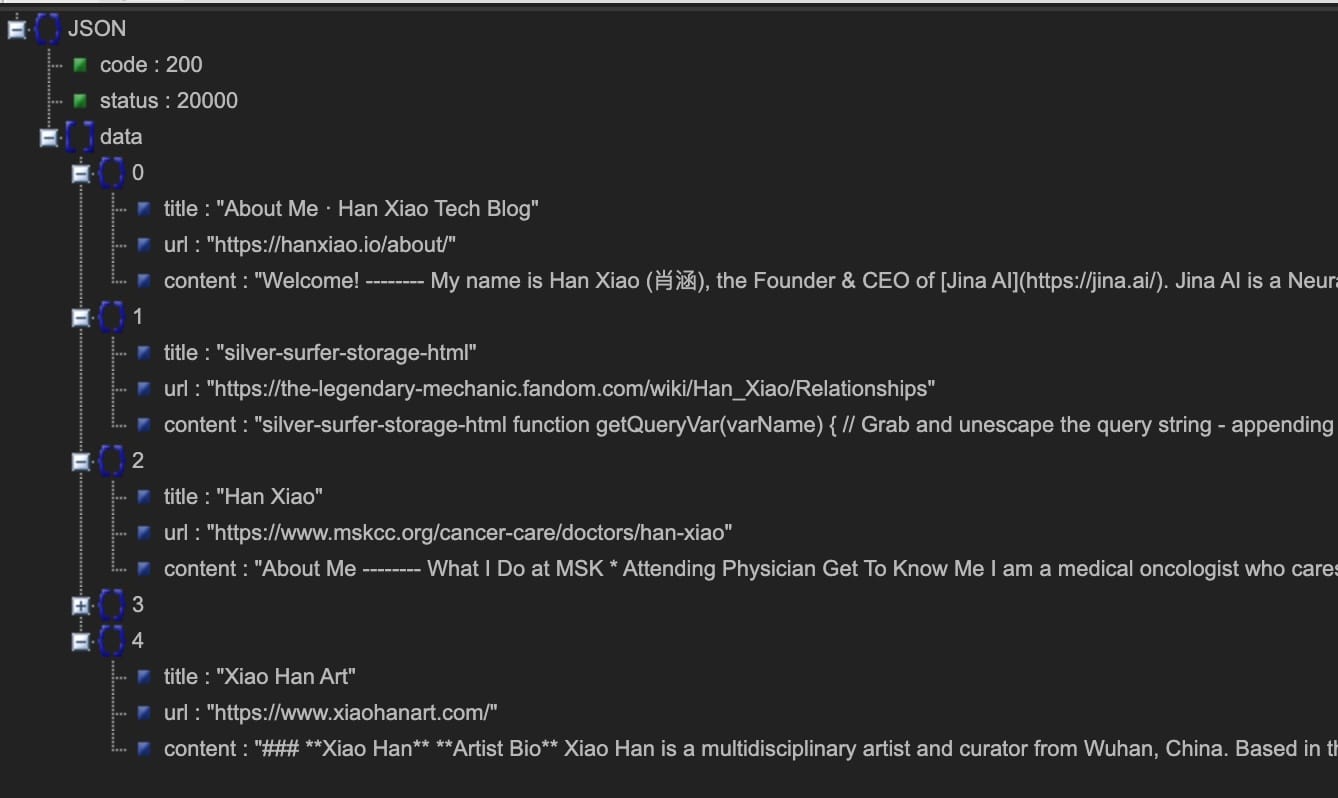

Сегодня мы рады сделать следующий шаг, представляя API поисковой привязки https://s.jina.ai. Просто добавив его перед вашим запросом, Reader будет искать в интернете и извлекать 5 лучших результатов. Каждый результат включает заголовок, LLM-совместимый markdown (полное содержание! не аннотацию) и URL, который позволяет указать источник. Вот пример ниже, вы также можете попробовать наше живое демо здесь.

Слева: Режим Markdown (прямой переход по https://s.jina.ai/who+is+han+xiao); Справа режим JSON (используя curl https://s.jina.ai/who+is+han+xiao -H 'accept: application/json'). Кстати, такой эгоистичный вопрос всегда служит хорошим тестовым случаем.

При разработке поисковой привязки в Reader мы руководствовались тремя принципами:

- Повышение фактической точности;

- Доступ к актуальной информации, т.е. знаниям о мире;

- Связывание ответа с его источником.

Помимо крайней простоты использования, s.jina.ai также хорошо масштабируется и настраивается, поскольку использует существующую гибкую и масштабируемую инфраструктуру r.jina.ai. Вы можете установить параметры для управления подписями к изображениям, гранулярностью фильтрации и т.д. через заголовки запросов.

tagJina Reader как комплексное решение для привязки к источникам

Если мы объединим поисковую привязку (s.jina.ai) и проверочную привязку (r.jina.ai), мы можем создать очень комплексное решение для привязки к источникам для LLM, агентов и RAG-систем. В типичном надежном RAG-рабочем процессе Jina Reader работает следующим образом:

- Пользователь вводит вопрос;

- Получение актуальной информации из интернета с помощью

s.jina.ai; - Генерация первоначального ответа со ссылкой на результат поиска из предыдущего шага;

- Использование

r.jina.aiдля подтверждения ответа с помощью вашего собственного URL; или прочитайте URL-адреса из источника, полученного на шаге 3, чтобы получить более глубокое обоснование; - Генерация окончательного ответа и выделение потенциально необоснованных утверждений для пользователя.

tagПовышенный лимит запросов с API-ключами

Пользователи могут бесплатно использовать новую конечную точку поискового обоснования без авторизации. Более того, при указании API-ключа Jina AI в заголовке запроса (тот же ключ можно использовать в API для Embedding/Reranking), вы сразу получаете 200 запросов в минуту с одного IP для r.jina.ai и 40 запросов в минуту с одного IP для s.jina.ai. Подробности можно найти в таблице ниже:

| Конечная точка | Описание | Лимит запросов без API-ключа | Лимит запросов с API-ключом | Схема подсчета токенов | Средняя задержка |

|---|---|---|---|---|---|

r.jina.ai | Чтение URL и возврат его содержимого, полезно для проверки обоснования | 20 RPM | 200 RPM | На основе выходных токенов | 3 секунды |

s.jina.ai | Поиск в интернете с возвратом топ-5 результатов, полезно для поискового обоснования | 5 RPM | 40 RPM | На основе выходных токенов для всех 5 результатов поиска | 30 секунд |

tagЗаключение

Мы считаем, что обоснование крайне важно для GenAI-приложений, и создание обоснованных решений должно быть простым для каждого. Именно поэтому мы представили новую конечную точку поискового обоснования, s.jina.ai, которая позволяет разработчикам легко интегрировать мировые знания в свои GenAI-приложения. Мы хотим, чтобы разработчики укрепляли доверие пользователей, предоставляли объяснимые ответы и вдохновляли миллионы пользователей на любознательность.