选择要比较的模型

出版物 (3)

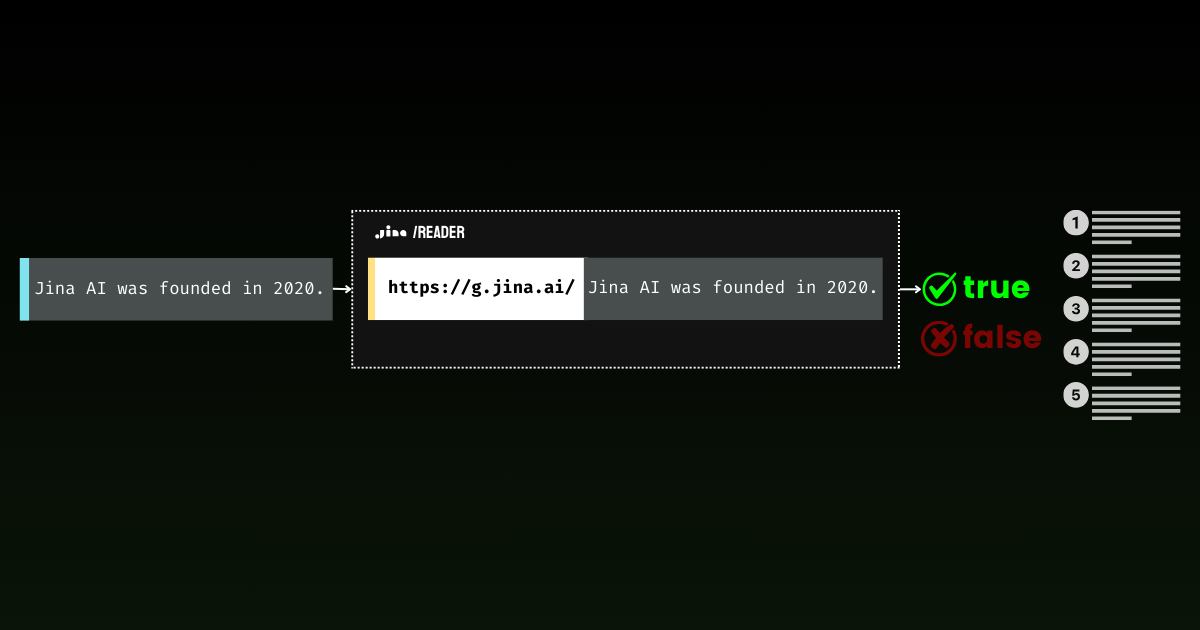

概述

Jina Embeddings v2 Base English 是一种突破性的开源文本向量模型,它解决了处理长文档同时保持高准确率的关键挑战。那些难以分析大量法律文件、研究论文或财务报告的组织会发现这个模型特别有价值。它以处理长度高达 8,192 个词元的文档而脱颖而出——比传统模型长 16 倍——同时性能与 OpenAI 的专有解决方案相匹配。它体积小巧,仅为 0.27GB,资源利用率高,为寻求实施高级文档分析而无需过多计算开销的团队提供了一个可访问的解决方案。

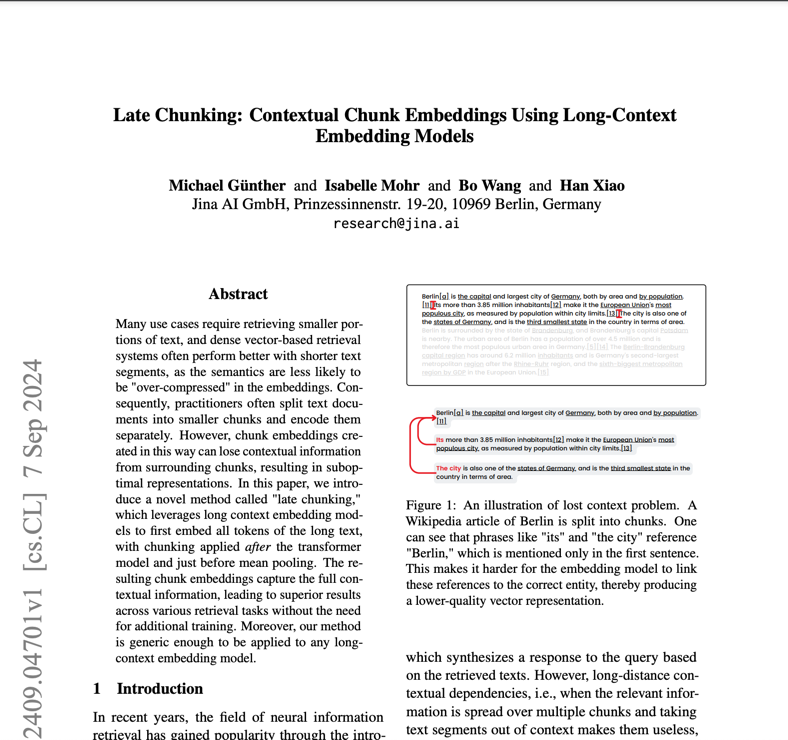

方法

该模型的架构将 BERT Small 主干与创新的对称双向 ALiBi(具有线性偏差的注意力机制)机制相结合,消除了对传统位置向量的需求。这种架构选择使模型能够推断出远远超出其 512 个词元的训练长度,处理多达 8,192 个词元的序列而不会降低性能。训练过程涉及两个关键阶段:在 C4 数据集上进行初始预训练,然后在 Jina AI 精选的 40 多个专业数据集上进行细化。这些多样化的训练数据(包括具有挑战性的负面示例和不同的句子对)确保了在不同领域和用例中的稳健性能。该模型生成 768 维密集向量,可捕捉细微的语义关系,使用相对适中的 137M 个参数实现。

性能

在实际测试中,Jina Embeddings v2 Base English 在多个基准测试中展现出卓越的能力。它在几个关键指标上都优于 OpenAI 的 text-embedding-ada-002:分类(73.45% vs 70.93%)、重排(85.38% vs 84.89%)、检索(56.98% vs 56.32%)和摘要(31.6% vs 30.8%)。这些数字在文档分类等任务中转化为实际优势,其中模型显示出对复杂文本进行分类的卓越能力,并在搜索应用中,它更好地理解用户查询并找到相关文档。但是,用户应注意,在处理训练数据中未表示的高度专业化领域特定内容时,性能可能会有所不同。

最佳实践

为了有效部署 Jina Embeddings v2 Base English,团队应考虑几个实际方面。该模型需要支持 CUDA 的硬件才能获得最佳性能,但其高效的架构意味着它可以在消费级 GPU 上运行。它可通过多种渠道获得:直接从 Hugging Face 下载、AWS Marketplace 部署或带有 1000 万个免费词元的 Jina AI API。对于生产部署,us-east-1 区域中的 AWS SageMaker 提供了最具可扩展性的解决方案。该模型擅长通用文本分析,但对于未经微调的高度专业化的科学术语或领域特定术语,可能不是最佳选择。处理长文档时,请考虑将它们分解为有意义的语义块,而不是任意拆分以保持上下文完整性。为获得最佳结果,请实施适当的文本预处理并确保输入数据干净、格式良好。

提及此模型的博客