I/O 图

选择要比较的模型

出版物 (3)

概述

Jina Embeddings v3 是一种突破性的多语言文本向量模型,它改变了组织处理跨语言文本理解和检索的方式。从本质上讲,它解决了在多种语言和任务中保持高性能,同时保持计算要求可控的关键挑战。该模型在效率至关重要的生产环境中尤其出色 - 它仅用 5.7 亿个参数就实现了最先进的性能,这使得无法承担较大模型计算开销的团队也可以使用它。需要构建可扩展的多语言搜索系统或跨语言障碍分析内容的组织会发现这个模型特别有价值。

方法

该模型的架构代表了向量技术的重大创新,它建立在具有 24 层的 jina-XLM-RoBERTa 基础上,并通过特定于任务的低秩自适应 (LoRA) 适配器进行了增强。LoRA 适配器是专门的神经网络组件,可针对不同的任务(如检索、分类或聚类)优化模型,而不会显着增加参数数量 - 它们使总参数增加不到 3%。该模型结合了 Matryoshka 表示学习 (MRL),允许将向量从 1024 维灵活地减少到 32 维,同时保持性能。训练涉及三个阶段:对来自 89 种语言的多语言文本进行初始预训练,对成对文本进行微调以提高向量质量,以及专门的适配器训练以优化任务。该模型通过旋转位置向量 (RoPE) 支持高达 8,192 个词元的上下文长度,并采用创新的基频调整技术来提高短文本和长文本的性能。

性能

该模型在实际测试中展现出卓越的效率性能比,在英语任务上的表现优于开源替代方案以及来自 OpenAI 和 Cohere 的专有解决方案,同时在多语言场景中也表现出色。最令人惊讶的是,它取得了比参数多 12 倍的 e5-mistral-7b-instruct 更好的结果,凸显了其卓越的效率。在 MTEB 基准评估中,它在所有任务中获得了 65.52 的平均分数,在分类准确率(82.58)和句子相似度(85.80)方面表现尤为出色。该模型在不同语言中保持一致的性能,在多语言任务上的得分为 64.44。当使用 MRL 进行降维时,即使在较低维度下也能保持强劲性能 - 例如,与完整的 1024 维相比,64 维可以保持 92% 的检索性能。

最佳实践

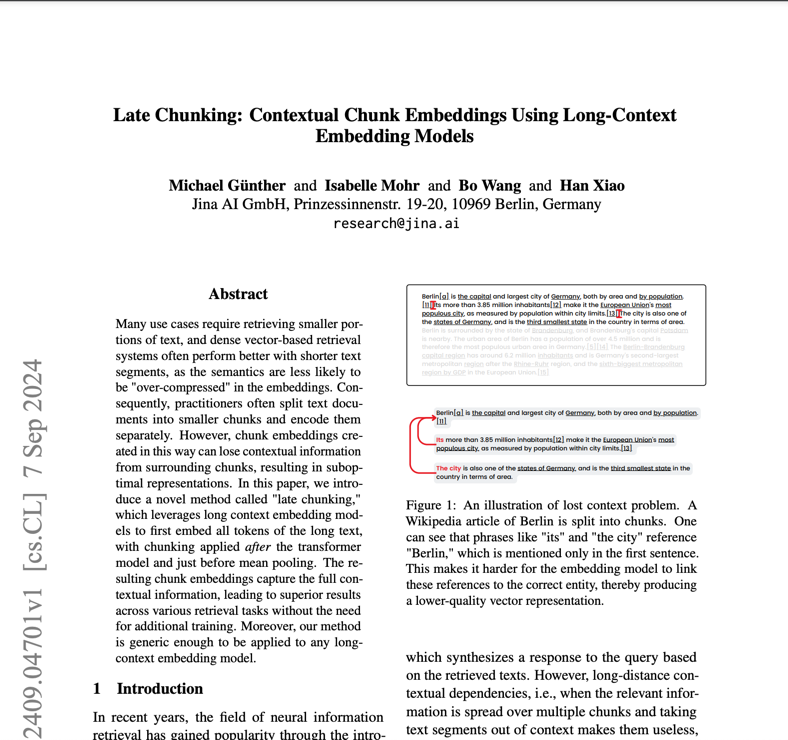

为了有效部署 Jina Embeddings v3,团队应考虑其特定用例以选择适当的任务适配器:搜索应用程序使用 retrieval.query 和 retrieval.passage,聚类任务使用分离,分类使用分类,语义相似性使用文本匹配。该模型需要具有 CUDA 功能的硬件才能获得最佳性能,但其高效的架构意味着它所需的 GPU 内存比更大的替代方案少得多。对于生产部署,AWS SageMaker 集成提供了一条简化的可扩展性路径。该模型在多语言应用程序中表现出色,但对于资源匮乏的语言可能需要额外的评估。虽然它支持多达 8,192 个词元的长文档,但对于非常长的文本,使用迟分技术功能可实现最佳性能。团队应避免将该模型用于需要实时生成或复杂推理的任务 - 它是为向量和检索而设计的,而不是文本生成或直接问答。

提及此模型的博客