選擇要比較的模型

論文 (3)

概述

Jina Embeddings v2 Base English 是一種突破性的開源文本向量模型,它解決了處理長文檔同時保持高準確率的關鍵挑戰。那些難以分析大量法律文件、研究論文或財務報告的組織會發現這個模型特別有價值。它以處理長度高達 8,192 個詞元的文檔而脱穎而出——比傳統模型長 16 倍——同時性能與 OpenAI 的專有解決方案相匹配。它體積小巧,僅為 0.27GB,資源利用率高,為尋求實施高級文檔分析而無需過多計算開銷的團隊提供了一個可訪問的解決方案。

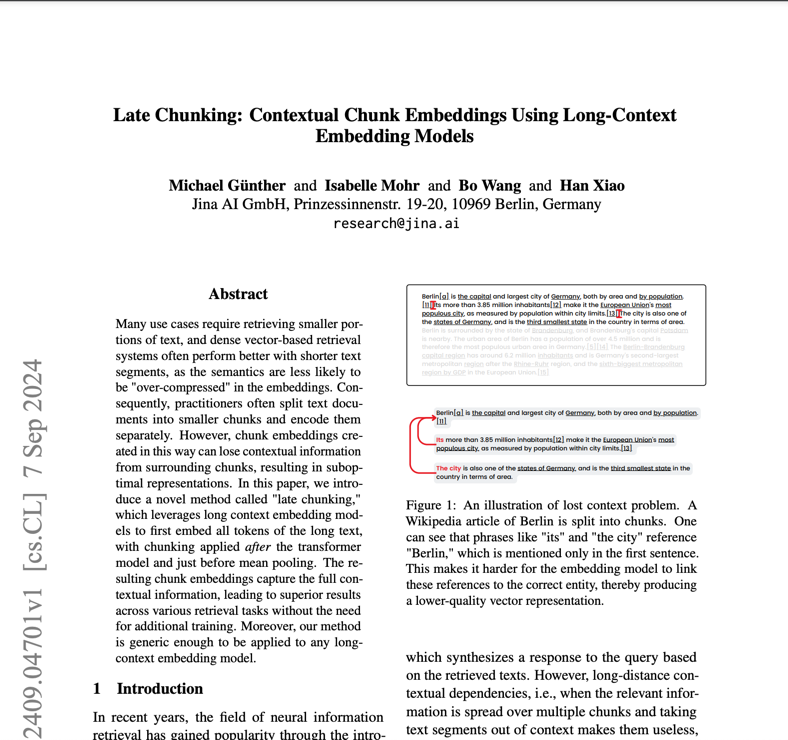

方法

該模型的架構將 BERT Small 主幹與創新的對稱雙向 ALiBi(具有線性偏差的注意力機制)機制相結合,消除了對傳統位置向量的需求。這種架構選擇使模型能夠推斷出遠遠超出其 512 個詞元的訓練長度,處理多達 8,192 個詞元的序列而不會降低性能。訓練過程涉及兩個關鍵階段:在 C4 數據集上進行初始預訓練,然後在 Jina AI 精選的 40 多個專業數據集上進行細化。這些多樣化的訓練數據(包括具有挑戰性的負面示例和不同的句子對)確保了在不同領域和用例中的穩健性能。該模型生成 768 維密集向量,可捕捉細微的語義關係,使用相對適中的 137M 個參數實現。

性能

在實際測試中,Jina Embeddings v2 Base English 在多個基準測試中展現出卓越的能力。它在幾個關鍵指標上都優於 OpenAI 的 text-embedding-ada-002:分類(73.45% vs 70.93%)、重排(85.38% vs 84.89%)、檢索(56.98% vs 56.32%)和摘要(31.6% vs 30.8%)。這些數字在文檔分類等任務中轉化為實際優勢,其中模型顯示出對複雜文本進行分類的卓越能力,並在搜索應用中,它更好地理解用户查詢並找到相關文檔。但是,用户應注意,在處理訓練數據中未表示的高度專業化領域特定內容時,性能可能會有所不同。

最佳實踐

為了有效部署 Jina Embeddings v2 Base English,團隊應考慮幾個實際方面。該模型需要支持 CUDA 的硬件才能獲得最佳性能,但其高效的架構意味着它可以在消費級 GPU 上運行。它可通過多種渠道獲得:直接從 Hugging Face 下載、AWS Marketplace 部署或帶有 1000 萬個免費詞元的 Jina AI API。對於生產部署,us-east-1 區域中的 AWS SageMaker 提供了最具可擴展性的解決方案。該模型擅長通用文本分析,但對於未經微調的高度專業化的科學術語或領域特定術語,可能不是最佳選擇。處理長文檔時,請考慮將它們分解為有意義的語義塊,而不是任意拆分以保持上下文完整性。為獲得最佳結果,請實施適當的文本預處理並確保輸入數據乾淨、格式良好。

提及此模型的博客